本文主要是介绍nlp事件抽取算例实现:(有完整算例和完整代码),希望对大家解决编程问题提供一定的参考价值,需要的开发者们随着小编来一起学习吧!

定义

事件抽取技术是从非结构化信息中抽取出用户感兴趣的事件,并以结构化呈现给用户。事件抽取任务可分解为4个子任务: 触发词识别、事件类型分类、论元识别和角色分类任务。其中,触发词识别和事件类型分类可合并成事件识别任务。论元识别和角色分类可合并成论元角色分类任务。事件识别判断句子中的每个单词归属的事件类型,是一个基于单词的多分类任务。角色分类任务则是一个基于词对的多分类任务,判断句子中任意一对触发词和实体之间的角色关系。

事件抽取任务:

事件有很多种,如因果事件,转则事件。。。

统一定义:一般一个事件都有事件,地点,人物等因素。

事件抽取就是把这些因素提取出来。

不多讲啦,上算例。

算例:

火灾新闻算例:

一个火灾事件新闻我们感兴趣的是 事故发生时间,事故发生地点,事故伤亡,事故原因。

我们把这些抽取出来.顺便再附上事件摘要。

即输入一个火灾事件新闻,输出 事故地点,事故时间,事故伤亡,事故原因,事故摘要。

方法:基于正则。

导入包:

#!/usr/bin/env python3

# -*- coding: utf-8 -*-

# @Author: yudengwu

# @Date : 2020/6/27

import re

#事故原因:

def pattern_cause(data):"data.type: [文字]"data = str(data)patterns = []key_words = ['起火', '事故', '火灾']pattern = re.compile('.*?(?:{0})原因(.*?)[,.?:;!,。?:;!]'.format('|'.join(key_words)))patterns.append(pattern)for c in patterns:print('事故原因:',c.search(data).group(1))#事故伤亡:

def pattern_lose(data):"data.type: [文字]"data = str(data)patterns = []key_words = ['伤亡', '损失']pattern = re.compile('.*?(未造成.*?(?:{0}))[,.?:;!,。?:;]'.format('|'.join(key_words)))patterns.append(pattern)patterns.append(re.compile('(\d+人死亡)'))patterns.append(re.compile('(\d+人身亡)'))patterns.append(re.compile('(\d+人受伤)'))patterns.append(re.compile('(\d+人烧伤)'))patterns.append(re.compile('(\d+人坠楼身亡)'))patterns.append(re.compile('(\d+人遇难)'))for i in patterns:jieguo = i.search(data)if not jieguo:passelse:print('事故伤亡:',jieguo.group(1))#事故时间:

#事故时间:

def pattern_time(data):data = ''.join(test_data)# data.type :strPATTERN = r"([0-9零一二两三四五六七八九十]+年)?([0-9一二两三四五六七八九十]+月)?([0-9一二两三四五六七八九十]+[号日])?([上中下午晚早]+)?([0-9零一二两三四五六七八九十百]+[点:\.时])?([0-9零一二三四五六七八九十百]+分?)?([0-9零一二三四五六七八九十百]+秒)?"pattern = re.compile(PATTERN)m = pattern.search(data)# "19年1月14日18时19分39秒上午"m1 = pattern.search("上午")year=m.group(1) # 年month=m.group(2) # 月day=m.group(3) # 日am=m.group(4) # 上午,中午,下午,早中晚hour=m.group(5) # 时minutes=m.group(6) # 分seconds=m.group(7) # 秒print('事故时间: ',year,month,day,am,hour,minutes,seconds)

#事故地点:

#事件地点

def pattern_address(data):data = ''.join(data)#转换格式p_string = data.split(',')#分句address=[]for line in p_string:line = str(line)PATTERN1 = r'([\u4e00-\u9fa5]{2,5}?(?:省|自治区|市)){0,1}([\u4e00-\u9fa5]{2,7}?(?:区|县|州)){0,1}([\u4e00-\u9fa5]{2,7}?(?:镇)){0,1}([\u4e00-\u9fa5]{2,7}?(?:村|街|街道)){0,1}([\d]{1,3}?(号)){0,1}'# \u4e00-\u9fa5 匹配任何中文# {2,5} 匹配2到5次# ? 前面可不匹配# (?:pattern) 如industr(?:y|ies) 就是一个比 'industry|industries' 更简略的表达式。意思就是说括号里面的内容是一个整体是以y或者ies结尾的单词pattern = re.compile(PATTERN1)p1 = ''p2 = ''p3 = ''p4 = ''p5 = ''p6 = ''m = pattern.search(line)if not m:continueelse:address.append(m.group(0))#print('事件地点:',m.group(0))print('事件地点:',set(address))#事故摘要:

摘要讲解见链接:中文文本摘要提取 (文本摘要提取 有代码)基于python

停用词链接:nlp 中文停用词数据集

def shijian(data):import jiebatext=''.join(data)text = re.sub(r'[[0-9]*]', ' ', text) # 去除类似[1],[2]text = re.sub(r'\s+', ' ', text) # 用单个空格替换了所有额外的空格sentences = re.split('(。|!|\!|\.|?|\?)', text) # 分句# 加载停用词def stopwordslist(filepath):stopwords = [line.strip() for line in open(filepath, 'r', encoding='gbk').readlines()]return stopwordsstopwords = stopwordslist("停用词.txt")# 词频word2count = {} # line 1for word in jieba.cut(text): # 对整个文本分词if word not in stopwords:if word not in word2count.keys():word2count[word] = 1else:word2count[word] += 1for key in word2count.keys():word2count[key] = word2count[key] / max(word2count.values())# 计算句子得分sent2score = {}for sentence in sentences:for word in jieba.cut(sentence):if word in word2count.keys():if len(sentence) < 300:if sentence not in sent2score.keys():sent2score[sentence] = word2count[word]else:sent2score[sentence] += word2count[word]# 字典排序def dic_order_value_and_get_key(dicts, count):# by hellojesson# 字典根据value排序,并且获取value排名前几的keyfinal_result = []# 先对字典排序sorted_dic = sorted([(k, v) for k, v in dicts.items()], reverse=True)tmp_set = set() # 定义集合 会去重元素 --此处存在一个问题,成绩相同的会忽略,有待改进for item in sorted_dic:tmp_set.add(item[1])for list_item in sorted(tmp_set, reverse=True)[:count]:for dic_item in sorted_dic:if dic_item[1] == list_item:final_result.append(dic_item[0])return final_result# 摘要输出final_resul = dic_order_value_and_get_key(sent2score, 5)print('事件主要意思:',final_resul)#主函数:

def main(data):pattern_cause(data)pattern_lose(data)pattern_time(data)pattern_address(data)shijian(data)

if __name__ =='__main__':#读取数据with open('新闻.txt', 'r', encoding='utf-8') as f:test_data = f.readlines()main(test_data)

数据集:新闻.txt

1月14日18时19分,宝鸡市渭滨区金陵街道机厂街社区铁路家属院17号楼一单元发生火灾,火势由二、三、四阳台向上蔓延,一名老人被困屋内,情况危急。宝鸡消防支队渭滨大队广元路中队接警后,迅速赶赴现场展开救援,将被困老人救出。记者了解到,火灾发生后,宝鸡消防支队渭滨大队广元路中队立即赶赴现场开展救援,经现场侦查发现,火势由二、三、四楼阳台向上蔓延,均已过火。由于小区内道路蜿蜒且狭窄,中队立即调派经一路、开元、宝光、电子街4个卫星消防站增援。中队到场后立即成立搜救组、灭火组、供水组开展救援工作。消防在搜救过程中发现1单元2楼南户有一名老人被困,中队立即进行营救,同时并对2单元30余名群众进行疏散。灭火小组从小区南北两侧对现场火势进行打压。铁塔路及新华路中队随后也赶到现场增援,20时10分现场明火被扑灭。火灾未造成人员伤亡,起火原因正在调查中。

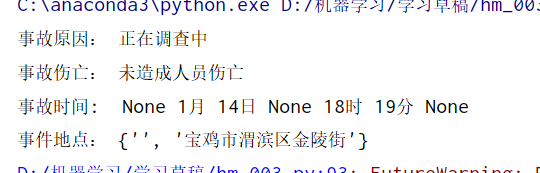

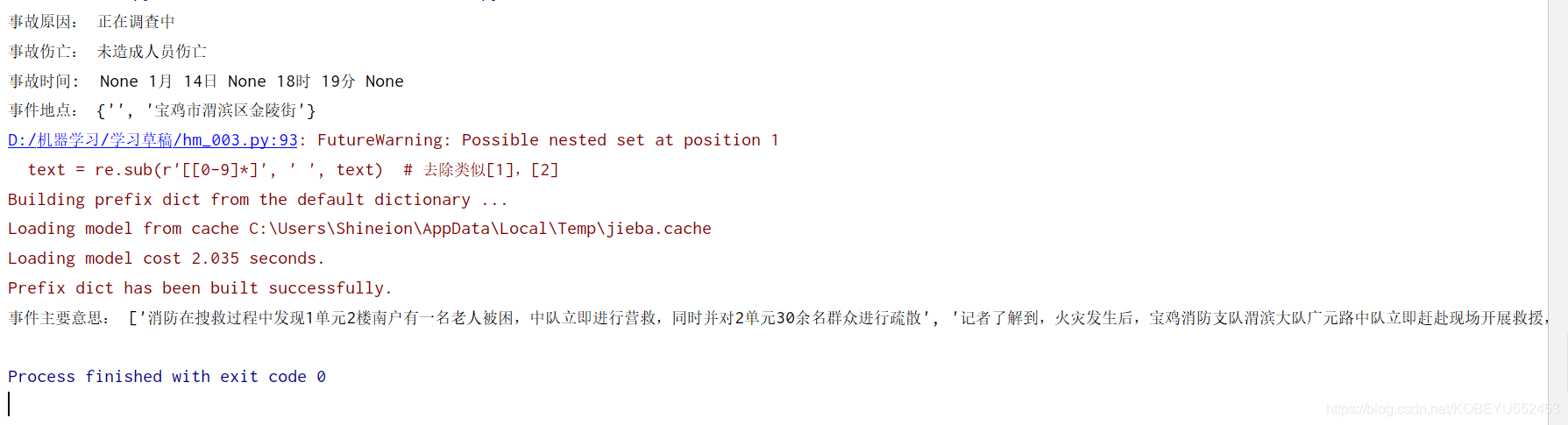

运行结果

事件主题意思在下面:

截个全图看下:

运行结果还不错。

反思

这代码是针对国内新闻的,因为地址正则是针对国内地址的。

代码马马虎虎,不是很完善。针对其他类新闻和文本,则需修改下正则(如事事故伤亡可能没有)。

基于正则需要花费大量脑力。基于正则主要在于如何定义规则。

有时间还是想想基于模型吧。

电气工程的计算机萌新:余登武。写文章不容易。如果你喜欢本文章,请点个赞支持下写作,谢谢。

这篇关于nlp事件抽取算例实现:(有完整算例和完整代码)的文章就介绍到这儿,希望我们推荐的文章对编程师们有所帮助!