本文主要是介绍【事件相机2020】CVPR2020中关于事件相机的研究,希望对大家解决编程问题提供一定的参考价值,需要的开发者们随着小编来一起学习吧!

微信公众号:【事件相机】,交流事件相机的相关科研与应用。欢迎大家关注

RPG维护的github的文章许多也没有及时补充,所以只能自己去搜。最近简单翻看了CVPR2020中,关于事件相机研究的几篇论文。在此做一下简单总结。由于涉及方向较多,许多文章不太能看懂,所以只是泛读,了解最新的研究在做什么。

(本文原创发表于公众号,3D视觉工坊,在本博客中略有修改,但依旧按照转载进行标注。如需转载,请后台联系公众号。请勿直接转载此博客,谢谢!)

0. 下载地址

直接从CVPR2020的Open Access中进行下载:https://openaccess.thecvf.com/CVPR2020

我上传了网盘,可以下载:

链接: https://pan.baidu.com/s/1ZfLrvehF8CzPnbJxb94XXw 提取码: mi8e

1. 文章简介

按文章名称首字母排序,小标题是自己概括起的。

1.1 降噪

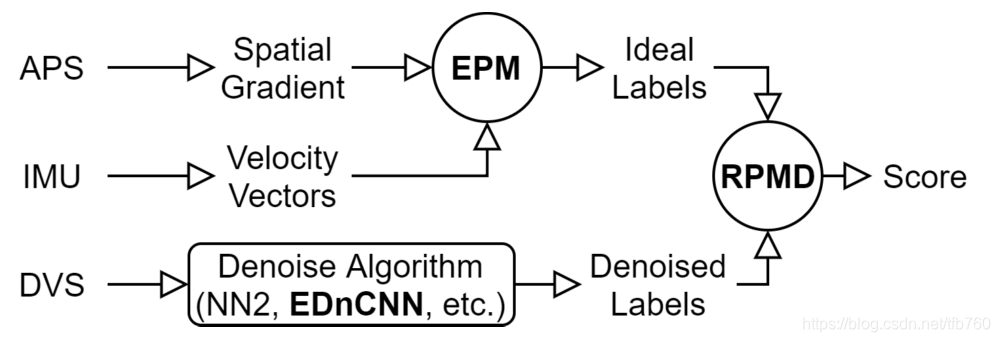

Event Probability Mask (EPM) and Event Denoising Convolutional Neural Network (EDnCNN) for Neuromorphic Cameras

本文使用"Event probability mask (EPM)" 表述一个事件点是否为噪声,是一个概率。同时提出了一个衡量事件相机降噪效果的指标:Relative Plausibility Measure of Denosing (RPMD);同时提出了一个降噪网络:Event Denosing CNN (EDnCNN);同时给出了一个降噪数据集:DVSNOISE20。

首先说是否为噪声的判断,采用下式,有两个假设,如果在一段儿时间内没有任何事件,即是非噪声的概率为0;如果这段儿时间内事件越多,是有效数据的概率越大。具体判断时,采用了IMU数据进行判断,但方法局限在纯旋转场景(可能有移动后计算太过于复杂)

在这个EPM描述之下,提出了评价降噪效果的一个指标:RPMD。并设计了一款CNN用于降噪,和别的方法相比取得了在这个指标上最优,认为可以作为当前数据集的benchmark。但这个数据集还是没有噪声的GT。

我认为本文最大的贡献,即采用IMU进行判断噪声,同时噪声的判断是概率形式更有发展前景,提出的指标虽然不适用于其他方法但尝试提出了。还是希望降噪这边能有带GT一类的数据集。

我认为本文最大的贡献,即采用IMU进行判断噪声,同时噪声的判断是概率形式更有发展前景,提出的指标虽然不适用于其他方法但尝试提出了。还是希望降噪这边能有带GT一类的数据集。

1.2 单目人体运动捕捉

EventCap: Monocular 3D Capture of High-Speed Human Motions using an Event Camera

本文提出了EventCap——第一个使用单事件相机捕捉人体3D运动的方法。方法输入完整的图像序列,和对应的事件相机的数据,通过异步混合运动捕捉阶段,再进行细化,得到完整的人体3D位姿。

1.3 超分辨率

EventSR: From Asynchronous Events to Image Reconstruction, Restoration, and Super-Resolution via End-to-End Adversarial Learning

文章提出了一个网络,用于将低分辨率的事件相机图像,转为高分辨率的数据。整个网络具有三个阶段:重建、修复和超分辨率处理。重建部分采用单事件相机数据,通过网络得到图像数据,之后对重建后的图像进行修复、提升质量,在家通过超分辨率网络进行放大。网络在训练的过程中没有完整的图像作为ground truth,是一个无监督的学习过程。

1.4 运动参数的全局最优解

Globally Optimal Contrast Maximisation for Event-based Motion Estimation

RPG曾经提出了利用事件相机数据,估计相机运动参数的一个框架,这个框架采用最大化对比度或其他目标函数,来估计运动参数。然而这个框架中需要对运动参数有一个初步的估计,如果估值较远,只能获得局部最优解,而不是全局最优解。本文提出了计算全局最优解的方法,采用了branch-and-bound(BnB)思想。文章从数学角度推算了方法的边界。这种方法的计算效率远低于直接优化获得局部最优解,但得到的质量还是不错。

1.5 联合滤波和图像降噪

Joint Filtering of Intensity Images and Neuromorphic Events for High-Resolution Noise-Robust Imaging

文章提出了一个全新的优化框架,guided event filtering (GEF)。这个框架结合了普通相机和事件相机的数据,估计运动参数与导向滤波、超分辨率等任务,同时这个框架后续可以用于特征跟踪等任务。其基本思想是事件相机积累图的边缘,和传统图像的梯度,理论上是相同的。文中同样采用RPG提出的最大化对比度的方式进行运动参数估计,只是修正了目标函数,加入了灰度图像的梯度,减小了事件噪声的影响。

1.6 基于学习的deblur

Learning Event-Based Motion Deblurring

文章提出了一个新型的端到端的去运动模糊的架构,在两大重要指标上达到了state-of-art;并提出一种方向性事件滤波方法,生成了更加清晰锐利的边缘信息。

1.7 基于学习的超分辨率

Learning to Super Resolve Intensity Images from Events

由于事件相机的分辨率相对较低,文章提出了第一个直接有事件相机数据重建超分辨率图像的端到端的神经网络。

1.8 基于时间表面的运动分割

Learning Visual Motion Segmentation using Event Surfaces

文章提出了一个图卷积神经网络,用事件数据流对运动物体进行分割。首先将一段事件数据流生成物体的点云图,之后获得速度、边界等参数,从而能够进行3D运动分割、运动物体跟踪等任务。

1.9 光流估计

Single Image Optical Flow Estimation with an Event Camera

文章通过一张图片和对应的事件相机数据,对图像中的场景进行光流估计。文章提出了基于事件的亮度一致性约束(event-based brightness constancy constraint)对光流和事件数据的关系进行编码,同时提出图像模糊模型,能够处理模糊图像下的光流估计问题。从结果上看,超过了现有的 PWC-Net, FlowNet, SelFlow 等方法。

1.10 视频转Events

Video to Events: Recycling Video Datasets for Event Cameras

RPG提出的一个将视频转成事件相机输出的一个网络,网络可以将一段儿视频转成对应的DVS输出,代码已开源:https://github.com/uzh-rpg/rpg_vid2e。通过该网络,可以将现有的大量视频数据集,转成对应的event数据,更好地方便learning。可以看出,RPG在learning的路上越走越远,已经不满足于模拟器、仿真器等这些相对低效的手段获取数据,而是直接从现有数据集转化。

2. 总结

可以看出,CVPR2020中大多数关于EB的研究,集中在learning的方法,涉及:降噪、去模糊、光流、数据生成、超分辨率等方向。感觉真的是,learning无处不在。

这篇关于【事件相机2020】CVPR2020中关于事件相机的研究的文章就介绍到这儿,希望我们推荐的文章对编程师们有所帮助!