本文主要是介绍One Shot Face Swapping on Megapixels 论文简介,希望对大家解决编程问题提供一定的参考价值,需要的开发者们随着小编来一起学习吧!

原文链接:https://zhuanlan.zhihu.com/p/371625603

#换脸##CVPR 2021#

One Shot Face Swapping on Megapixels

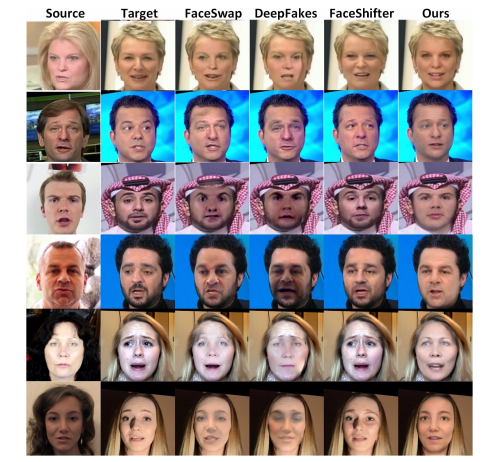

作者称这是首个百万像素级的 One Shot Face Swapping 方法:MegaFS。

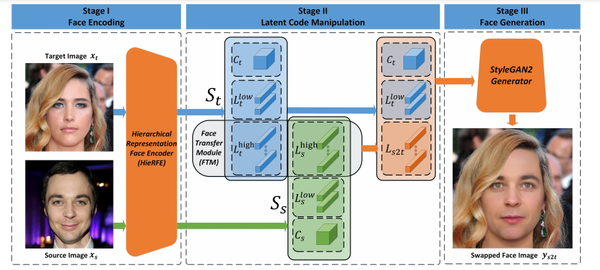

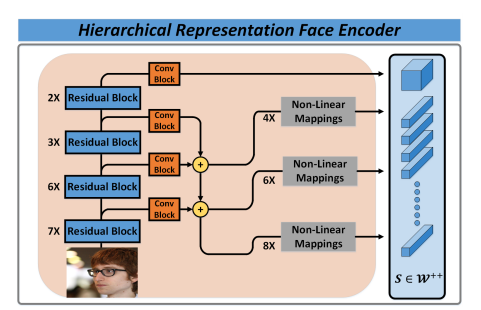

首先,MegaFS 通过提出的分层表征人脸编码器(HieRFE)在一个扩展的隐空间中分层组织人脸表征,以保持更多的人脸细节,而不是以前的换脸方法中的压缩表征。

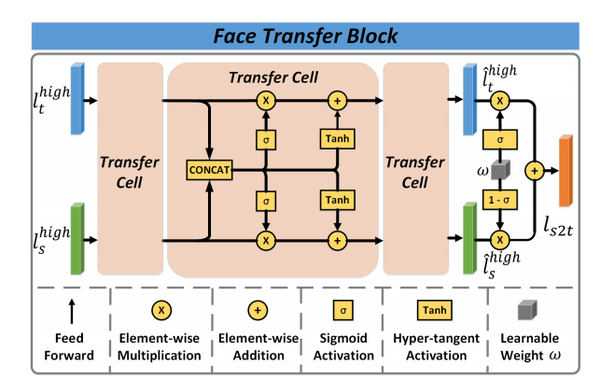

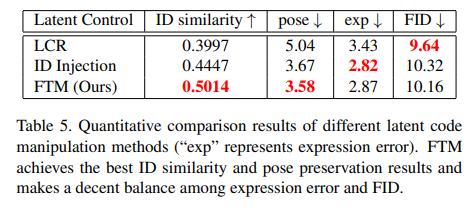

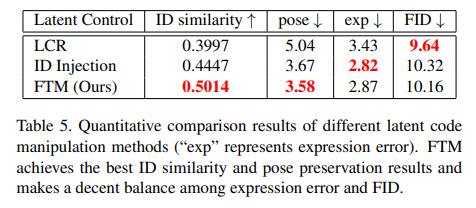

其次,设计一个 Face Transfer Module(FTM),通过非线性轨迹将身份从源图像迁移到目标图像,而不需要明确的特征拆分。

最后,交换后的人脸可以由 StyleGAN2 合成,优点是训练稳定,生成能力强。

MegaFS 的每一部分都可以单独训练,因此该模型对 GPU 内存的要求可以满足百万像素换脸的要求。因此本次工作中的三大贡献为:完整的人脸表示、稳定的训练和有限的内存使用。

更多的实验页证明了 MegaFS 的优越性,第一个百万像素级的换脸数据库也已发布,用于研究公共领域的 DeepFake 检测和人脸图像编辑。

作者 | Yuhao Zhu, Qi Li, Jian Wang, Chengzhong Xu, Zhenan Sun

单位 | 中科院自动化所;澳门大学;国科大

论文 | https://arxiv.org/abs/2105.04932

数据集 | https://github.com/zyainfal/One-Shot-Face-Swapping-on-Megapixels

备注 | CVPR 2021

这篇关于One Shot Face Swapping on Megapixels 论文简介的文章就介绍到这儿,希望我们推荐的文章对编程师们有所帮助!