本文主要是介绍论文研读|How to Prove Your Model Belongs to You: A Blind-Watermark based Framework ...,希望对大家解决编程问题提供一定的参考价值,需要的开发者们随着小编来一起学习吧!

目录

- 论文信息

- 文章简介

- 研究动机

- 研究方法

- 水印生成

- 水印嵌入

- 版权验证

- 实验结果

- 保真度(Fidelity)

- 有效性和完整性(effectiveness and integrity)

- 鲁棒性(Robustness)

- 抗逃逸攻击(Evasion Attack)- Security

- 抗伪造攻击(Forgy) - Legality

- 抗微调(Fine-Tuning)

- 方法评估

- 相关文献

论文信息

论文名称:How to Prove Your Model Belongs to You: A Blind-Watermark based Framework to Protect Intellectual Property of DNN

作者:Zheng Li, et al. Shandong University

发表年份:2019

发表会议:ACSAC

开源代码:https://github.com/zhenglisec/Blind-Watermark-for-DNN

文章简介

本文提出盲模型水印的概念,旨在生成视觉差异不可感知性的触发集。通过Auto-Encoder使得触发集中水印图像的分布更加接近原始训练数据中的图像,并借鉴生成对抗网络的概念,添加判别器,拟合水印图像与原始图像的分布。

研究动机

本文首先说明白盒水印的应用场景限制[27],然后指出,黑盒水印模型之所以易受逃逸攻击[14]与伪造攻击,是因为触发集中水印图像的构造方式过于直白[1,10,23,31],这就为模型窃取者提供了可乘之机 —— 攻击者通过修改或伪造触发集,使得模型中的水印失效。基于此,本文提出基于动态水印信号生成的黑盒水印方法,在Auto Encoder(AE)与判别器的双重约束下,为原始图像添加不可见水印,使得水印图像的分布更加接近原始图像。

研究方法

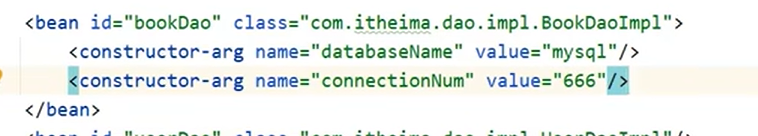

水印生成

本工作使用如上图所示的Encoder生成水印图像。Encoder是一个轻量级的Anto Encoder(AE),将原始图像与特定的logo图像作为输入,AE 输出的即为水印图像。此外,为确保水印图像和原始图像的不可分性,添加判别器作为辅助,使得二者的分布尽可能相似。为保证水印信号的视觉不可感知性和统计不可感知性以及水印图像的质量和有效性,本工作设计了如下4个损失函数:

(1)水印图像与原始图像的像素空间差异

这一损失函数的作用是使得水印图像与原始图像的像素空间差异尽可能小,借助L2范式实现。

(2)水印图像与原始图像的结构相似性

这一损失函数的作用是使得水印图像与原始图像的结构相似性尽可能大,借助SSIM指标实现。

(3)水印图像与原始图像的分布相似性

这一损失函数的作用是使得水印图像与原始图像的分布尽可能相似,借助判别器实现(使其尽可能误分类)。

(4)水印图像在模型中的有效性

这一损失函数的作用是使得水印图像在 Host DNN 中的准确率尽可能高,借助 Host DNN 实现。

这里要注意的是,AE生成的水印图像分布只能是接近原始图像的分布,而不能完全等同。这一接近程度体现了水印安全性与有效性的权衡:越大越能够增加水印的有效性,越小越能够抵御逃逸攻击。

使用本方法生成的水印图像示例:

水印嵌入

水印生成与水印嵌入过程同步进行,Encoder、Discriminator 以及 Host DNN 三个模型联合训练,下面我们再来明确一下三者的损失:

(1)Encoder 用于水印生成

(2)Discriminator 辅助水印生成

(3)Host DNN 用于水印嵌入

Encoder、Discriminator与Host DNN 的完整训练流程如下:

其中,第一个子for循环用于水印生成,第二个子for循环用于水印嵌入。

版权验证

使用训练好的AE构造水印图像,将其送入Host DNN 中,通过计算模型输出标签与水印标签的一致性概率,验证HostDNN的版权。

实验结果

保真度(Fidelity)

有效性和完整性(effectiveness and integrity)

只有当 θ u m ( x k e y ) ≠ t k e y \theta_{um}(x^{key})\neq t^{key} θum(xkey)=tkey 且 θ m ( x k e y ) = = t k e y \theta_{m}(x^{key}) == t^{key} θm(xkey)==tkey 时,认为当前水印样本有效。

鲁棒性(Robustness)

抗逃逸攻击(Evasion Attack)- Security

假设攻击者已知 10% 的训练样本,攻击者可以根据现有方法构建触发集,然后使基于原始数据和触发集训练检测器,检测出水印图像,中断版权认证过程,这种攻击也就是本篇工作中提出的「查询修改攻击」。

通过下述实验结果,可以看出本文提出的水印方法能够更加有效地抵抗逃逸攻击,水印图像具有较高的不可检测性。

抗伪造攻击(Forgy) - Legality

攻击者通过窃取水印生成手段,伪造触发集,混淆版权验证过程。针对伪造攻击,有如下两种情况:

(1)触发集泄漏

这种情况下,攻击者首先使用查询修改攻击检测出水印图像,然后找到水印生成方法,伪造触发集。然而,这种攻击只对静态水印信号有效。对于本文提出的基于 Auto Encoder 生成的方法,如 Figure 8 所示,由于每张图像对应的水印信号不同,攻击者无法通过叠加的方式伪造水印图像,这保证了水印信号的隐蔽性。

(2)Encoder 泄漏

这种情况下,攻击者训练出一个盗版的Encoder用来生成水印图像,伪造触发集,然后将伪造水印嵌入模型中。为验证盗版Encoder生成的水印图像是否会使含水印模型产生水印标签,本文通过改变随机种子,训练出5对Encoder-Model,测试触发集在含水印模型间的迁移性。 Figure 9 表明,某个Encoder生成的水印图像只能在对应的 Model 上发挥作用,这就说明,含水印模型的版权只能由模型所有者来验证,保证了水印的唯一性。

抗微调(Fine-Tuning)

方法评估

本文提到该方法同时满足白盒水印和黑盒水印的设定,但个人认为这还是一个比较典型的黑盒水印方法。亮点有二:一是本文首次考虑到水印信号在生成阶段的不可感知性问题,利用Auto Encoder 来生成不可见水印信号,也就是题目中的盲水印这一概念;二是将水印生成和水印嵌入过程同步进行,利用博弈的思想提升水印信号的隐蔽性和有效性,使得水印能够更好地抵御查询修改攻击。

这篇文章可以和 Robust Watermarking of Neural Network with Exponential Weighting(AsiaCCS,2019)这篇文章 结合起来看,前者是模型所有者利用 Auto Encoder 构造触发集,后者是攻击者利用 Auto Encoder 实施查询修改攻击/逃逸攻击。由此可见,技术是一把双刃剑,全看我们如何使用。

相关文献

[1] Yossi Adi, Carsten Baum, Moustapha Cisse, Benny Pinkas, and Joseph Keshet. Turning Your Weakness Into a Strength: Watermarking Deep Neural Networks by Backdooring. USENIX, 2018.

[10] Jia Guo and Miodrag Potkonjak. Watermarking deep neural networks for embedded systems. ICCAD, 2018.

[14] Dorjan Hitaj, Briland Hitaj and Luigi V Mancini. Evasion Attacks Against Watermarking Techniques found in MLaaS Systems. SDS, 2019.

[23] Bita Darvish Rouhani, Huili Chen, and Farinaz Koushanfar. 2018. DeepSigns: A Generic Watermarking Framework for IP Protection of Deep Learning Models. ASPLOS, 2019.

[27] Yusuke Uchida, Yuki Nagai, Shigeyuki Sakazawa, and ShinâĂŹichi Satoh. Embedding watermarks into deep neural networks. ICMR, 2017.

[31] Jialong Zhang, Zhongshu Gu, Jiyong Jang, Hui Wu, Marc Ph. Stoecklin, Heqing Huang, and Ian Molloy. Protecting Intellectual Property of Deep Neural Networks with Watermarking. ASIACCS, 2018.

这篇关于论文研读|How to Prove Your Model Belongs to You: A Blind-Watermark based Framework ...的文章就介绍到这儿,希望我们推荐的文章对编程师们有所帮助!