本文主要是介绍pgpool(3.6.5)的一个巨坑,希望对大家解决编程问题提供一定的参考价值,需要的开发者们随着小编来一起学习吧!

在现场环境中突然发现spark application卡死,而卡死的状态又与普通的阻塞不同,看起来就是执行了一部分job之后,后面的Job都没有提交了。

而更为诡异的是,如果把指向不用pgpool,而直接用一个普通的pg库,整个spark application是正常的。

此时猜测可能问题出在driver端代码上,发现有一个类似这样的代码:

df.write().jdbc(...)

主要就是将df写成一张pg表。

查看了spark源码也很简单:

1.判断表是否存在(使用语句为select * from 表名 limit 1)

2.创建表

3.写数据

查看pg_stat_activity,发现是有query=select * from 表名 limit 1 语句的,处于idle状态。

IDEA远程连spark单步调试,发现卡住的正是第一步:

select * from 表名 limit 1

不用spark,而使用普通的jdbc执行这句话,也存在卡死的状况。

需要说明的是,查询的这种表是不存在的,也就是说这句话是会抛出异常的。不会是pg抛出了异常,而pgpool未能正确的处理此异常吧?

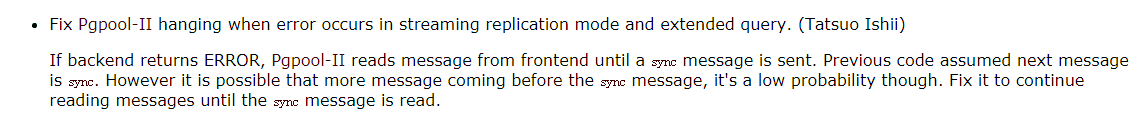

事实证明,pgpool确实是在处理error message时有问题,9月5日发布的3.6.6版本修复了此问题:

所以解决方案,就是采用3.6.6版本的pgpool。

这篇关于pgpool(3.6.5)的一个巨坑的文章就介绍到这儿,希望我们推荐的文章对编程师们有所帮助!

![Anaconda 3.6安装wordcloud 词云出现问题[已解决]](https://i-blog.csdnimg.cn/blog_migrate/73262c2678bde38d0579eb4764c65780.png)