本文主要是介绍Ollama Desktop,希望对大家解决编程问题提供一定的参考价值,需要的开发者们随着小编来一起学习吧!

一、简介

Ollama Desktop是基于Ollama引擎的一个桌面应用解决方案,用于在macOS、Windows和Linux操作系统上运行和管理Ollama模型的GUI工具。

Ollama Desktop提供了丰富的功能,包括但不限于:

- 可视化的管理界面:用户可以通过图形界面轻松地管理Ollama模型,无需记忆命令行语法。

- 在线模型:用户可以直接查询Ollama支持的模型,通过界面直接下载。

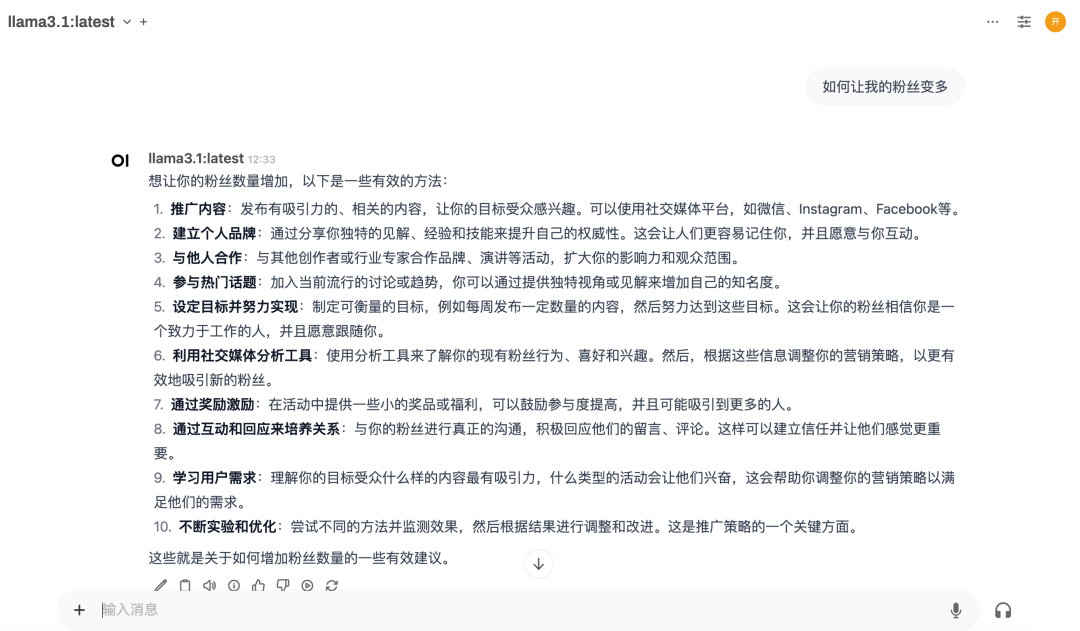

- 与模型对话:Ollama Desktop提供了友好的可视化聊天界面,支持用户自定义会话模型、历史轮次、温度、惩罚等常用配置。

- 部署简单:相较于其他支持Ollama的可视化工具,Ollama Desktop提供了单一程序,无需复杂安装,开箱即用。

项目地址:gitee | github

二、功能预览

2.1 主页

2.1. 1 环境信息

2.1.2 本地模型

2.1.3 在线模型

2.2 聊天

2.3 设置

2.4 关于

2.5 暗黑模式

三、帮忙点个⭐Star

开源不易,如果觉得Ollama Desktop对您有帮助的话,请帮忙点个⭐Star,您的支持是使Ollama Desktop变得更好最大的动力。如果您愿意的话,可以为作者捐赠一杯咖啡,万分感谢。

这篇关于Ollama Desktop的文章就介绍到这儿,希望我们推荐的文章对编程师们有所帮助!