本文主要是介绍当我们写爬虫的时候,我们实际在做什么?,希望对大家解决编程问题提供一定的参考价值,需要的开发者们随着小编来一起学习吧!

当我开始学习爬虫的时候,我在网上也开始找相关教程,大多数都是xx分钟学会爬虫一类的文章。并不是否定这些文章的价值,因为他们的确“教会”我如何爬取网页。但我不想停留只会使用工具这一层面上,这就是我想谈谈自己对爬虫的理解。

思考一下我们是怎么样上网的呢?

- 打开浏览器,习惯性输入百度看看网络连接有没有问题或者输入谷歌看看能不能科学上网。

- 然后我现在的习惯是打开简书首页,看看有没有新的技术类文章或者是鸡汤文,不断往下、往下、往下拉--居然找不到。

- 突然找到一篇感觉不错的文章,于是点进去继续看了下去。

- 文章中还有其他扩展阅读推荐,我继续点进去看下好了。

- 看完链接的文章感觉不需要再刨根问底,就关闭这个页面了。

什么是爬虫呢?

百度百科上说网络爬虫(又被称为网页蜘蛛,网络机器人,在FOAF社区中间,更经常的称为网页追逐者),是一种按照一定的规则,自动地抓取万维网信息的程序或者脚本。另外一些不常使用的名字还有蚂蚁、自动索引、模拟程序或者蠕虫。

维基百科上说网络蜘蛛(Web spider)也叫网络爬虫(Web crawler)[1]

,蚂蚁(ant),自动检索工具(automatic indexer),或者(在FOAF软件概念中)网络疾走(WEB scutter),是一种“自动化浏览网络”的程序,或者说是一种网络机器人。它们被广泛用于互联网搜索引擎或其他类似网站,以获取或更新这些网站的内容和检索方式。它们可以自动采集所有其能够访问到的页面内容,以供搜索引擎做进一步处理(分检整理下载的页面),而使得用户能更快的检索到他们需要的信息

爬虫基于用户需求诞生。比如说有一天我感觉每天打开简书首页看东西太累了,希望可以有一份邮件告诉我昨天我关注的专栏更新的收录文章,或者告诉我简书喜欢量最多的文章TOP10。我肯定不会蛋疼到雇一个人帮我一个一个翻(因为我没钱),但是我会雇一个网络爬虫帮我解决这个问题(因为他只问我要电费和带宽费)。

那爬虫是怎么工作的呢?想象你雇了一个富土康流水线的员工帮你去互联网找东西,爬虫也就是这样工作。

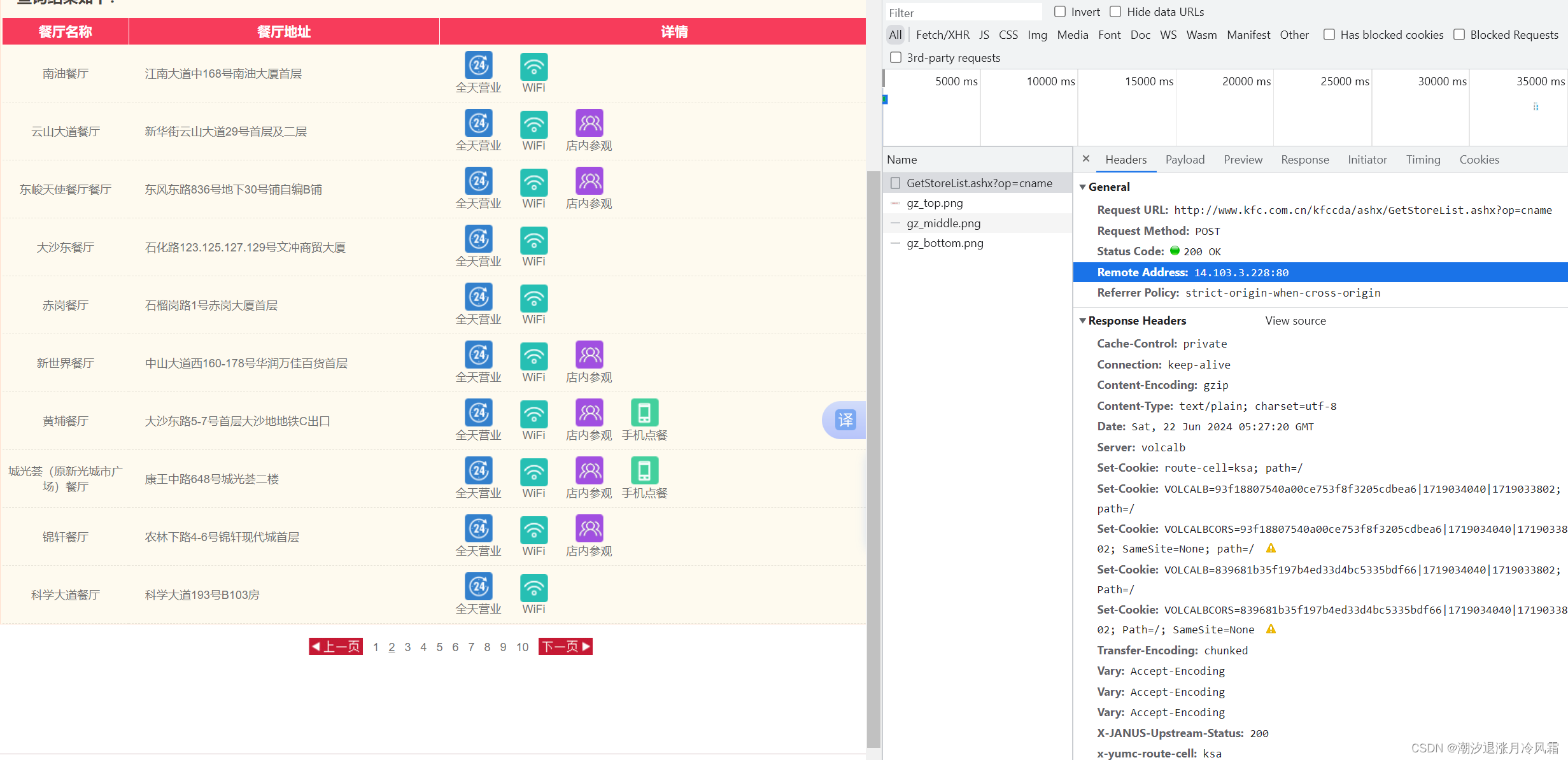

- 向网站发起一个请求(request),比如说你打开一个视频页面准备看;

- 中间经过好多了复杂的步骤,比如说验证你的身份

- 网站响应(response)了你请求的内容

- 爬虫解析响应内容种是否存在其他目标链接,如有重复第一步

- 爬取的数据用于进一步的数据挖掘

作者:xlzd

链接:https://zhuanlan.zhihu.com/p/20413828

来源:知乎

著作权归作者所有。商业转载请联系作者获得授权,非商业转载请注明出处。

爬虫要干什么

大多数情况下,爬虫其实就是在模拟上面的过程。当然爬虫不会全部模拟一遍,而是会选择合适的步骤模拟。比如大多数情况下我们并不会去请求CSS和Javascript文件,而只是会请求HTML源码或者我们需要的数据。在得到源码后,就像浏览器会解析HTML源码一样,我们的爬虫也会解析HTML,筛选出我们想要的内容保存。

所以在互联网刚发展的时候,那时候用爬虫估计和我们现在用的差不多,但是随着网页的几何级增长,我们就只能针对某个领域写所需爬虫,目前没钱买那么多服务器搞分布式爬取。

那么应该怎么学习爬虫呢?

学习爬虫永远绕不开HTTP协议。如果你仔细思考一下写的代码,你就会问一个问题,为啥要用Requests(Requests is the only Non-GMO HTTP library for Python, safe for human consumption.)。当你问这个问题的时候,请你去看一下百度词条上http。当你对http协议有一个大致的了解,那么你就能理解为啥会用到那些工具库了。

此外,基于需求和兴趣的学习是效率最高的方法,比如说做一个邮件推送功能,做一个图片自动下载器等。对于我而言,学习爬虫有以下几个要求:

- 能够爬取多个网页,并且不断优化数据提取方法

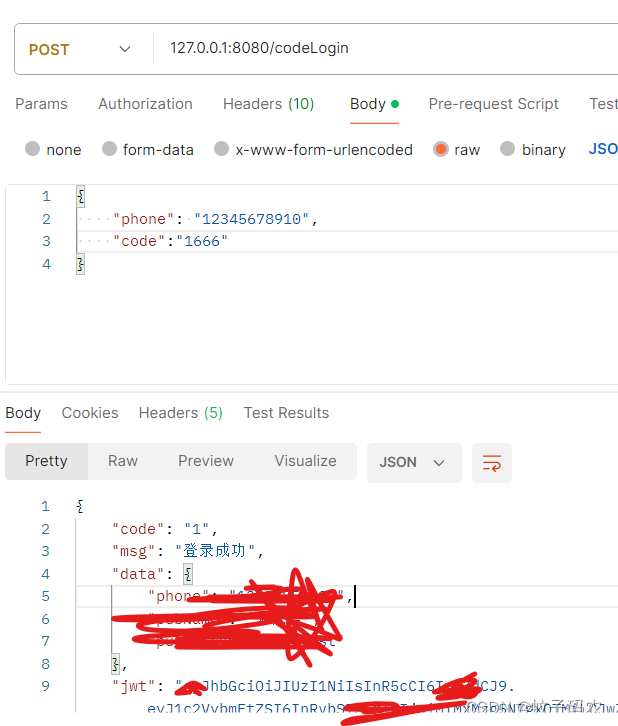

- 能够模拟登陆新浪微博、知乎、豆瓣、简书、微信等

- 能够爬取通过js生成的网页内容

- 使用ip pool和user agent pool防止被ban

- 学会分布式爬取

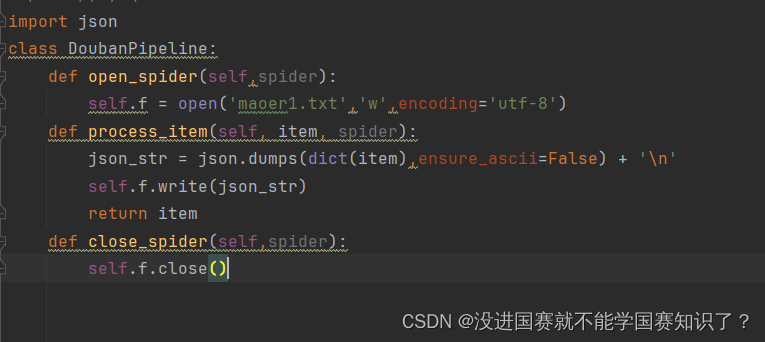

我使用python学习爬虫,因为我只学过一点的C(大学老师居然没教C最核心的指针思想),不会java和C++,主要在Python实战:一周学会爬取网页学的还不错。现在使用python的scrapy框架,因为我想通过读源代码进行深入学习。

这篇关于当我们写爬虫的时候,我们实际在做什么?的文章就介绍到这儿,希望我们推荐的文章对编程师们有所帮助!