本文主要是介绍Python Interpret库:模型解释,希望对大家解决编程问题提供一定的参考价值,需要的开发者们随着小编来一起学习吧!

更多Python学习内容:ipengtao.com

Interpret库是一个用于解释机器学习模型的开源Python库。它提供了多种解释技术,使得用户可以深入了解机器学习模型的决策过程。Interpret库支持全局和局部解释,能够处理不同类型的模型,包括线性模型、树模型和黑箱模型。本文将详细介绍Interpret库的安装、主要功能、基本操作、高级功能及其实践应用,并提供丰富的示例代码。

安装

Interpret库可以通过pip进行安装。确保Python环境已激活,然后在终端或命令提示符中运行以下命令:

pip install interpret主要功能

全局解释:理解模型整体行为。

局部解释:理解模型对单个预测的决策过程。

支持多种模型:支持线性模型、树模型和黑箱模型。

多种解释技术:如SHAP、LIME、Partial Dependence Plots等。

可视化工具:提供丰富的可视化工具来展示解释结果。

基本操作

导入库和加载数据

首先,需要导入必要的库并加载数据。

以下示例使用scikit-learn中的iris数据集:

from sklearn.datasets import load_iris

from sklearn.model_selection import train_test_split

from sklearn.ensemble import RandomForestClassifier

from interpret import show

from interpret.blackbox import LimeTabular# 加载数据

data = load_iris()

X_train, X_test, y_train, y_test = train_test_split(data.data, data.target, test_size=0.2, random_state=42)# 训练模型

model = RandomForestClassifier()

model.fit(X_train, y_train)使用LIME进行局部解释

以下示例展示了如何使用LIME进行单个预测的局部解释:

# 创建LIME解释器

lime = LimeTabular(predict_fn=model.predict_proba, data=X_train, feature_names=data.feature_names, class_names=data.target_names)# 解释单个预测

lime_explanation = lime.explain_instance(X_test[0], num_features=4)

show(lime_explanation)使用Partial Dependence Plots进行全局解释

以下示例展示了如何使用Partial Dependence Plots (PDP)进行全局解释:

from interpret.perf import ROC

from interpret.glassbox import ExplainableBoostingClassifier# 使用Explainable Boosting Classifier

ebm = ExplainableBoostingClassifier()

ebm.fit(X_train, y_train)# 创建PDP解释器

pdp_explanation = ebm.explain_global(name='EBM')

show(pdp_explanation)高级功能

使用SHAP进行解释

SHAP (SHapley Additive exPlanations) 是一种解释机器学习模型预测的技术。

以下示例展示了如何使用SHAP进行解释:

import shap# 创建SHAP解释器

explainer = shap.TreeExplainer(model)

shap_values = explainer.shap_values(X_test)# 可视化解释结果

shap.summary_plot(shap_values, X_test, feature_names=data.feature_names)自定义解释方法

Interpret库允许用户自定义解释方法。以下示例展示了如何创建自定义解释器:

from interpret import BaseEstimator, Explanation

import numpy as npclass CustomInterpreter(BaseEstimator):def fit(self, X, y):self.classes_, y = np.unique(y, return_inverse=True)self.n_classes_ = len(self.classes_)self.feature_importances_ = np.mean(X, axis=0)return selfdef explain_global(self, name=None):return Explanation("Custom Interpreter",feature_importances=self.feature_importances_,feature_names=data.feature_names)# 创建自定义解释器

custom_interpreter = CustomInterpreter()

custom_interpreter.fit(X_train, y_train)# 解释全局模型行为

global_explanation = custom_interpreter.explain_global()

show(global_explanation)模型性能评估

Interpret库还提供了模型性能评估工具。以下示例展示了如何评估模型性能:

# 创建性能评估器

roc_curve = ROC()

roc_curve.add(model, 'Random Forest')# 可视化ROC曲线

show(roc_curve)实践应用

解释金融数据中的信用评分模型

以下示例展示了如何使用Interpret库解释金融数据中的信用评分模型:

import pandas as pd

from interpret.blackbox import ShapKernel

from sklearn.preprocessing import StandardScaler

from sklearn.linear_model import LogisticRegression# 加载信用评分数据

data = pd.read_csv('credit_scoring.csv')

X = data.drop('default', axis=1)

y = data['default']# 数据预处理

scaler = StandardScaler()

X_scaled = scaler.fit_transform(X)# 训练模型

model = LogisticRegression()

model.fit(X_scaled, y)# 使用SHAP进行解释

explainer = ShapKernel(predict_fn=model.predict_proba, data=X_scaled, feature_names=X.columns)

shap_explanation = explainer.explain_local(X_scaled[:5])

show(shap_explanation)解释医疗数据中的疾病预测模型

以下示例展示了如何使用Interpret库解释医疗数据中的疾病预测模型:

import pandas as pd

from interpret.blackbox import LimeTabular

from sklearn.ensemble import GradientBoostingClassifier# 加载医疗数据

data = pd.read_csv('medical_data.csv')

X = data.drop('disease', axis=1)

y = data['disease']# 训练模型

model = GradientBoostingClassifier()

model.fit(X, y)# 使用LIME进行解释

lime = LimeTabular(predict_fn=model.predict_proba, data=X, feature_names=X.columns, class_names=['No Disease', 'Disease'])

lime_explanation = lime.explain_instance(X.iloc[0], num_features=5)

show(lime_explanation)解释图像分类模型

以下示例展示了如何使用Interpret库解释图像分类模型:

import numpy as np

from interpret.blackbox import ShapImage

from keras.applications.vgg16 import VGG16, preprocess_input

from keras.preprocessing import image# 加载图像分类模型

model = VGG16(weights='imagenet')# 加载并预处理图像

img_path = 'elephant.jpg'

img = image.load_img(img_path, target_size=(224, 224))

x = image.img_to_array(img)

x = np.expand_dims(x, axis=0)

x = preprocess_input(x)# 使用SHAP进行解释

explainer = ShapImage(predict_fn=model.predict, data=x, model=model)

shap_explanation = explainer.explain_local(x)

show(shap_explanation)总结

Interpret库为Python开发者提供了一个功能强大且灵活的工具,用于解释机器学习模型的决策过程。通过其简洁的API和丰富的功能,用户可以轻松进行全局和局部的模型解释,理解模型的行为和预测结果。无论是在金融、医疗还是图像分类等领域,Interpret库都能提供强大的支持和便利。本文详细介绍了Interpret库的安装、主要功能、基本操作、高级功能及其实践应用,并提供了丰富的示例代码。希望在实际项目中能够充分利用Interpret库,提高模型的可解释性和可信度。

如果你觉得文章还不错,请大家 点赞、分享、留言 ,因为这将是我持续输出更多优质文章的最强动力!

更多Python学习内容:ipengtao.com

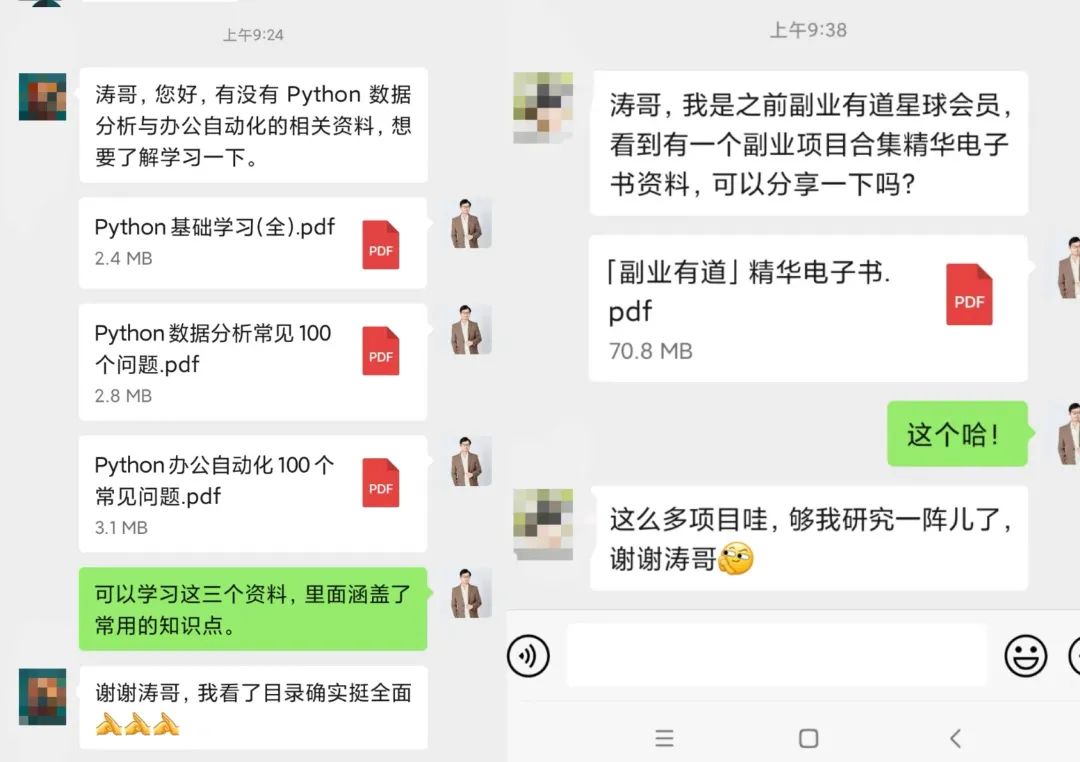

如果想要系统学习Python、Python问题咨询,或者考虑做一些工作以外的副业,都可以扫描二维码添加微信,围观朋友圈一起交流学习。

我们还为大家准备了Python资料和副业项目合集,感兴趣的小伙伴快来找我领取一起交流学习哦!

往期推荐

Python 中的 iter() 函数:迭代器的生成工具

Python 中的 isinstance() 函数:类型检查的利器

Python 中的 sorted() 函数:排序的利器

Python 中的 hash() 函数:哈希值的奥秘

Python 中的 slice() 函数:切片的利器

Python 的 tuple() 函数:创建不可变序列

点击下方“阅读原文”查看更多

这篇关于Python Interpret库:模型解释的文章就介绍到这儿,希望我们推荐的文章对编程师们有所帮助!