本文主要是介绍深度学习(理论知识),希望对大家解决编程问题提供一定的参考价值,需要的开发者们随着小编来一起学习吧!

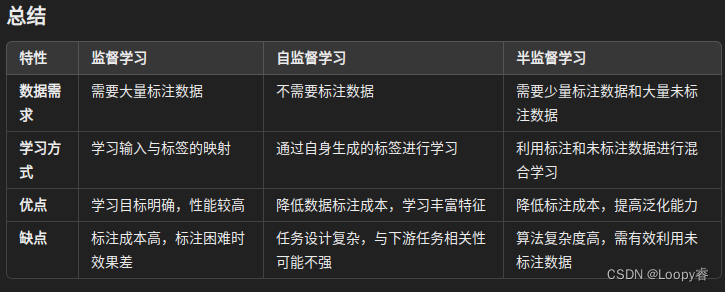

一、监督学习、自监督和半监督

1、监督学习(Supervised Learning)

概念

监督学习是一种机器学习方法,通过使用带标签的数据进行训练,模型学习从输入到输出的映射关系。数据集中的每个样本都包含输入特征(features)和对应的标签(labels)。

关键点

标签数据:每个训练样本都有明确的标签,表示期望的输出。

映射函数:模型学习一种映射函数,将输入特征映射到对应的标签。

目标:最小化预测值与真实标签之间的误差。

优缺点

优点:

学习过程明确,性能通常较高。

适用于分类、回归等任务,具有较强的解释性。

缺点:

依赖大量标注数据,标注成本高。

对于标注困难或样本不平衡的问题,效果较差。

例子

图像分类:训练数据是带有类别标签的图像,模型学习从图像特征到类别标签的映射。

语音识别:训练数据是带有文本标签的语音,模型学习从语音信号到文本的映射。

2、自监督学习(Self-Supervised Learning)

概念

自监督学习是一种通过自身生成的标签进行训练的方法,模型从数据中自动生成监督信号来进行学习。通常用于生成预训练模型或在没有标注数据的情况下学习数据的结构和特征。

关键点

自动标签:模型从数据本身生成监督信号,而不需要人工标注。

目标任务:设计自监督任务,例如恢复被遮挡的部分、预测未来帧等。

特征学习:学习数据的底层特征和表示。

优缺点

优点:

不需要标注数据,大大降低了数据成本。

能学习丰富的特征,适合预训练和迁移学习。

缺点:

自监督任务设计复杂,可能与下游任务相关性不强。

需要大量数据,计算资源需求高。

例子

图像补全:通过学习填补图像中缺失的部分来生成有效的特征表示。

对比学习:通过比较相似和不相似的数据对,学习数据的表示。

3、半监督学习(Semi-Supervised Learning)

概念

半监督学习是一种结合了少量标注数据和大量未标注数据进行训练的方法。目标是利用未标注数据的丰富信息提高模型性能,同时减少对标注数据的依赖。

关键点

混合数据:使用少量标注数据和大量未标注数据。

信息利用:充分利用未标注数据的信息来辅助学习。

模型改进:提高模型在未见数据上的泛化能力。

优缺点

优点:

降低标注成本,同时充分利用大量未标注数据。

能在标注数据稀缺的情况下,依然得到性能不错的模型。

缺点:

算法复杂度较高,需有效利用未标注数据。

可能需要设计特定的学习策略来平衡标注和未标注数据的贡献。

例子

分类任务:利用少量标注样本和大量未标注样本,学习分类器。

聚类任务:在标注和未标注样本上进行混合聚类,改进聚类性能。

这篇关于深度学习(理论知识)的文章就介绍到这儿,希望我们推荐的文章对编程师们有所帮助!