本文主要是介绍Spark运行spark-shell与hive运行时均报错的一种解决方案,希望对大家解决编程问题提供一定的参考价值,需要的开发者们随着小编来一起学习吧!

环境按照尚硅谷的配置的。

在运行hive的时候,报错代码为30041,无法执行insert语句。

在运行spark-shell的时候,报错,无法进入到shell脚本中。

可能的问题:

对集群设置的域名与集群的主机名称不一致。

例如:

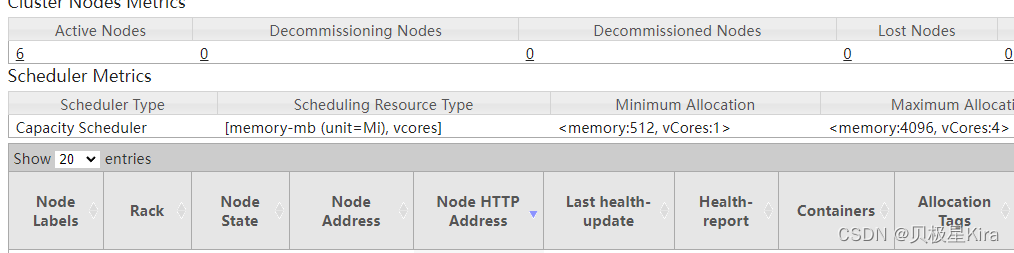

我的集群的域名为hadoopxx,但是我的集群的主机名均为ubuntu,导致集群中Node Address均为ubuntu:8042。

解决方案:

将集群的主机名称修改为与集群的域名相匹配的名称。

此图片需要在ResourceManager的IP的8088端口才能看见。

这篇关于Spark运行spark-shell与hive运行时均报错的一种解决方案的文章就介绍到这儿,希望我们推荐的文章对编程师们有所帮助!