本文主要是介绍大模型是什么?能干嘛?怎么学?,希望对大家解决编程问题提供一定的参考价值,需要的开发者们随着小编来一起学习吧!

引言

随着人工智能技术的飞速发展,大模型研究已成为该领域的一大热点。这些研究覆盖了众多方向,每个方向都面临着独特的研究焦点和挑战。本文将逐一探讨一些备受关注的研究方向,包括检索增强生成RAG、大模型Agent、Mamba、MoE、LoRA等,这些方向致力于解决大模型在实际应用中的关键问题,以提升其性能和实用性。

检索增强生成RAG

检索增强生成RAG通过结合信息检索和文本生成,显著提升了AI系统的效能。其核心优势在于能够利用外部知识库来辅助生成过程,从而确保生成内容的准确性和鲁棒性。结合大模型的卓越生成能力,RAG在问答系统、文档生成、自动摘要、智能助手、信息检索以及知识图谱填充等多个自然语言处理场景中展现出强大的应用潜力。研究重点包括“检索器与生成器的集成”、“跨模态应用与知识更新”等方面,而挑战则在于如何进一步提升“检索效率”、“生成质量”以及“跨领域应用”等关键环节。

大模型Agent

大模型Agent被认为是未来大模型发展的重要方向。随着大模型应用场景的日益复杂,仅依赖大模型自身的能力已无法满足需求。因此,构建高效的大模型Agent成为了必然趋势。当前,大模型Agent的研究重点聚焦于“多任务学习”、“常识推理与持续学习”等领域,旨在提升Agent在广泛任务上的表现力和适应性。

Mamba

Mamba作为一种选择性结构状态空间模型(Selective Structured State Space Model),在处理长上下文任务方面展现出线性时间推理、并行化训练及卓越性能等优势。其研究方向主要聚焦于提升长序列数据处理能力、多模态数据处理及计算效率等方面。

MoE(Mixed Expert Models)

MoE技术在大模型参数规模不断扩大及多任务应用普及的背景下,已成为研究的热点。其核心优势在于能够在有限的计算资源下,以更少的训练步数训练更大规模的模型,同时保持较低的推理成本,展现出良好的扩展性和多任务学习能力。

大模型高效微调(LoRA)

在大模型微调领域,研究者们探索了多种策略以应对计算资源有限和灾难性遗忘等问题。其中,LoRA通过引入低秩矩阵来模拟全模型微调的效果,显著降低了微调成本并实现了与全模型微调相近的性能。这些研究的重点包括提高参数效率、优化微调策略、扩展上下文处理能力以及实现模型压缩等方面。

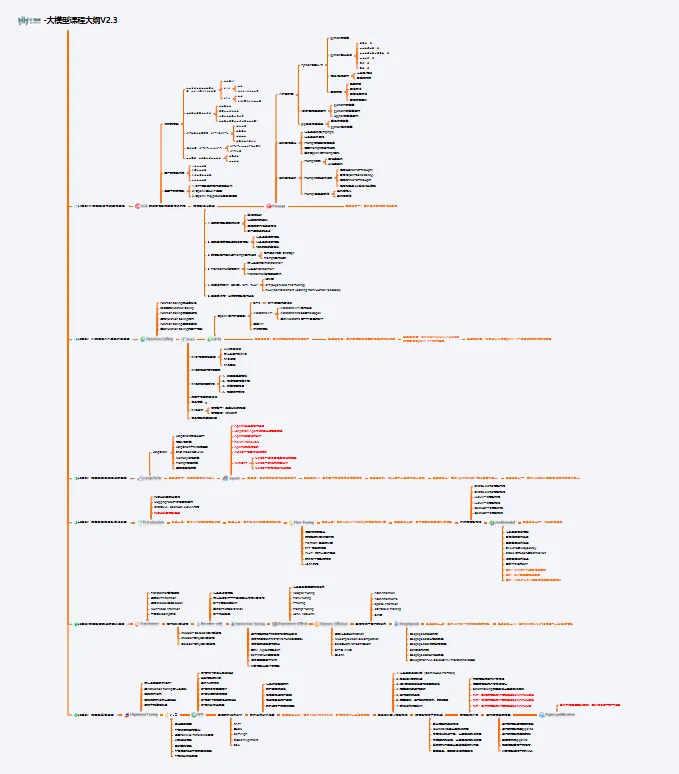

大模型AGI学习包

资料目录

- 成长路线图&学习规划

- 配套视频教程

- 实战LLM

- 人工智能比赛资料

- AI人工智能必读书单

- 面试题合集

《人工智能\大模型入门学习大礼包》,可以扫描下方二维码免费领取!

1.成长路线图&学习规划

要学习一门新的技术,作为新手一定要先学习成长路线图,方向不对,努力白费。

对于从来没有接触过网络安全的同学,我们帮你准备了详细的学习成长路线图&学习规划。可以说是最科学最系统的学习路线,大家跟着这个大的方向学习准没问题。

2.视频教程

很多朋友都不喜欢晦涩的文字,我也为大家准备了视频教程,其中一共有21个章节,每个章节都是当前板块的精华浓缩。

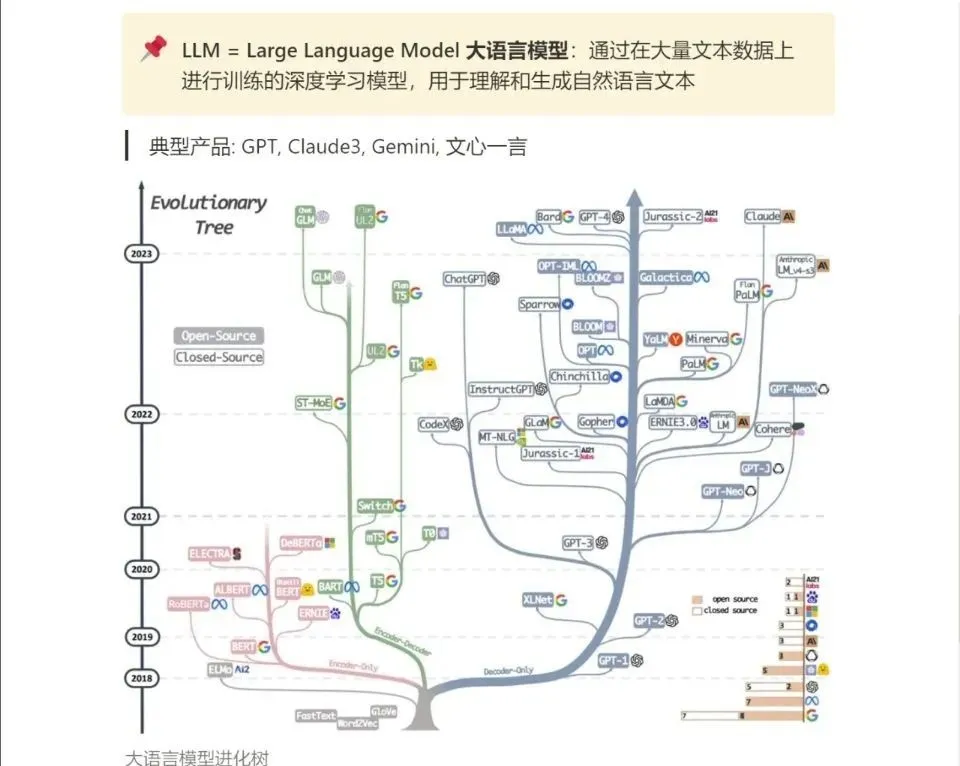

3.LLM

大家最喜欢也是最关心的LLM(大语言模型)

《人工智能\大模型入门学习大礼包》,可以扫描下方二维码免费领取!

这篇关于大模型是什么?能干嘛?怎么学?的文章就介绍到这儿,希望我们推荐的文章对编程师们有所帮助!