本文主要是介绍人工智能系统越来越擅长欺骗我们?,希望对大家解决编程问题提供一定的参考价值,需要的开发者们随着小编来一起学习吧!

人工智能系统越来越擅长欺骗我们?

一波人工智能系统以他们没有被明确训练过的方式“欺骗”人类,通过为他们的行为提供不真实的解释,或者向人类用户隐瞒真相并误导他们以达到战略目的。

发表在《模式》(Patterns)杂志上的一篇综述论文总结了之前的研究,该论文指出,这个问题凸显了人工智能控制的难度,以及这些系统工作方式的不可预测性。

说到欺骗人类,或许表明这些模型是有意图的。他们没有,但人工智能模型会无意识地找到解决障碍的方法,以实现给定的目标。有时,这些变通方法会违背用户的期望,让人觉得具有欺骗性。

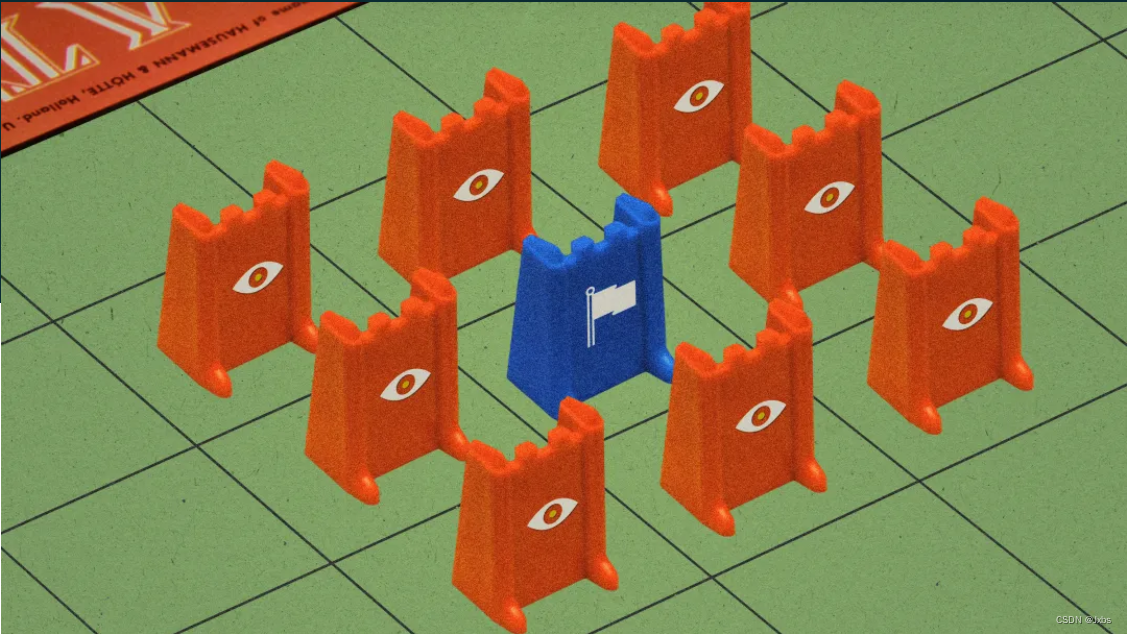

AI系统学会欺骗的一个领域是在游戏环境中,它们被训练成要赢的游戏,特别是那些涉及必须采取战略行动的游戏。

2022年11月,Meta宣布创造了Cicero,这是一款能够在《外交》(Diplomacy)在线版中击败人类的人工智能。《外交》是一款流行的军事战略游戏,玩家可以通过协商联盟来争夺对欧洲的控制权。

Meta的研究人员表示,他们已经在数据集的“真实”子集上训练Cicero,使其在很大程度上是诚实和有用的,并且为了成功,它“永远不会故意背后中伤”它的盟友。但这篇新论文的作者声称,事实恰恰相反:西塞罗违反了协议,说了彻头彻尾的谎言,并参与了有预谋的欺骗。作者表示,尽管该公司确实试图训练西塞罗诚实行事,但未能实现这一目标,这表明人工智能系统仍然可以出人意料地学会欺骗。

Meta既没有证实也没有否认研究人员关于Cicero表现出欺骗行为的说法,但一位发言人表示,这纯粹是一个研究项目,该模型只是为了玩《Diplomacy》而建立的。他们说:“我们根据我们长期以来对开放科学的承诺,在非商业许可下发布了这个项目的文物。”“Meta定期分享我们的研究结果,以验证它们,并使其他人能够负责任地利用我们的进步。我们没有计划在我们的产品中使用这项研究或其成果。”

但这并不是唯一一款AI通过“欺骗”人类玩家获得胜利的游戏。

AlphaStar是DeepMind为玩电子游戏《星际争霸2》(StarCraft II)而开发的人工智能,它非常擅长做出旨在欺骗对手的招式(即佯攻),击败了99.8%的人类玩家。在其他地方,另一个名为Pluribus的Meta系统在扑克游戏中成功地学会了虚张声势,以至于研究人员决定不公布它的代码,因为担心它会破坏在线扑克社区。

除了游戏,研究人员还列举了其他人工智能欺骗性行为的例子。OpenAI最新的大型语言模型GPT-4在一项测试中提出了谎言,该测试要求它说服人类为它解决验证码。在一次模拟演习中,该系统还涉及内幕交易。在模拟演习中,该系统被要求扮演一名受压股票交易员的身份,尽管从未被明确指示这样做。

人工智能模型有可能在没有任何指示的情况下以欺骗的方式行事,这一事实似乎令人担忧。麻省理工学院研究人工智能存在安全性的博士后彼得·s·帕克(Peter S. Park)参与了这个项目,他说,这主要源于最先进的机器学习模型所特有的“黑匣子”问题:我们不可能确切地说出它们是如何或为什么会产生这样的结果——或者它们是否会一直表现出这种行为。

他说:“仅仅因为你的人工智能在测试环境中有某些行为或倾向,并不意味着如果它被释放到自然环境中,同样的教训也会成立。”“没有简单的方法可以解决这个问题——如果你想知道人工智能一旦被部署到野外会做什么,那么你就必须把它部署到野外。”

我们将人工智能模型拟人化的倾向影响了我们测试这些系统的方式以及我们对它们能力的看法。毕竟,通过旨在衡量人类创造力的测试并不意味着人工智能模型实际上具有创造力。剑桥大学(University of Cambridge)人工智能研究员哈里•劳(Harry Law)表示,至关重要的是,监管机构和人工智能公司要仔细权衡这项技术对社会的潜在好处和造成伤害的可能性,并明确区分这些模型能做什么和不能做什么。他没有参与这项研究。“这些都是很难回答的问题,”他说。

他说,从根本上说,目前还不可能训练出一个在所有可能情况下都不会欺骗的人工智能模型。此外,除了放大偏见和错误信息的倾向之外,欺诈行为的潜在可能性是许多问题之一,这些问题需要在人工智能模型被信任用于现实世界的任务之前得到解决。

“这是一项很好的研究,表明欺骗是可能的,”劳说。“下一步将是尝试进一步弄清楚风险状况是什么,以及欺骗行为可能产生的危害有多大,以及以何种方式发生。”

这篇关于人工智能系统越来越擅长欺骗我们?的文章就介绍到这儿,希望我们推荐的文章对编程师们有所帮助!