本文主要是介绍Cyber Weekly #9,希望对大家解决编程问题提供一定的参考价值,需要的开发者们随着小编来一起学习吧!

赛博·新闻

1、OpenAI:GPTs向全部用户开放,使用GPT-4o

OpenAI宣布所有ChatGPT免费用户现在可以在GPT商店中使用GPTs,并且这些GPTs现在使用最新的GPT-4o模型。

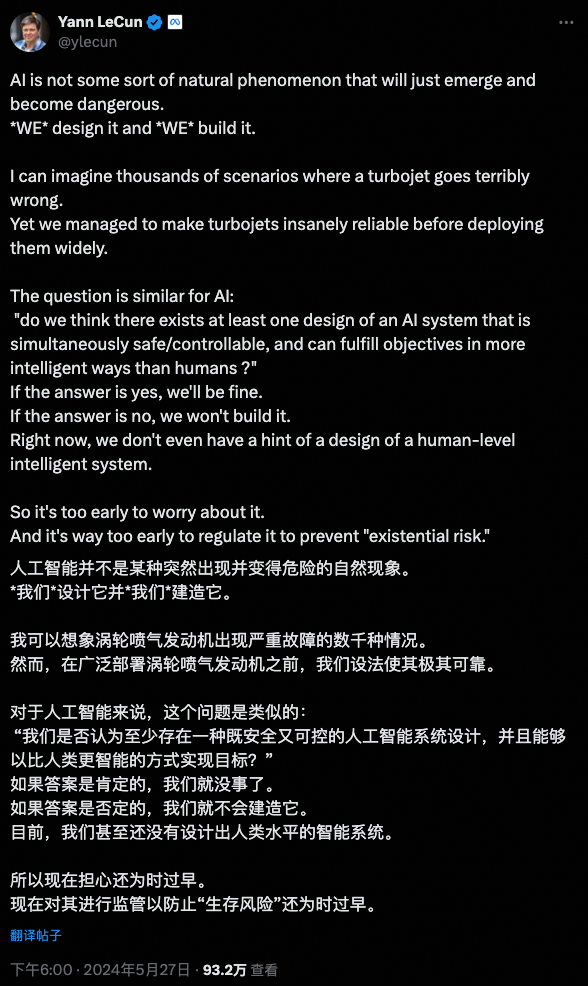

2、马斯克 vs. Yann LeCun

这一周,AI圈最热闹的莫过于马斯克和LeCun的对线,不论是在AI安全监管,还是xAI使命上,两人已经开启了激烈的隔空骂战。LeCun认为,现在担心人工智能带来「生存风险」还为时过早,更别说对其进行监管了。他强调AI的安全性取决于人类设计,目前无需过度担忧。马斯克持相反的态度,他认为,尽管「受到监管并不有趣」,可一旦人工智能「可能掌控一切」,制定法规可能就为时已晚。另一方面,支持监管并没有阻碍马斯克的行动,也不妨碍他深度参与人工智能的发展。

3、xAI获60亿美元融资,马斯克拟打造大型超算

xAI本周宣布以超过240亿美元估值获得60亿美元B轮融资。至此,国外大模型在规模上形成包括OpenAI、Google、Anthropic、Meta和xAI等多巨头。据The Information报道,xAI计划部署高达10万个定制芯片,以训练和运行下一代对话AI机器人Grok。马斯克将这些芯片集成至一台超级计算机,称之为「算力超级工厂」,其规模预计为现有最大GPU集群的4倍。

4、革命性AI耳机:在喧嚣中只想听见你的声音

这篇文章介绍了华盛顿大学的一个团队开发的人工智能系统,可以让戴着耳机的人看着说话的人三到五秒钟来“注册”他们。这个系统名为“目标语音听觉”,可以在嘈杂的环境中取消所有其他声音,实时播放注册说话者的声音,即使听者在嘈杂的地方移动并不再面对说话者。

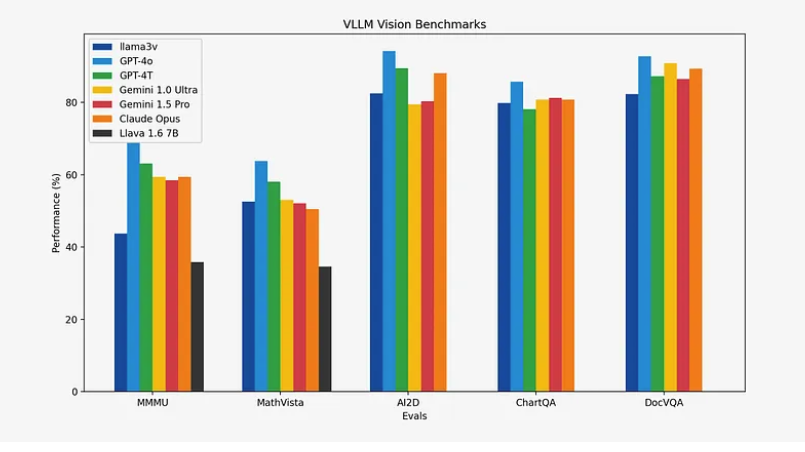

5、Llama3-V:与GPT4-V相当,模型小100倍,成本不到500美元

这篇文章介绍了一个名为“Llama3-V”的项目,旨在构建一个开源的GPT-4V竞争对手,其模型规模比GPT-4V小100倍,成本不到500美元。Llama3在多个基准测试中表现优异,甚至在某些方面超过了GPT3.5和GPT4。为了应对GPT4o的挑战,作者发布了Llama3-V,这是第一个基于Llama3构建的多模态模型。该模型在多模态理解方面比当前最流行的模型Llava有10-20%的性能提升,并在除MMMU之外的所有指标上与规模大100倍的封闭源模型相媲美。

6、谷歌AI搜索发生错误引热议

最近,谷歌的Al搜索出现了诡异问题,导致它开始给出毫无意义甚至滑稽可笑的答案。这些问题目前还不清楚具体错误实例和更多细节。用户纷纷针对这一事件展开讨论,分享各种有趣的解决方法,甚至比较了人类和Al在处理信息和犯错时的相似之处。

7、Suno3.5版本模型向所有人开放

Suno AI音乐创作平台最新推出的3.5版本现已向所有用户开放。现在,用户可以一次性生成完整的4分钟歌曲,只需提供基本的主题和选定偏好的音乐风格,Suno便能够自动生成一首包含完整曲目。对于希望创作更长曲目的用户,平台还支持将歌曲长度扩展至最多2分钟。此外,Suno对歌曲的整体架构和人声部分进行了进一步的优化,让作品更加和谐流畅。

8、Perplexity推出AI版维基百科

本周,Perplexity AI推出了一项创新功能「Pages」,它能够根据网页搜索结果自动编排成一份格式规范、内容丰富的文档。Perplexity宣称,其算法能够构建包含多个章节的详尽文章。用户可以要求AI工具对任何部分进行重写或重新排版,甚至可以删除它们。并且,该功能还可以协助用户搜索并嵌入相关的多媒体素材,例如图片和视频。创始人表示:「Perplexity致力于满足全球的好奇心。我们借鉴了维基百科的模式,并增添了引用功能。我们激动地宣布,通过推出Pages,我们正在将这一理念进一步发展,这可以被视为一种『AI版的维基百科』。」

9、快手上线自研文生图大模型「可图」

近日,快手自研文生图大模型「可图」已于近日正式对外开放。「可图」大模型目前支持文生图和图生图两类功能,可用于AI创作图像以及AI形象定制。用户可通过「可图」微信小程序和网页版使用。

赛博·洞见

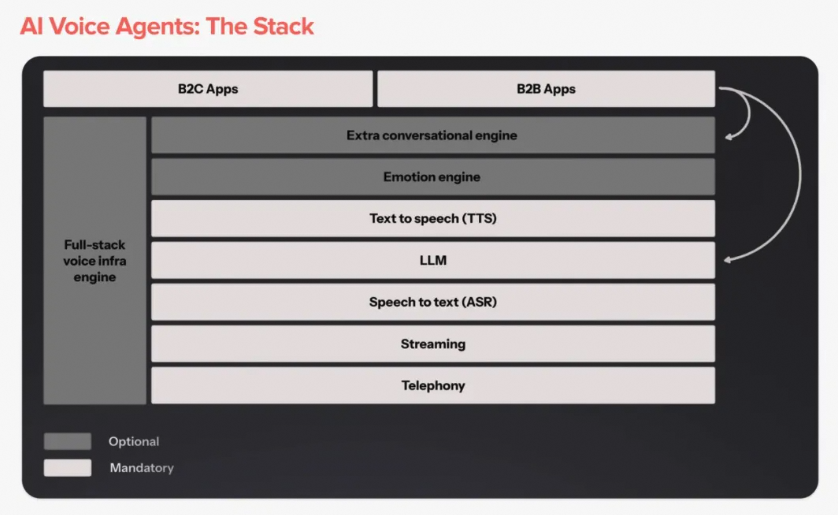

1、a16z发布AI语音Agent图谱:重塑通话的时机到了

本文深入分析了人工智能语音助手的发展机遇、技术架构、未来趋势,并探讨了其在B2B和B2C领域的应用潜力,认为现在是重塑通话的关键时刻。

2、万字长文解析「AIx教育」的前提和路径

万字长文解析AI教育行业,并提出大模型在toB和toC场景的机会:

2C:语言产品(口语/面试/咨询/情感)要注重「场景具象」和「学习投入」

- 具象场景:不仅仅是一个Bot,而是发生在这个场景的所有事、物、人的集合,要以大模型为基座完成,上层做MultiAgent+Workflow。

- 学习投入:长期是「立志」,需要意义赋予,符合认知的榜样;中期是「有用感知」,做法是场景建设,和实际可感知的效果案例输入;短期是「反馈」,需要路径类的形式系统和陪伴。

- 具象场景和学习投入,要创造有趣的、具有挑战的、让用户认为获得物是有意义的系统,并且这个系统有着清晰的规则、目标与量化反馈。最接近这个描述的是游戏。

2B:做结构性替代而非提效

- AI想要在2B端尽快切入和放大价值,就要(几乎)完整替代整个环节。这既可以节约人力成本,又可以降低组织协作成本。

- AI销售和AI助教,是最有希望的两个2B端业务方向。

3、AI后续发展的七个阶段与造富机会

文章分析了从PC到互联网的发展历程,预测AI的发展也将经历以下7个阶段,并详细探讨了每个阶段的特点和商业机会。作者强调AI技术的颠覆性,不仅仅是赋能,而是计算模式的本质性变化,这将导致应用形态的彻底改变。

- 底层基础设施萌芽

- 底层基础设施确立(硬)

- 底层基础设施确立(软,系统级平台)

- 垂域型应用出现

- 平台型应用出现(应用级平台)

- 新工种出现

- 周边的工具

4、AIPMF系列:赚到RMB的AiPPT、赚到美金的ACE Studio和赚到留存的捏Ta | 42章经

42章经访谈系列,以AiPPT(AI生成PPT)、ACE Studio(AI音乐制作)和捏Ta(二次元角色创建)3款已经验证了用户和市场的产品为例,探讨AIPMF的成功经验。

5、从美国软件企业的统计数据看AI的发展情况|5YView

文章基于Emergence Capital发布的《Beyond Benchmarks》报告,分析了600多家B2B SaaS企业的数据,探讨了AI技术在美国软件企业中的发展情况。报告指出:

- 2023年软件企业ARR增长率下降,融资变得困难,但GenAI企业估值和融资规模较高。

- 60%的企业在其产品中使用了GenAI技术,尽管面临盈利挑战,但多数企业通过不同定价模式尝试实现盈利。

- OpenAI的GPT-3.5或GPT-4是首选的LLM。

- 企业在GenAI功能上的研发投入平均增加了200万,而实施GenAI的企业净收入留存率提高了7%。

6、2024.5横向对比各家LLM的Long Context(合集版V1.6)

作者孔某人,文章通过一个长上下文测试方案,横向对比了多家闭源APILLM模型在处理长文本上下文的能力,并指出海外头部厂商在长上下文处理上领先于国内。

7、一种新型的ChatGPT交互方式

一种新的ChatGPT交互样式,具体来说,就是ChatGPT回答的内容中,如果出现了特定名词,可以通过点击的方式在右侧展开这个新的名词的进一步解答,而非滚动当前的对话窗口。同时,每个新的主题都可以继续展开新的对话,这种基于超链接不断跳转的方式和与维基百科类似。

8、演员如何记住台词

这篇文章讨论了演员们如何记忆台词,揭示了记忆的重要真相。演员们并不是通过死记硬背来学习台词,而是通过深入理解台词的含义和将其与已知信息联系起来的方式来记忆。他们会研究剧本,努力理解角色,并看台词如何与角色相关联。

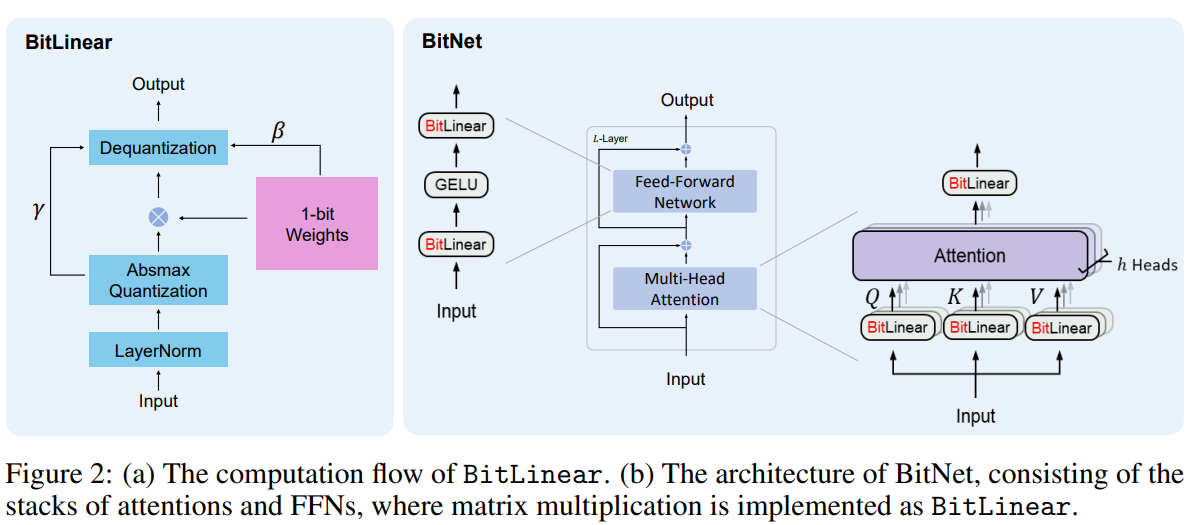

9、量化技术让大语言模型更高效

量化技术正在成为大语言模型领域的“黑马”,它通过压缩模型大小,在提高运行速度的同时,几乎不牺牲准确性。专家们关注量化技术如何改变人工神经网络并发挥对环境的正面影响。此外,对合成数据如何提升模型性能,以及未来硬件发展如何赋予量化技术更大潜力的探讨,也突显了科技界对模型精确性和数据质量的持续探索。

10、揭秘SamAltman短暂离职背后的故事

OpenAI的前董事HelenToner爆料称,前首席执行官Sam Altman曾多次向董事会撒谎,其中包括隐瞒公司所有权结构和在公司内部事务上提供不准确信息。Toner指控Altman多年来一直对董事会隐瞒信息,并对公司的安全程序进行了误导性描述。她表示,这种行为导致董事会无法信任Altman,最终认定他不适合继续担任CEO。

文章还提到,董事会在几次会议中听取了两名高管关于Altman的不良行为的描述,称其存在心理虐待行为,并认为他不适合领导公司实现人工智能的目标。最终,董事会决定罢免Altman,但由于员工威胁要辞职并有传言称微软可能挖角Altman的团队,董事会在不到一周后恢复了Altman的CEO职务。Toner在Altman重返CEO职位不到两周后辞去了OpenAI董事职务。

11、编程与大脑的神秘联系:MIT研究发现编码技能与语言处理不同

MIT的研究揭示,编程并不涉及大脑中处理语言的部分,而是激活了处理复杂认知功能的脑网络。编程技能并不强依赖语言或数学能力,阅读编码涉及到的能力可能独立于我们通常理解的阅读文本或数学解算。

12、ChatGPT负责人:GPT-4越来越聪明是因为post-traning,大模型短期没有数据瓶颈

John Schulman是OpenAI联合创始人、研究科学家(OpenAI现存最主要具有技术背景的创始人),他领导了ChatGPT项目,在OpenAI内部长期负责模型post-traning。本次访谈中,John Schulman主要分享了自己关于模型训练的最新认知。John认为post-training是模型变得越来越聪明的重要原通过不断的post-training优化,GPT-4等模型将变得更加智能和有用。尽管存在一些挑战,如数据瓶颈和模型的泛化能力,但AI的发展将继续前进,并在未来解锁更多新能力,特别是在执行复杂任务和辅助科研方面。

13、大模型的5月:热闹的30天和鸿沟边缘

晚点团队出品,文章回顾了5月份大模型领域的火热动态,包括技术进展的放缓、市场降价背后的技术优化和资金亏损、资金短缺导致一些大模型公司寻求退出、大模型在尚未繁荣之前就面临监管问题,以及行业内部对于如何防范大模型争吵的持续讨论。

赛博·工具

1、二维码美化组件

一个开源的二维码生成组件,支持自定义二维码风格模板、前景、背景、logo等。

2、LLM交互式图表

该网站支持利用GPT-4查询信息并生成统计图表。

3、文字图片美化工具

分享一个免费的文字图片分享工具GeekCard,可以制作精美的书签。另一款类似的工具:Memo Card : Turn your words into beautiful sharing cards!。

赛博·资源

1、大模型训练十戒

Google在线文件Ten Commandments To deploy fine-tuned models in prod,总结了大模型训练的十条戒律,提供了一些指导原则和建议。以下是核心内容:

[1] 切勿微调

- 微调成本高、速度慢且复杂,仅在确实需要时才进行。

- 尽量写prompt,利用大模型本身的能力zero shot,必要时辅以少量样本(few-shot examples)或检索增强生成(RAG)。

[2] 好好调prompt

- 用一个prompt创建一个baseline,并通过写prompt证明这个场景或者任务是可行的。

- 如果写prompt就可以达到基本要求,那么微调可以进一步提升;如果prompt不起作用,微调成功的可能性就很低。

[3] 好好搞数据

- 如果必须微调,确保你完全理解你的数据。

- 大力修正问题数据。数据质量直接决定模型质量。

[4] 用真实的数据

- 确保训练数据尽可能接近生产环境中模型将处理的数据。

- 即使存在一些不完美的数据也没关系,只要整体分布一致和正确就可以。

[5] 必须保留测试集

- 始终保留一部分数据用于测试,以评估模型的性能。

[6] 必须选择合适的模型

- 根据任务和预算选择适当的模型。规模和参数量要匹配任务难度。

- 不要使用过大的模型,也不要使用过小的模型。

[7] 必须小步快跑评估

- 高频自动化评估,可以及时early stop和监控模型异常,提高效率。

[8] 必须慢工细活评估

- 花点时间编写更全面,更可靠的评估标准和评估指标,虽然比较麻烦。

- 评估做不好的话,会影响实验效率,单位时间的算力消耗更多。费时费钱。

[9] 不要即发即弃

- 不要执行一次性的模型训练后就结束。

- 要持续优化模型和pipeline。

[10] 不要死板地遵循这些建议

2、高校资源

【清华大学】

1.学堂在线:学堂在线 - 精品在线课程学习平台

2.深言达意:深言达意 – 找词找句

3.i校对:爱校对官网-免费高效的错别字检查工具

4.九歌:九歌——人工智能诗歌写作系统

5.Vidu:生数科技

6.Aminer:AMiner - AI赋能科技情报挖掘-学术搜索-论文检索-论文专利-文献追踪-学者画像

【北京大学】

1.chatlaw:Chatlaw ——面向未来的法律人工智能

2.中国历代人物:人物志-权威的历史人物传记网站

3.chatexcel:酷表ChatExcel

4.4.华文慕课:华文慕课

5.北大出版社电子书架:北大出版社电子书架

6.识典古籍:识典古籍-古籍在线阅读平台

【复旦大学】

1.MOSS:https://github.com/OpenMOSS/MOSS?tab=readme-ov-file

2.听见世界:mousi

3.LEGO:https://github.com/lzw-lzw/GroundingGPT

【香港大学】

1.anydoor:https://damo-vilab.github.io/AnyDoor-Page/

2.applistener:Eavesdropping Mobile App Activity via Radio-Frequency Energy Harvesting | USENIX

3、精益副业:程序员如何优雅地做副业

作者是一名独立开发者,应用开发和知识付费搞得有声有色,他把自己的副业经营心得,梳理成了一本体系化的手册,然后免费开源了!书籍完稿是2020年底,目前GitHub已经收获了8.7K Star,足见其受欢迎程度。作者还有一本开源小册:《一人企业方法论》,前前后后用了两年的时间,最终完稿6万字,给出了一套完整的「一人企业方法论」,帮助技术/非技术读者创作数字商品,或者基于NoCode/开源项目+AI辅助构建在线服务。

4、【阿里巴巴】2024大模型训练数据白皮书(关注公众号【产品老A】回复【2024大模型训练数据白皮书】下载)

白皮书由阿里巴巴联合数字中国研究院制作,详细探讨了大模型训练数据的重要性、类型、高质量数据的标准、合成数据的应用及其在数据治理中的思考。白皮书认为,为了推动大模型技术的发展,需要构建一个开放、共享、协作的数据生态系统。同时,要重视数据的可及性和安全性,利用合成数据等新技术提升训练数据的质量,并在政府和社会力量之间实现协同合作。

5、【量子位智库】AIGC教育行业全景报告(关注公众号【产品老A】回复【AIGC教育行业全景报告】下载)

报告由量子位智库撰写,深入探讨了AIGC在教育行业的应用现状、变革以及未来趋势,分析了AIGC如何赋能教育产业,并对面临的挑战和发展方向进行了全面梳理。报告指出,教育行业与生成式AI的结合具有高度适配性,能够推动教育普惠和个性化学习。尽管面临准确性、安全性等挑战,但教育大模型的发展和应用前景广阔。报告预测了AIGC教育的四大趋势,包括跨学科理解、多模态演进、AIPC和XR技术的应用,以及AI智能体的具象化发展。

【推广时间】

有做模型推理、微调、AI绘画出图,需要GPU资源的朋友们,可以试试UCloud云计算旗下的Compshare这家GPU算力云平台,4090性价比高,单卡按时2.6元,免费200G磁盘。单卡一个月价格在1250元,还是很香的。现在通过链接注册联系客服可以获得20元代金券,同时现在还有个内容激励活动,发布分享一些AI绘画。模型微调、推理,大模型相关的文章带上他们平台,还可以拿500元代金券,可以白嫖好久的算力了,大家可以试试。

高性价比4090算力租用,注册就送20元代金券,更有内容激励活动:GPU算力平台 | 面向AI场景的高性价比GPU租用平台

GPU云服务器租用,P40、4090、V100S多种显卡可选:GPU云服务器租用_GPU云主机限时特惠-UCloud中立云计算服务商

这篇关于Cyber Weekly #9的文章就介绍到这儿,希望我们推荐的文章对编程师们有所帮助!