本文主要是介绍二百三十八、Hive——Hive中为每条数据创建唯一ID,希望对大家解决编程问题提供一定的参考价值,需要的开发者们随着小编来一起学习吧!

一、目的

由于Kafka的JSON中缺少唯一的ID标识字段,因此发现后面的需求中DWD层表需要有一个唯一ID字段,这样才能与数据质量表更好的关联

二、Hive版本

尚硅谷的3.1.2版本

三、Hive创建唯一ID方法

网上的创建唯一ID方法有很多,这里展示一些,当然我并没有全部测试过

3.1 使用Hive的内置函数

Hive本身并没有直接为每条数据生成唯一ID的内置函数,但你可以结合使用Hive的内置函数和表的元数据来实现。例如,如果你有一个带有时间戳的列,你可以使用from_unixtime(unix_timestamp())函数结合其他列的值来生成一个相对唯一的值。但是,请注意这种方法并不保证全局唯一性。

3.2 使用Hive的Row_Number()窗口函数

如果你的数据已经按照某种顺序排序(例如,按照时间戳),你可以使用ROW_NUMBER()窗口函数为每条数据分配一个唯一的行号。但是,这要求你的数据在排序后保持不变,并且不适用于分布式环境中的并发写入。

3.3 使用Hive的UUID()函数(如果可用)

某些版本的Hive或Hive的某些扩展可能提供了生成UUID的函数。UUID是全局唯一标识符,通常用于在分布式系统中为实体分配唯一的ID。但是,请注意不是所有的Hive发行版都支持这个函数。

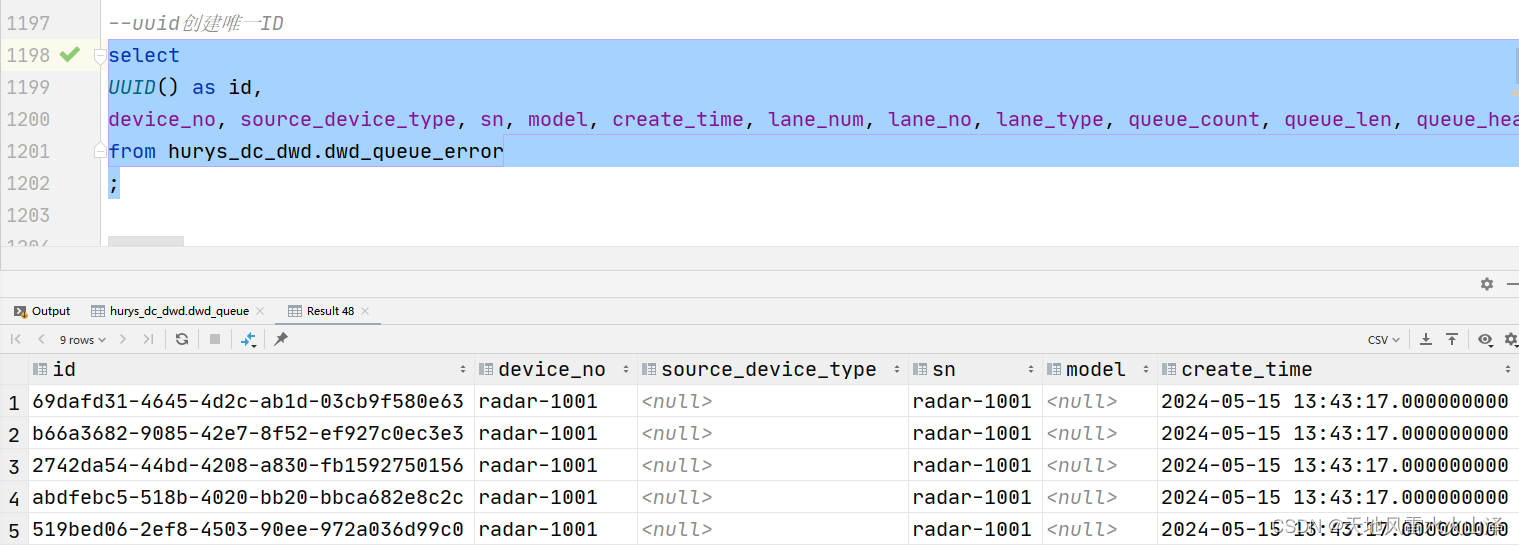

第一个测试的就是UUID()函数,发现Hive3.1.2这个版本支持这个函数,因此就使用这种方法,简单有效!

select

UUID() as id,

device_no, source_device_type, sn, model, create_time, lane_num, lane_no, lane_type, queue_count, queue_len, queue_head, queue_tail, day

from hurys_dc_dwd.dwd_queue_error

;

3.4 使用自定义UDF

如果你需要更复杂的逻辑来生成唯一ID,或者Hive的内置函数无法满足你的需求,你可以编写一个自定义的UDF。这个UDF可以在Java、Scala或其他支持的语言中编写,并在Hive中注册和使用。UDF可以访问输入行的所有列,并基于这些列的值生成唯一的ID。

有朋友说可以通过雪花算法,这种就是自定义UDF,还要写Java代码

3.5 在数据写入之前生成ID

如果你是在将数据写入Hive之前(例如在ETL过程中)生成ID,那么你可以使用任何你喜欢的方法来生成这些ID,只要它们在你的数据集中是唯一的。然后,你可以将这些ID作为数据的一部分写入Hive表。

3.6 使用外部系统

对于需要高度可靠和全局唯一的ID的场景,你可能需要考虑使用外部系统(如ZooKeeper、Kafka等)来生成这些ID。这些系统通常提供了用于生成唯一ID的API或功能。然后,你可以将这些ID作为数据的一部分写入Hive表。

这些就是在Hive中创建唯一ID的方法,如果是支持UUID()函数的话,那这种方法最简单有效!

这篇关于二百三十八、Hive——Hive中为每条数据创建唯一ID的文章就介绍到这儿,希望我们推荐的文章对编程师们有所帮助!