arkit专题

【iOS ARKit】USDZ文件

USDZ 概述 ARKit 支持 USDZ(Universal Scene Description Zip,通用场景描述文件包)、Reality 两种格式的模型文件,得益于 USDZ的强大描述能力与网络传输便利性,使得iOS 设备能够在其信息(Message)、邮件(Mail)、浏览器(Safari)等多种应用中实现 AR功能,AR 体验的共享传播也变得前所未有地方便。USDZ

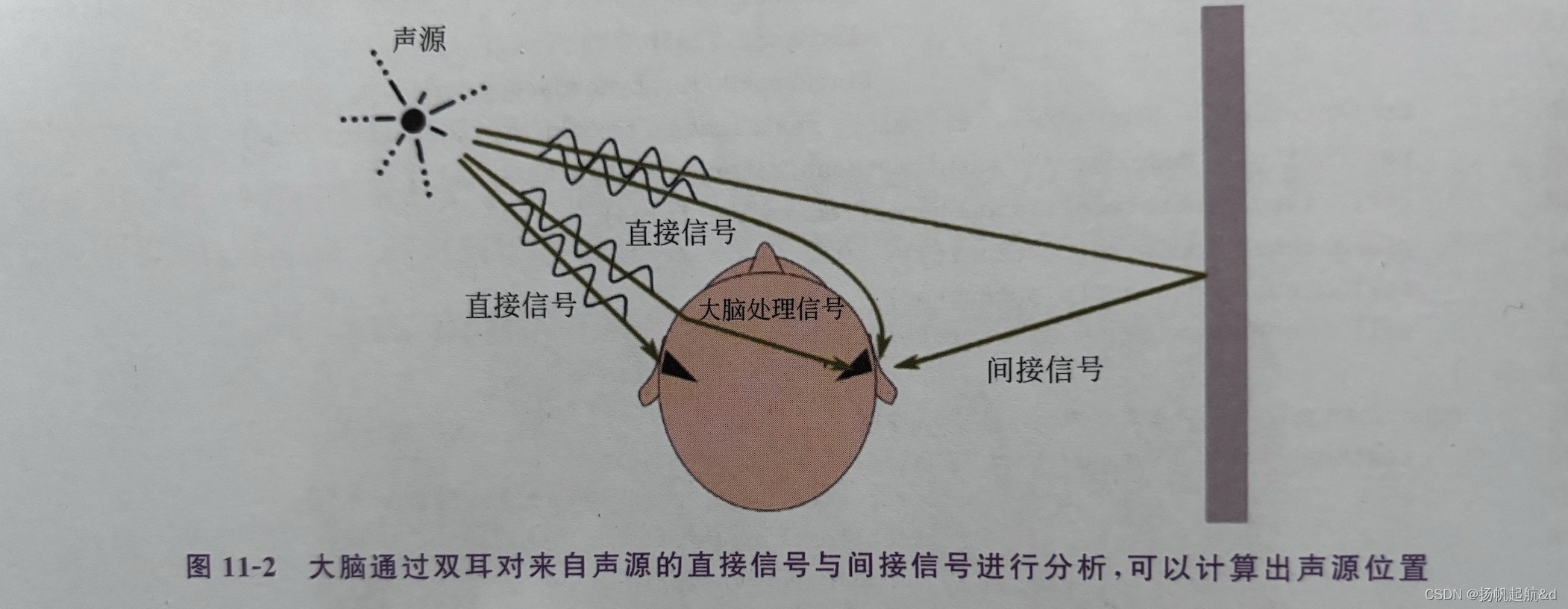

【iOS ARKit】播放3D音频

3D音频 在前面系列中,我们了解如何定位追踪用户(实际是定位用户的移动设备)的位置与方向,然后通过摄像机的投影矩阵将虚拟物体投影到用户移动设备屏幕。如果用户移动了,则通过VIO 和 IMU更新用户的位置与方向信息,更新投影矩阵,这样就可以把虚拟物体固定在空间的某点上(这个点就是锚点),从而达到以假乱真的视觉体验。 3D音效处理的目的是让用户进一步相信AR 应用虚拟生成

【iOS ARKit】PhysicsMotionComponent

使用 Physics BodyComponent 组件,通过设置物理参数、物理材质、施加作用力,能完全模拟物体在真实世界中的行为,这种方式的优点是遵循物理学规律、控制精确,但缺点是不直观。使用 PhysicsMotion Component组件则可以通过直接设置速度进行物理模拟,但需要明白的是,对物体施加力与设置物体速度是两种完全不同且不相容的操作,无法混合使用。 下面我们

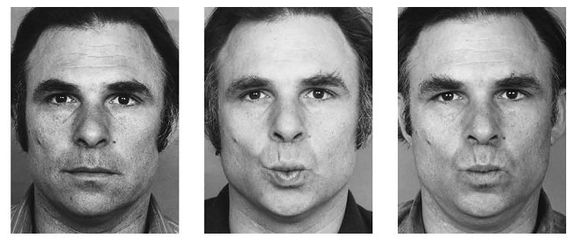

DAZ to maxon 实时面捕52个blendshapes 表情模板基本形中英文对照表ARkit 52个表情名称、顺序

一、DAZ to maxon 实时面捕52个blendshapes DAZ to maxon 实时面捕52个blendshapes 表情模板基本形中英文对照表 - 哔哩哔哩 很多学员反映实时表情怎么就不同步呢?这个问题其实很常见。 第一:表情模板的顺序弄错,导致表情错乱。 第二:表情模板不标准,虽然是千人前面,但是笑不能搞一个哭的表情模板吧。 第三:驱动器链接错乱,关系一定要对应。

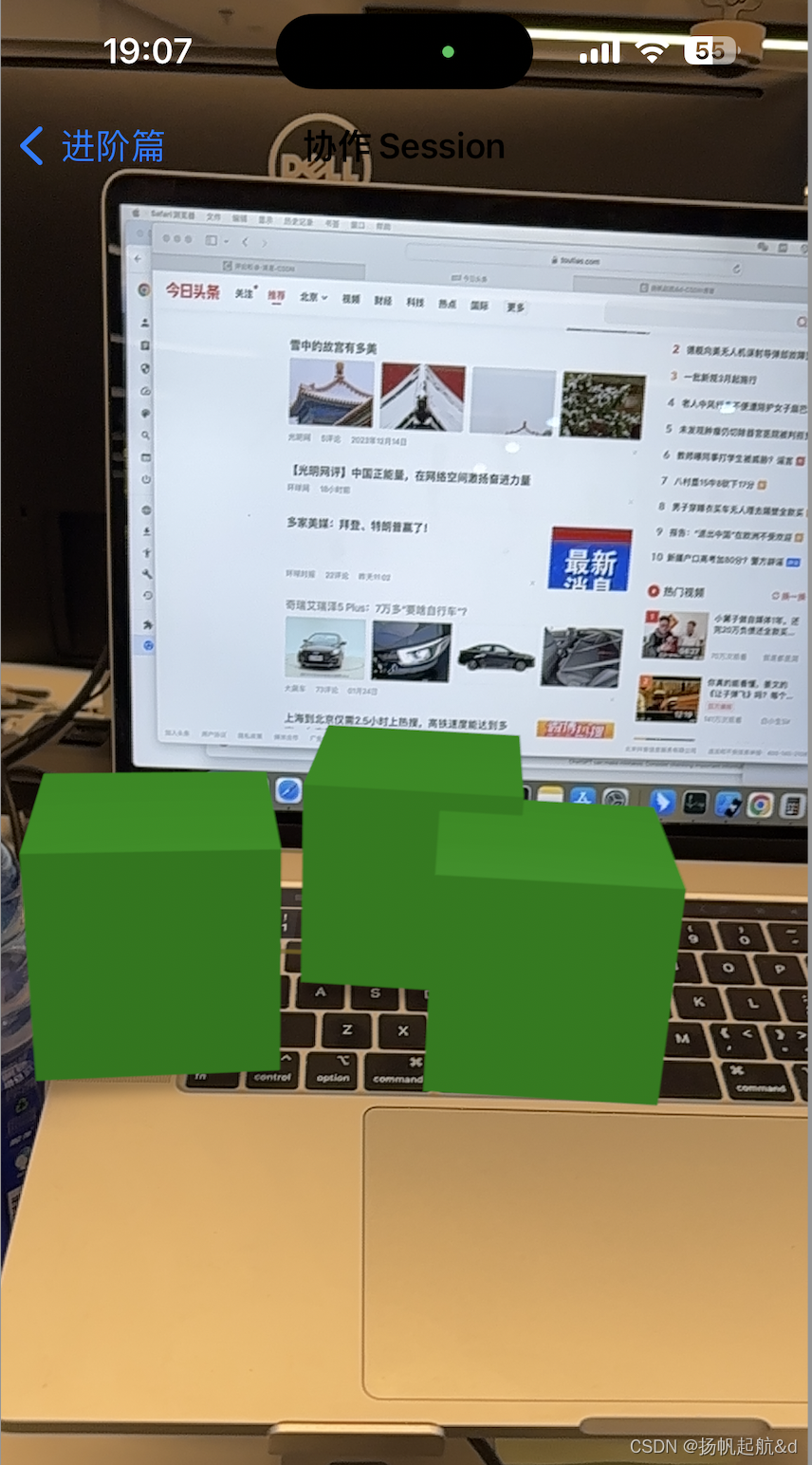

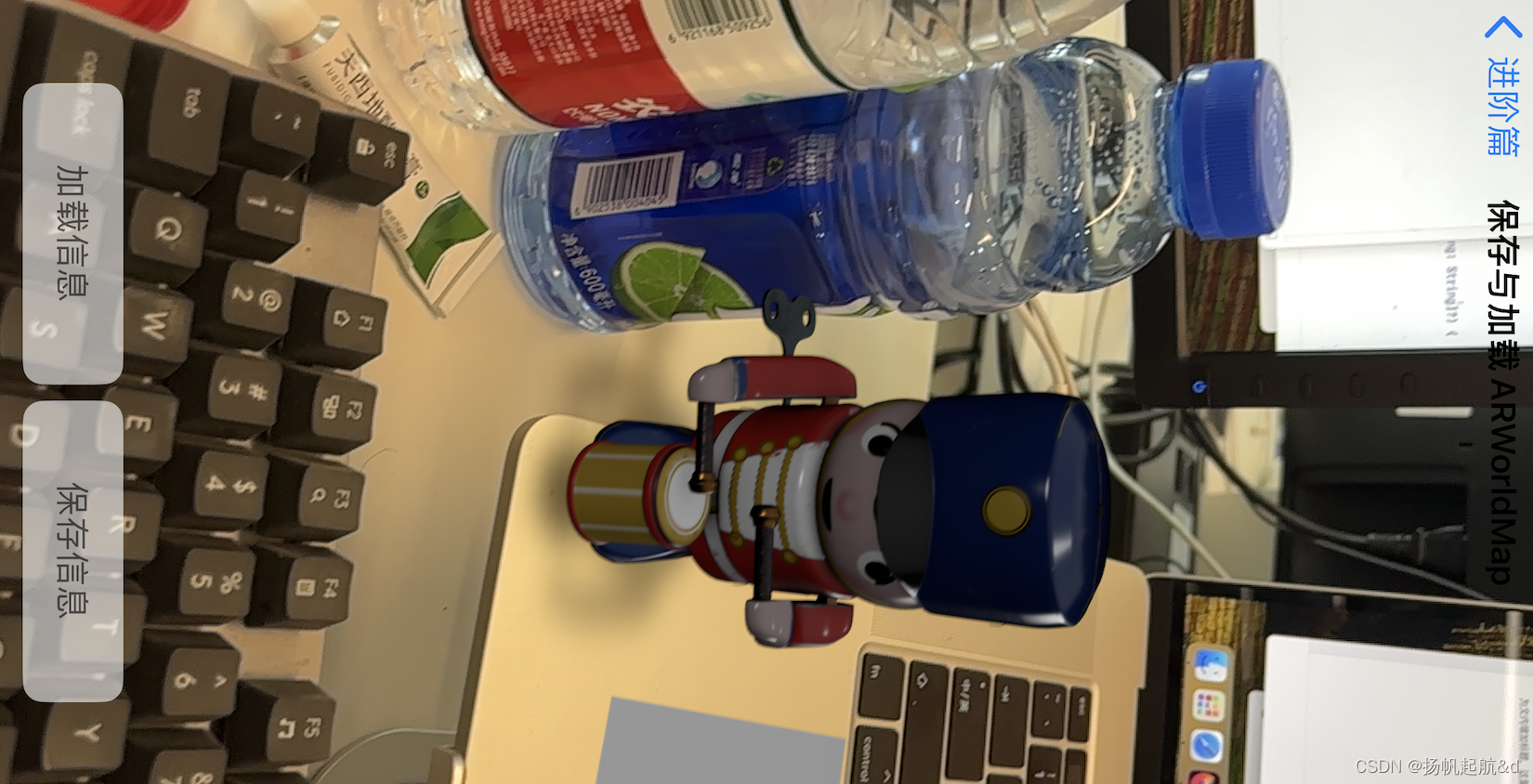

【iOS ARKit】协作 Session 实例

协作 Session 使用注意事项 协作 Session 是在 ARWorldMap 基础上发展起来的技术,ARWorldMap 包含了一系列的地标、ARAnchor 及在观察这些地标和 ARAnchor 时摄像机的视场(View)。如果用户在某一个位置新创建了一个 ARAnchor,这时这个 ARAnchor位置并不是相对于公共世界坐标系的(实际上此时用户根本就不知道是否还有其他参

【iOS ARKit】ARWorldMap

ARWorldMap 用于存储 ARSession 检测扫描到的空间信息数据,包括地标(Landmark)、特征点(Feature Point)、平面(Plane)等,以及使用者的操作信息,如使用者添加的 ARAnchor 和开发者自定义的一些信息。ARWorldMap 可以看作 ARSession 运行时的一次状态快照。 在技术上,每个具备世界跟踪的 ARSession

【iOS ARKit】人形遮挡

人形遮挡简介 在 AR系统中,计算机通过对设备摄像头采集的图像进行视觉处理和组织,建立起实景空间,然后将生成的虚拟对象依据几何一致性原理嵌入到实景空间中,形成虚实融合的增强现实环境,再输出到显示系统中呈现给使用者。 正确实现虚拟物体与真实环境的遮挡关系,需要基于对真实环境3D结构的了解,感知真实世界的3D结构、重建真实世界的数字3D模型,然后基于深度信息实现正确的遮挡

【iOS ARKit】人形提取

为解决人形分离和深度估计问题,ARKit 新增加了 Segmentation Buffer(人体分隔缓冲区)和Estimated Depth Data Buffer(深度估计缓冲区)两个缓冲区。人体分隔缓冲区作用类似于图形渲染管线中的 Stencil Buffer(模板缓冲区),用于区分人形区域与背景区域,它是一个像素级的缓冲区,用于精确地描述人形区域。 人体分隔缓冲区用于

【iOS ARKit】3D 人体姿态估计

与基于屏幕空间的 2D人体姿态估计不同,3D人体姿态估计是尝试还原人体在三维世界中的形状与姿态,包括深度信息。绝大多数的现有3D人体姿态估计方法依赖2D人体姿态估计,通过获取 2D人体姿态后再构建神经网络算法,实现从 2D 到 3D人体姿态的映射。 在 ARKit中,由于是采用计算机视觉的方式估计人体姿态,与2D人体姿态估计一样,3D人体姿态估计也受到遮挡、光照、姿态、

【iOS ARKit】手动配置环境探头

在上节中我们已经了解了环境探头以及如何使用自动环境探头,这节一起了解如何使用手动配置环境探头。 在使用自动环境反射时,开发人员无须进行有关环境反射的任何操作,只需要设置自动环境反射即可,其余工作完全由 RealityKit 自动完成,这适用于基本的常见环境反射。但这种环境反射方案是一种普适性的反射,并没有专门针对某特定虚拟元素进行优化,在某些情况下效果并不精细,并且我们

【iOS ARKit】光照效果--光源

光照 在现实世界中,光扮演了极其重要的角色,没有光万物将失去色彩,没有光世界将一片漆黑。在3D数字世界中亦是如此,3D数字世界本质上是一个使用数学精确描述的真实世界复本,光照计算是影响这个数字世界可信度的极其重要的因素。 光源 顾名思义,光源即是光的来源,常见的光源有阳光、月光、星光、灯光等。光的本质其实很复杂,它是一种电磁辐射但却有波粒二象性(我们不会深入研究光学,那将

【iOS ARKit】光照估计

光照估计 AR与VR 在光照上最大的不同在于VR 世界是纯数字世界,有一套完整的数学模型,而AR则是将计算机生成的虚拟物体或关于真实物体的非几何信息叠加到真实世界的场景之上实现对真实世界的增强,融合了真实世界与数字世界。就光照而言,VR中的光照完全由开发人员决定,光照效果是一致的,即不会受到运行时其他因素的影响,而AR 中则不得不考虑真实世界的光照与虚拟的3D光照信息的一致性,举

【iOS ARKit】同时开启前后摄像头BlendShapes

在上一节中已经了解了 iOS ARkit 进行BlendShapes的基本操作,这一小节继续实践同时开启前后摄像头进行人脸捕捉和世界追踪。 iOS设备配备了前后两个摄像头,在运行AR 应用时,需要选择使用哪个摄像头作为图像输人。最常见的AR 体验使用设备后置摄像头进行世界跟踪、虚实融合,通常使用 ARWorldTrackingConfiguration 配置跟踪使用者的真

【iOS ARKit】人脸追踪之挂载虚拟元素

人脸跟踪(Face Tracking)是指将人脸检测扩展到视频序列,跟踪同一张人脸在视频序列中的位置。是论上讲,任何出现在视频中的人险都可以被跟踪,也即是说,在连续视频帧中检测到的人脸可以被识别为同一个人。人脸跟踪不是人脸识别的一种形式,它是根据视频序列中人脸的位置和运动推断不同视频帧中的人脸是否同一人的技术。 挂载虚拟元素 在iOS Realitykit 中,

ARKit首推家具领域应用demo,十二居首当其冲!

关键词:ARKit家具|ARKit家装|ARKit家居 自从苹果在WWDC大会上宣布iOS 11和ARKit以来,苹果和开发团队一直在全速前进。开发人员已经开始尝试ARKit,并创建不同的演示程序来展示API(应用程序界面,Application Program Interface)的潜力。 今年秋天,将有数百万部iphone和ipad升级到iOS 11,这使得

iOS ARKit推流到WebRTC

背景 直播SDK接入iOS ARKit。 WebRTC数据传入 创建PeerConnection的时候需要创建一个VideoTrackSourceInterface对象,该对象可以作为外部视频数据传入WebRTC的入口。 ARKit数据来源 ARKit有两种数据,一种是直接从摄像头采集到的原始数据,一种是经过AR渲染的数据,也就是我们直观看到的增强现实

生命游戏代码_从零开始学基于ARKit的Unity3d游戏开发系列11

欢迎回到我们的学习。 到目前为止,敌人的各种功能可以说是比较齐备了,但是作为玩家,却只能被动挨打,不能主动攻击。 因此,在本课的内容中,我们将实现对敌人的反击。为此,我们需要学习Unity中Physics.Raycast的概念。 首先在官方API文档中查看与之相关的定义: https://docs.unity3d.com/ScriptReference/Physics.Raycast.h

ARKit 最简单的一个Demo

AR最简单的一个Demo 参考了苹果官网关于搭建一个最基本的AR效果,然后这里把demo讲一下,由于有很多概念没有理解完全,所以有些地方有纰漏的话,可以拍砖一起讨论。 这里一定要注意,开发环境为Xcode 9, 运行环境是iphone 6s及以上设备,系统是iOS11。 因为苹果规定(点这里查询)ARKit是运行在 A9 和 A10处理器上,所以 iphone 或者 ipad 自行对照自己的C

⭐ Unity + ARKIT ARFace脸部追踪

相比之前的图像物体检测,这脸部检测实现起来会更加的简单。 (1)首先我们先在场景中的物体上添加一个AR Face Mananger组件: (2)以上組件的 Face Prefab所代表的就是脸部的模型也就是覆盖在脸部上面的投影模型,它会根据你脸部的肌肉特征等一起动,Maximum Face Count参数所代表的为在同一场景中能同时检测的最多脸部数量。 (3)制作Face Prefab,我们首

WWDC2023 Metal swift 头显ARKit支持c c++ 开发

1 今年WWDC,我们看见了苹果的空间计算设备,visionOS也支持了c c++ API. 这有什么好处呢,不是说能够吸引更多c c++开发者加入苹果开发者阵营,而是我们过去的很多软件,可以轻松对接到苹果的头显设备,让我们的软件支持苹果头显全新的交互。 例如我们过去的游戏引擎,用c#开发,或者别的语言开发的,那我们就可以很轻松写一个c c++版本的插件,让游戏引擎支持ARKit空间计算,以及

ARKit OpenGL ES - ARKit原理篇

原文链接: http://www.jianshu.com/p/a4052877f8a5 如果你想了解更多关于OpenGL ES的知识,请移步至OpenGL ES相关文章目录本文所用的代码在https://github.com/SquarePants1991/OpenGLESLearn.git的ARKit分支中。 iOS11推出了新框架ARKit,通过ARKit和SceneKit可以很方便

ARKit从入门到精通(1)--显示Cube(原生方法实现)

在全新AR开发专栏的第一篇我们通过一个简单的project(在显示环境放置一个cube)来了解ARKit的核心功能与API特性。通过这个过程,你将了解ARKit如何在真实的设备中工作,从而与创建的3D对象进行交互。 前提说明 本部分教程使用的是原生iOS开发,目前不涉及Unity,主要使用SceneKit。 使用的软件版本:Xcode 9。 使用的开发语言版本:Swift 4 本系列专

Why is ARKit better than the alternatives?

苹果在今年的 WWDC 上发布的 ARKit 对增强现实领域(Augmented Reality)产生了巨大的影响。开发者首次发现,一款强大并广泛可用的 AR SDK“恰好”适用于他们的 App。它不需要对标记、初始化、深度摄像机和专用的创建工具进行修改。不出所料,这引发了一阵 Demo 热潮。但是大部分开发者都不知道 ARKit 的工作原理,也不了解其优于其他 SDK 的具体原