animatediff专题

AI绘画【SD教程】进阶篇,文生图复现金克斯动漫形象,用AnimateDiff动画插件让她动起来!AI动画教程建议收藏

大家好,我是画画的小强 当你成功安装了AI绘画工具 SD(Stable Diffusion)后,是否也产生过这样的疑惑:为何我创作的图片与他人的作品在风格和质量上存在差异? 实际上,在AI绘画的领域中,对于SD而言,其核心秘诀在于选取一个恰当的大型模型和灵活运用专业的Lora包。 今天,我将为大家揭示如何使用lora包来创造出具有高度真实感和质感的金克斯图片,并让你的图片动起来!

AI绘画Stable Diffusion神级插件AnimateDiff超稳动画教程来了!手把手教你一次性学会

大家好,我是设计师阿威 今天给大家分享AI做稳定动画的新教程,这一次的稳定效果,比上一次和上上次都更加惊艳,而且实现难度直线下降!几乎可以说是有手就会,非常适合追求高效高质效果的商用场景! 重点是:更简单!更高效! 今天我们就来用标题中的SD插件AnimateDiff做一个动画视频,AnimateDiff插件下载请扫描获取哦 AnimateDiff在SD的webUI中使用起来,那是非

AIGC-AnimateDiff-基于T2I模型的动态生成论文详细解读

AnimateDiff: Animate Your Personalized Text-to-Image Diffusion Models without Specific Tuning github:https://github.com/guoyww/animatediff/ 论文:https://arxiv.org/abs/2307.04725 AnimateDiff 通过预训练

StableDiffusion 文生视频教程,从Mov2mov到AnimateDiff

文章目录 0. 前言1. 简介2. 文生视频2.1 Mov2mov2.1.1 插件安装2.1.2 视频生成 2.2 ffmpeg + Ebsynth2.2.1 ffmpeg 安装2.2.2 Ebsynth安装2.2.3 Ebsynth 插件安装2.2.4 视频生成2.2.4.1 Step 1 蒙版裁剪2.2.4.2 Step2 识别关键帧2.2.4.3 Step3~4 关键帧重绘2.2.4.

字节发布AnimateDiff-Lightning文生视频模型——可在线免费试玩

Sora文生视频大模型 随着Sora文生视频大模型的爆火,文生视频大模型必定是各大人工智能公司竞争的主要领域。虽然 Sora模型的视频效果绝对是领先地位,但是Sora模型目前还没有开放使用,我们并无法直接使用。前期我们也介绍过字节发布的MagicVideo2文生视频模型,但是MagicVideo2并没有提供开源或者试用地址。 MagicVideo2文生视频大模型 本期我们介绍

[ComfyUI进阶教程] animatediff视频提示词书写要点

1)animatediff视频提示词书写要点 1.使用图生视频:提前用MJ或者SD生成构图,放到animate来进行视频生成 2.加上运动效果:使用镜头模型,增加动态效果 3.手部隐藏:AI绘画对手的姿势不太友好,可以在生成的构图中隐藏手(比如增加提示词:手在背后) 4.提示词不要太复杂:comfyui的提示字符数不能太多,在animate提示词中,不要放太多的画质修饰词。 5.成熟稳

comfyUI + animateDiff video2video AI视频生成工作流介绍及实例

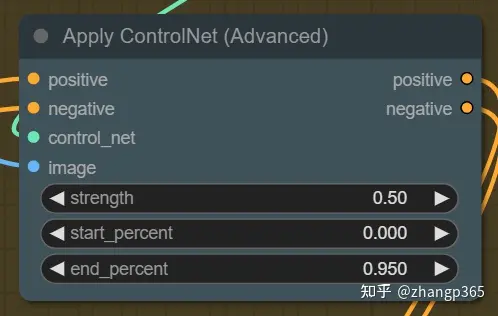

原文:comfyUI + animateDiff video2video AI视频生成工作流介绍及实例 - 知乎 目录 收起 前言 准备工作环境 comfyUI相关及介绍 comfyUI安装 生成第一个视频 进一步生成更多视频 注意事项 保存为不同的格式 视频宽高设置 种子值设置 提示词与负向提示词 节点变换提示词 controlnet权重控制 总结 参考 前言

2023-12-17 AIGC-AnimateDiff详细安装和使用教程

AnimateDiff专用模型下载 AnimateDiff有其自身专门的运动模型mm_sd_v15_v2.ckpt 和 专属的镜头运动lora,需要放置在对应的位置。 stablediffusion位置: 运动模型放在stable-diffusion-webui\extensions\sd-webui-animatediff\model里面 运动lora放在stable-diffusi

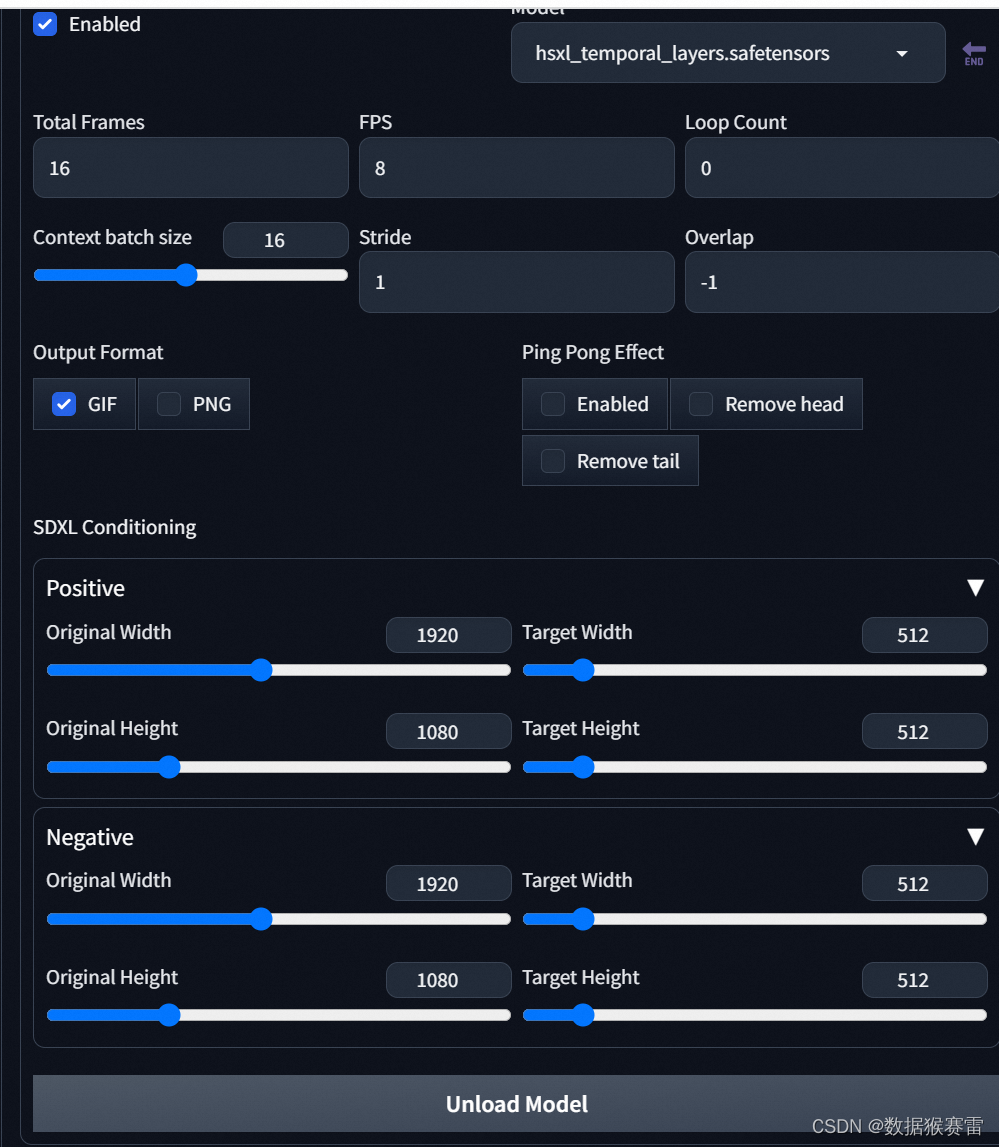

SDXL使用animateDiff和hotshot-xl进行文生视频

截至2023.12.8号,目前市面上有两款适用于SDXL的文生视频开源工具,分别是AnimateDiff和hotshot-xl。 一、工具下载链接 (1)AnimateDiff的webui版本的git链接: GitHub - continue-revolution/sd-webui-animatediff: AnimateDiff for AUTOMATIC1111 Stable Diffu

![[ComfyUI进阶教程] animatediff视频提示词书写要点](/front/images/it_default2.jpg)