airllm专题

LLM推理部署(五):AirLLM使用4G显存即可在70B大模型上进行推理

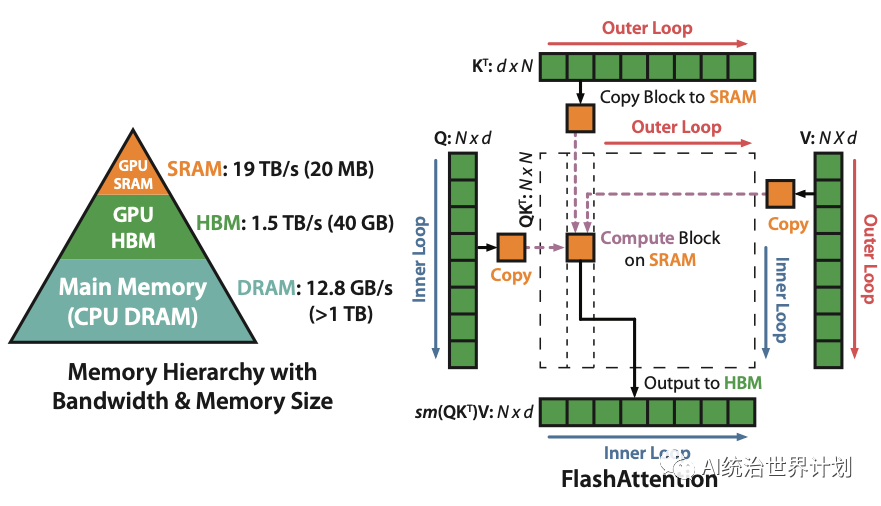

众所周知,大模型的训练和推理需要大量的GPU资源,70B参数的大模型需要130G的GPU显存来存储,需要两个A100(显存为100G)。 在推理过程中,整个输入序列也需要加载到内存中进行复杂的“注意力”计算,这种注意力机制的内存需求与输入长度成二次方关系。 一、分层推理(Layer-wise Inference) 分层推理是计算机科学中分而治