aft专题

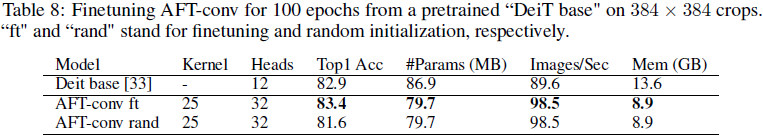

(2021,AFT,MHA,RWKV 基础,线性内存复杂度)无注意力的 Transformer

An Attention Free Transformer 公和众和号:EDPJ(进 Q 交流群:922230617 或加 VX:CV_EDPJ 进 V 交流群) 目录 0. 摘要 2. 多头注意力(MHA) 3. 方法 3.1 无注意力 Transformer 3.2 AFT 变体:局部性、权重共享和参数化 5. 实验 0. 摘要 我们引入了 Attention