accumulator专题

Flink 计数器Accumulator

简述 在 Apache Flink 中,Accumulator 是一个用于收集作业执行期间聚合信息的工具。它允许在用户定义的函数(如 MapFunction, FlatMapFunction, ProcessFunction 等)中累积值,并在作业完成后检索这些值。这对于跟踪诸如事件数量、处理延迟等统计信息非常有用。 要使用 Accumulator,需要首先定义一个 Accumulator 接

spark的Accumulator累加器使用及 自定义Accumulator功能

一、spark的累加器Accumulator 使用Accumulator时,为了保证准确性,只使用一次action操作。如果多次action操作,会造成累加器值错误。 解决方案:将任务之间的血缘依赖关系切断就可以了。什么方法有这种功能呢?cache,persist,调用这个方法的时候会将之前的依赖切除,后续的累加器就不会再被之前的transfrom操作影响到了。 二、自定义Accum

Spark程序设计——accumulator、广播变量、cache

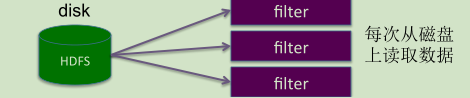

(一)accumulator(累加器、计数器) 类似于MapReduce中的counter,将数据从一个节点发送到其他各个节点上去。 通常用于监控,调试,记录符合某类特征的数据数目等。 –分布式counter Accumulator使用 import SparkContext._val total_counter=sc.accumulator(OL,"total_counter")//