accepted专题

datax採集sqlserver報錯:not accepted by client preferences [TLS13, TLS12]

datax報錯: Security providers: [SUN version 1.8, SunRsaSign version 1.8, SunEC version 1.8, SunJSSE version 1.8, SunJCE version 1.8, SunJGSS version 1.8, SunSASL version 1.8, XMLDSig version 1.8, SunPC

spark集群在执行任务出现nitial job has not accepted any resources; check your cluster UI to ensure that worker

1 spark集群在执行任务时出现了: 2 原因:这是因为默认分配的内存过大(1024M) 3 解决方法: 在conf/spark-env.sh下添加export SPARK_WORKER_MEMORY=512和export SPARK_DAEMON_MEMORY=256

提示:The server selected protocol version TLS10 is not accepted by client preferences [TLS13, TLS12]

JMeter连接SQLservice数据库。 1、测试计划添加sqljdbc41.jar 2、添加数据库配置 3、添加请求 3、按着上面的配置,执行,然后报错误了。 提示“Cannot create PoolableConnectionFactory (The driver could not establish a secure connection to SQL Serv

ACM-ICPC 2018 沈阳赛区网络预赛 B Call of Accepted

ACM-ICPC 2018 沈阳赛区网络预赛 Call of Accepted 题意:给定字符串,字符串有 + - * d ( ) 还有数字,表示一个运算式子,d 表示一种新运算符,x d y 表示 最小为 x 最大 为 x*y ,求字符串能表示的最大值。 #include <bits/stdc++.h>using namespace std;int len;int fst[

使用idea连接SQL Server数据库出错TLS10 is not accepted

使用idea连接数据库时,发现提示错误: 驱动程序无法通过使用安全套接字层(SSL)加密与 SQL Server 建立安全连接。错误:“The server selected protocol version TLS10 is not accepted by client preferences [TLS13, TLS12]”。等等出错提示。 可能有两个地方要修改: 一、JDK安装目录的java.

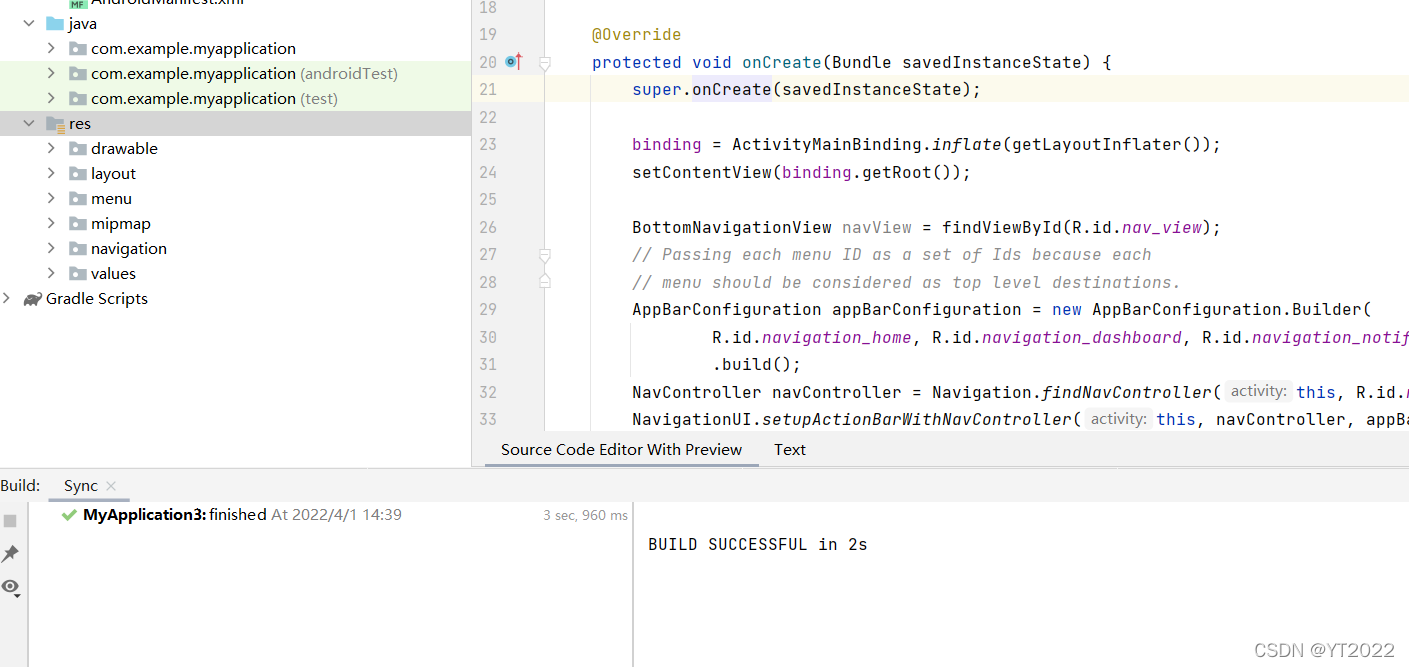

Android编译报错:License for packaqe Android SDK Build-Tools 28.0.3 not accepted.

错误的场景是这样的,如图: 大致图里意思是项目缺少(项目里引用了28到30,然后找不到)sdk 的28版本到30版本,那我们就去工具找选项下载,如下图操作:吧sdk的28到30都勾选上,然后Apply,再点击OK,然后再编译下就可以了

hdoj 1177 Accepted today?

是判断第m个得的奖!! Problem Description Do you remember a sentence "Accepted today?" Yes, the sentence is mentioned frequently in lcy's course "ACM Programming"! The contest is still in progress this m

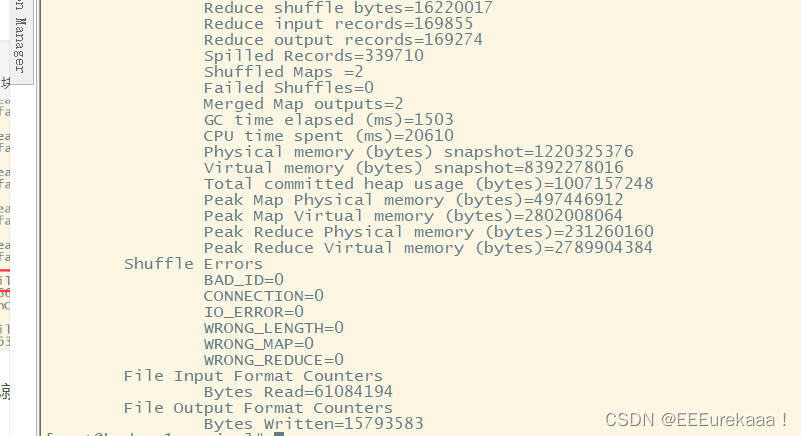

MapReduce 作业状态卡死 ACCEPTED: waiting for AM container to be allocated, launched and register with RM.

前言:配置好了yarn后,跑wordcount的例子,但是一直未完成。web页面查看任务状态为:ACCEPTED: waiting for AM container to be allocated, launched and register with RM. 在web页面查看其状态,如果active nodes为0,首先考虑是nodemanager没有正常启动。(下图是已经正常启动后,完成

Spark作业一直处于ACCEPTED状态

原因1:集群处于不健康状态 打开yarn监控页面,查看nodes 状态 如果Unhealthy Nodes列不为0,说明有的节点不健康,可以点进去查看详情,处理完并且集群处于健康状态后可尝试再次提交作业。 原因2:作业资源分配太小 可增大conf yarn.nodemanager.resource.memory-mb、executor-memory参数值以提高内存分配

解决mapreduce一直处在runing job(accepted)阶段

1.首先查看自己虚拟机的nodemannager和resourcemannager是否成功启动,如果没有去重启试试,如果重启仍不成功,那么去检测配置文件是否出错 2.如果是你首次运行mapreduce程序,检测是否是自己的虚拟机内存不够。 3.如果是突然出现这个情况(我遇到的) 解决方法: 输入以下命令: 老版本:hadoop job -list新版本:yarn a

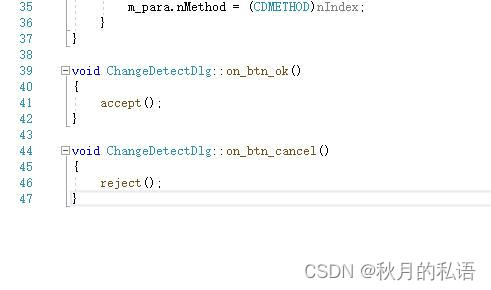

QDialog执行accepted() accept()不退出

最近写QT对话框程序,发现一个奇怪的现象,明明是两个相同的对话框,点击了确认按钮,一个正常退出,一个怎么都不退出! 我很奇怪,为什么accepted()之后不退出! 代码如下: 经过对比,我发现原来我犯了个愚蠢的错误!我把 accept()函数写成了accepted(),实际上accepted()是个信号! 来自qt助手里的解释: (1) QDialog::Accepted : 模态对

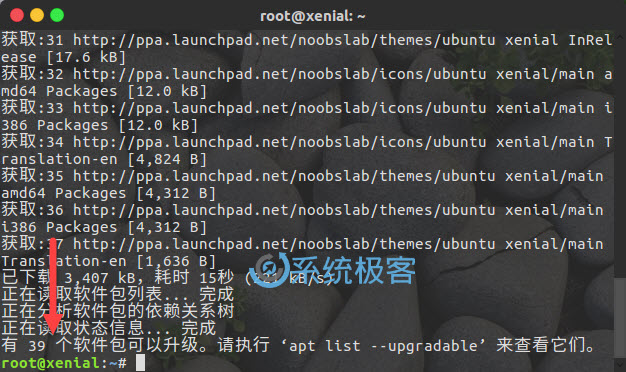

This must be accepted explicitly before updates for this repository can be applied. See apt-secure

安装ps命令使用如下命令遇到问题 apt-get update && apt-get install procps # apt-get update && apt-get install procpsGet:1 http://security.debian.org/debian-security buster/updates InRelease [65.4 kB]Get:2 http://

【我的Android进阶之旅】解决错误:You have not accepted the license agreements of the following SDK components

一、错误描述 今天有个同事编译项目的时候,出现了如下所示的错误: Checking the license for package CMake 3.6.4111459 in /data/opt/android/sdk/licensesWarning: License for package CMake 3.6.4111459 not accepted.FAILURE: Build faile

解决报错:The server selected protocol version TLS10 is not accepted by client preferences [TLS13, TLS12]

>>> 近期更新idea版本到2022.2.3后, 使用idea自带的数据库管理工具连接SQLServer2014数据库时出现问题: ``` [08S01] 驱动程序无法通过使用安全套接字层(SSL)加密与 SQL Server 建立安全连接。错误:“The server selected protocol version TLS10 is not accepted by client pre

License for package Android SDK Platform 31 not accepted.解决方案

License for package Android SDK Platform 31 not accepted. 在运行Android Stduio时候出现了这个问题 解决方案: 点击File–Project–Structure 点击app Complier SDK Version 将数值改为30 之后同样,点击文中的标记值,得到运行结果。 操作完成后,第一步问题就解决了

job has not accepted any resources; check your cluster UI to ensure that workers are registered and

Spark 执行 spark-submit 提交jar包执行 [root@hadoop0 spark-2.1.0-bin-hadoop2.7]# bin/spark-submit --master spark://hadoop0:7077 --class org.apache.spark.examples.SparkPi examples/jars/spark-examples_2.11-2.1

![datax採集sqlserver報錯:not accepted by client preferences [TLS13, TLS12]](/front/images/it_default.gif)

![解决报错:The server selected protocol version TLS10 is not accepted by client preferences [TLS13, TLS12]](https://img-blog.csdnimg.cn/f2e904c9c8034e5b8e4b07e8934da45b.png)