2080ti专题

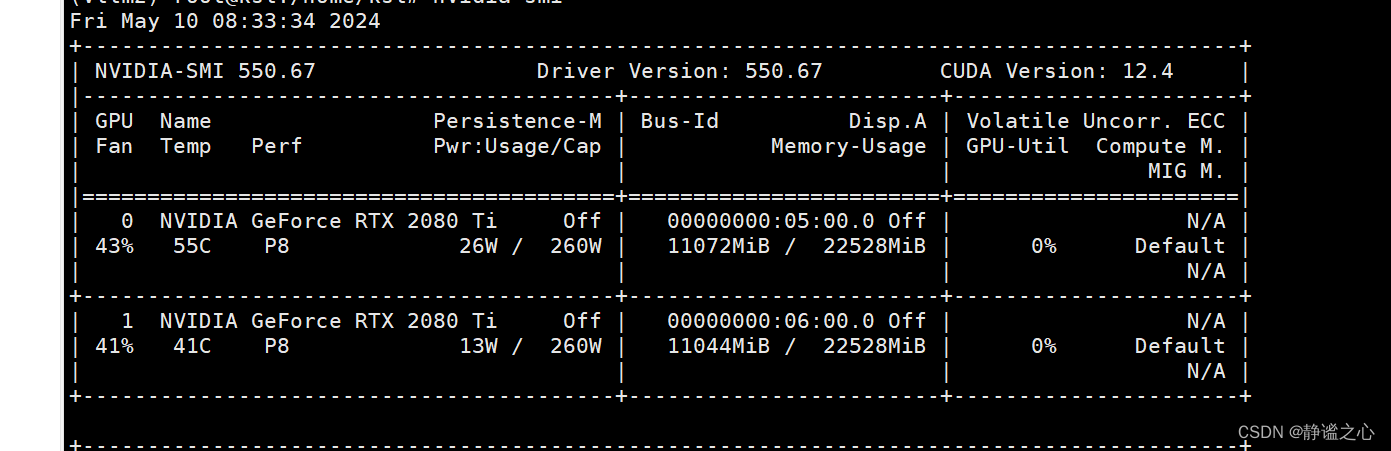

Fastchat + vllm + ray + Qwen1.5-7b 在2080ti 双卡上 实现多卡推理加速

首先先搞清各主要组件的名称与作用: FastChat FastChat框架是一个训练、部署和评估大模型的开源平台,其核心特点是: 提供SOTA模型的训练和评估代码 提供分布式多模型部署框架 + WebUI + OpenAI API Controller管理分布式模型实例 Model Worker是大模型服务实例,它在启动时向Controller注册 OpenAI API提供OpenAI兼容的A

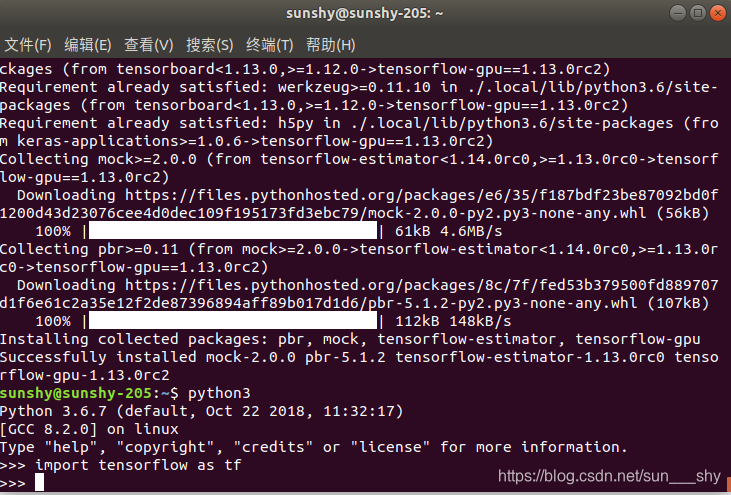

深度学习Ubuntu18.04+RTX 2080Ti+cuda10.0+cudnn7.42+tensorflow-gpu=1.13.0rc2

一、安装Ubuntu18.04 查看之前教程:https://blog.csdn.net/sun___shy/article/details/87558563 二、安装RTX2080Ti驱动 正常显卡的驱动在sudo apt-get update之后,都会在软件和更新里面的附加驱动中显示,或者通过指令 sudo ubuntu-drivers autoinstall就能自动安装,可能2080T

Ubuntu16.04 RTX 2080ti 安装 Cuda10.0 Cudnn7.6.5

换了一台电脑,搭建环境浪费了半天时间,现在记录一下。 1.安装Nvidia驱动 我之前在 https://www.geforce.cn/drivers 下载了适用于RTX 2080Ti的Nvidia 430,但是运行的时候报错check sum xxxxx. 于是放弃了先下载再安装,用了下面的方式: Ctrl +Alt +F1进入命令行模式,输入用户名和密码 sudo apt-get u