落库专题

【实战总结】分库路由字段与业务字段绑定落库

目录 问题背景 常见的解决方案 方案1:Hbase+ES 方案2:MQ异步绑定 问题背景 我们一般分库分表的路由字段是用户的账户ID(userId),有些业务场景外部不以此做业务,而是以业务请求ID等进行业务交互 所以我们内部系统通过userId来串联业务关系,但是与外部交互要使用到bizId等这些代表业务唯一性的字段,这两个字段不同路由可能会打到不同的库是没办法做数据库事务处理

Filter 实现过滤符合条件的请求并落库

其他系列文章导航 Java基础合集数据结构与算法合集 设计模式合集 多线程合集 分布式合集 ES合集 文章目录 其他系列文章导航 文章目录 前言 一、配置过滤器类 二、定义数据表、实体类、Mapper 2.1 DDL 2.2 实体类 2.3 Mapper 三、创建一个过滤器 四、实现 Nacos 配置热更新 五、自定义 RequestWrapper 六、容易踩

基于电商场景的高并发RocketMQ实战-发送优惠券流程解析、生产环境的落库与定时推送解决方案

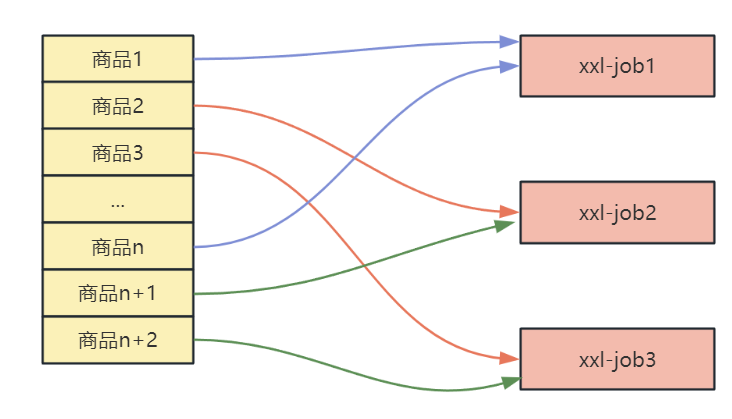

🌈🌈🌈🌈🌈🌈🌈🌈 欢迎关注公众号(通过文章导读关注),发送【资料】可领取 深入理解 Redis 系列文章结合电商场景讲解 Redis 使用场景、中间件系列笔记和编程高频电子书! 【11来了】文章导读地址:点击查看文章导读! 🍁🍁🍁🍁🍁🍁🍁🍁 发送优惠券流程【落库+定时推送生产环境解决方案】 首先,还是先了解业务逻辑的背景,对于系统中不活跃的用户,需要通过给这些用

你所不知道的日志异步落库

点击上方 好好学java ,选择 星标 公众号 重磅资讯、干货,第一时间送达今日推荐:牛人 20000 字的 Spring Cloud 总结,太硬核了~ 作者:程序诗人出处:https://www.cnblogs.com/scy251147/p/9193075.html 在互联网设计架构过程中,日志异步落库,俨然已经是高并发环节中不可缺少的一环。为什么说是高并发环节中不可缺少的呢?原因

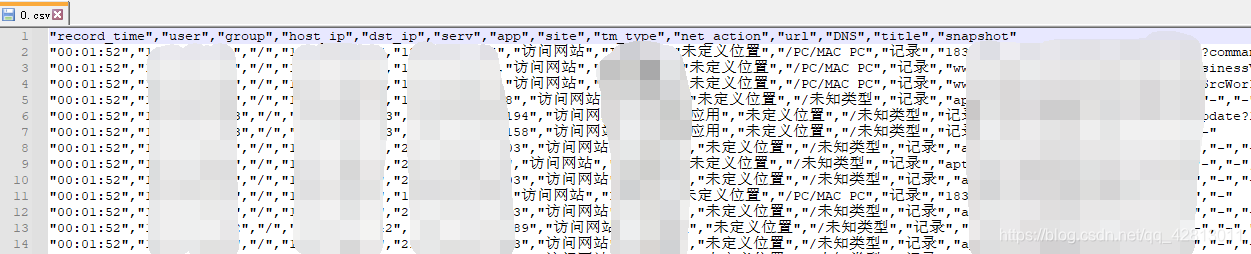

OpenCSV处理反斜线 \ ,将.csv文件映射为Java对象落库clickhouse

一、关键:RFC4180Parser 1、默认情况下,CSVReader使用双反斜线(’\’)作为其转义字符。同时,CSVWriter使用双引号(’“’)作为转义字符。因此,反斜线字符会导致不正确的转义。在读数据时,CSVParser将忽略单个反斜线字符,因为它是转义字符。 CSVReader使用CSVParser解析CSV数据。2、OpenCSV还提供了一个严格遵循RFC4180标准的解