电影网专题

HTML静态网页成品作业(HTML+CSS)——电影网首页网页设计制作(1个页面)

🎉不定期分享源码,关注不丢失哦 文章目录 一、作品介绍二、作品演示三、代码目录四、网站代码HTML部分代码 五、源码获取 一、作品介绍 🏷️本套采用HTML+CSS,未使用Javacsript代码,共有1个页面。 二、作品演示 三、代码目录 四、网站代码 HTML部分代码 <!DOCTYPE html><html><head><meta c

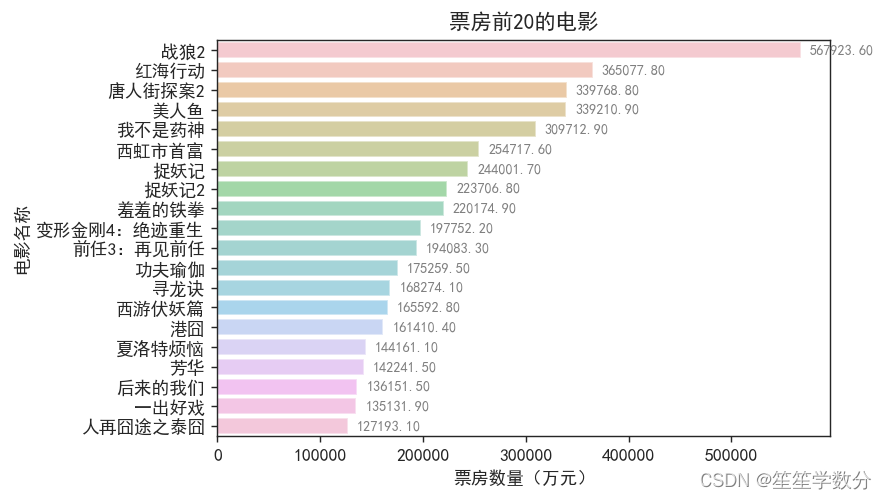

Python数据分析案例-中国电影网电影数据可视化分析

今天来给大家分享一个Python数据分析案例-中国电影网电影数据可视化分析 需要用到的包有:pandas,numpy,datetime,matplotlib.pyplot,seaborn,pyecharts,pygwalker 一. 数据获取 Excel数据展示如下: 导入包并获取数据: # 导入包和数据import pandas as pdimport numpy as np

python 使用scrapy框架爬取80s电影网电影

**思路来自喝口水先**近期的一篇博客 本篇博客适合小白巩固scrapy的使用 scrapy是python非常厉害的一个框架,说实话学了一段时间没有学太明白,视频可以看mooc的嵩天老师的爬虫课程,讲的非常不错,看完之后对scrapy的理解会更加深刻。 本篇博客主要用到了xpath和xpath helper 网页分析 80s电影网链接 首先链接点进去之后,页面会显示出25部电影,我们需要在这个

Python爬虫(三):爬取猫眼电影网经典电影TOP100信息并存入本地Markdown文件(下)

运行环境:Python3.6.2、Pycharm2017.2 附此爬虫代码GitHub地址:https://github.com/IMWoolei/MaoYanMovies ==>【效果链接】 上一篇博客【链接】 正文 Markdown作为一个易上手的标记书写语言,能够提供高效清晰的书写板是,一直是我很喜欢的书写工具。 Python的第三方库中提供了Markdown模块,

正则表达式爬取猫眼电影网

有关一些注意的问题: (一):在爬虫的时候我经常会遇到一些爬取的内容与网页原内容不一样(缺少一些内容) 解决办法: 1.有可能是你的IP被网站识别认为是爬虫然后采取反扒机制,这个时候我们需要使用代理IP, 最好的办法就是换成你的手机热点连接。 2.可能是爬取速度过快有些内容还没被加载出来这个时候需要加入timeout=等待爬取时间 (二):爬取不到任何内容 解决办法: 1.加入header伪装成浏

Python+lxml+selenium爬虫-爬取豆瓣电影网电影信息

1 准备工作 A 安装pycharm B selenium 安装 打开Pycharm,使用快捷键Ctrl+Shift+S打开Setting,根据下图指式安装selenium库 C chromedriver下载 chromedriver下载链接:http://npm.taobao.org/mirrors/chromedriver/。 将下载好的chr

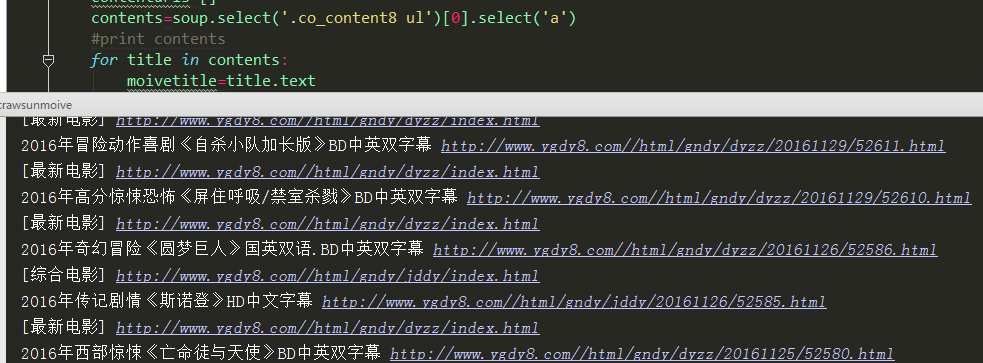

Python 2.7_First_try_爬取阳光电影网_20161206

之前看过用Scrapy 框架建立项目爬取 网页解析时候用的Xpath进行解析的网页元素 这次尝试用select方法匹配元素 1、入口爬取页面 http://www.ygdy8.com/index.html 2、用到模块 requests(网页源码下载) BeautifulSoup4(网页解析) 3、思路:首先由入口爬取页面进行获取网页上方栏目及对应url 如下图 4、建立菜单url列表 for

Python 2.7_Second_try_爬取阳光电影网_获取电影下载地址并写入文件 20161207

1、昨天文章http://www.cnblogs.com/Mr-Cxy/p/6139705.html 是获取电影网站主菜单 然后获取每个菜单下的电影url 2、今天是对电影url 进行再次解析获取下载地址 并写入文件 4、python 代码 #coding:utf-8import requestsfrom bs4 import BeautifulSoup as bs#爬取入口

06. 实战:Python正则法抓取某电影网Top250信息

目录 前言 需求 思路 代码实现 完整代码 运行结果 总结 前言 经过前面几节的学习,我们现在终于具有做小项目的能力了。我们的目标就是我们之前涉及过的某电影排行榜,利用爬虫工具抓取Top250,用来练手。 需求 抓取某电影Top250的“电影名称”,“上映年份”,“评分”,“评分人数”四项内容,并另存为文件。 思路 查看页面源代码,看数据是否包含在源代码