写到专题

大数据-116 - Flink DataStream Sink 原理、概念、常见Sink类型 配置与使用 附带案例1:消费Kafka写到Redis

点一下关注吧!!!非常感谢!!持续更新!!! 目前已经更新到了: Hadoop(已更完)HDFS(已更完)MapReduce(已更完)Hive(已更完)Flume(已更完)Sqoop(已更完)Zookeeper(已更完)HBase(已更完)Redis (已更完)Kafka(已更完)Spark(已更完)Flink(正在更新!) 章节内容 上节我们完成了如下的内容: Flink DataSt

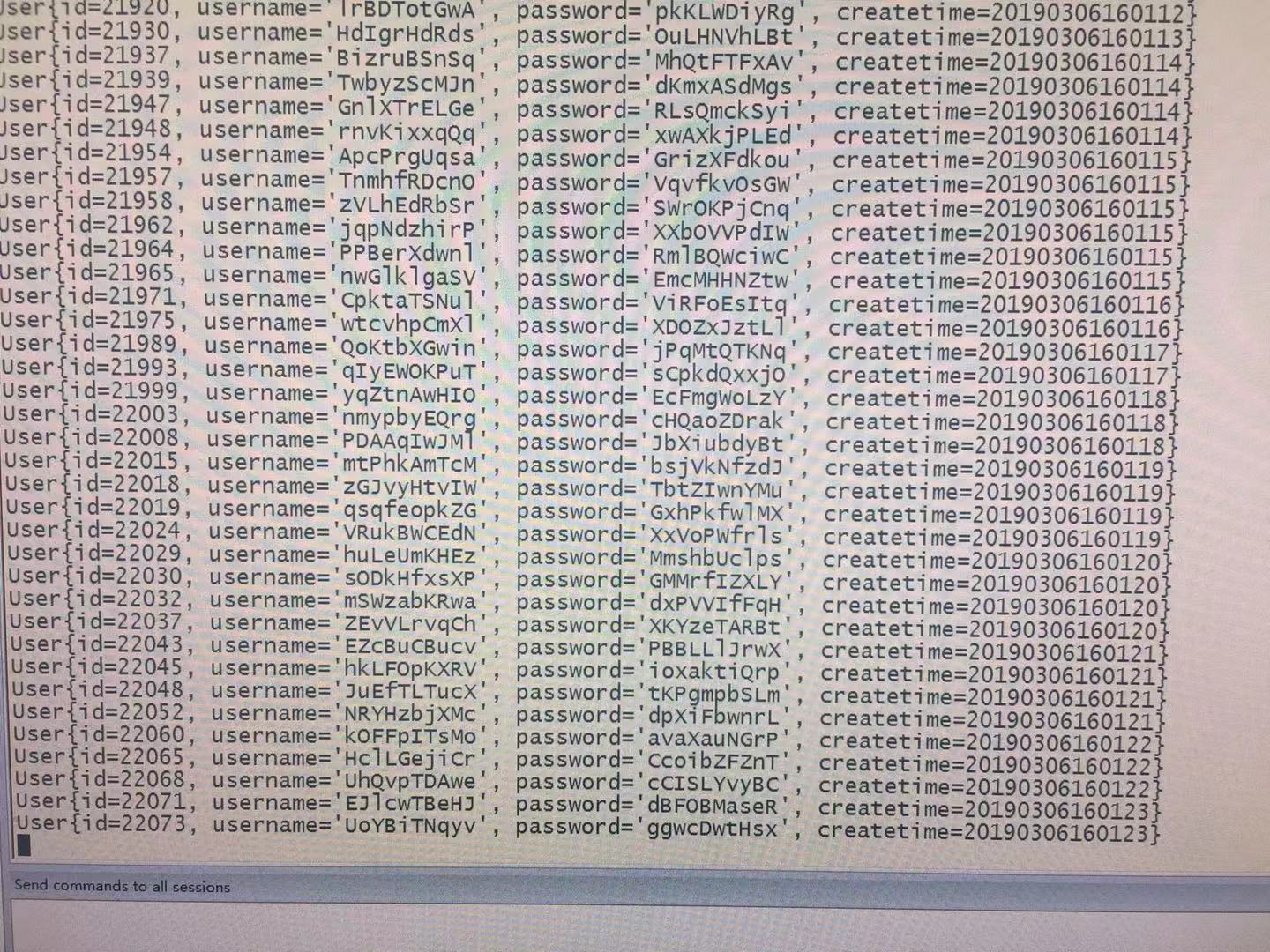

[AIGC] flink sql 消费kafka消息,然后写到mysql中的demo

这是一个使用 Flink SQL 从 Kafka 中消费数据并写入 MySQL 的示例。在这个示例中,我们将假设有一个 Kafka 主题 “input_topic”,它产生格式为 (user_id: int, item_id: int, behavior: string, timestamp: long) 的数据,我们需要把这些数据写入名为"output_table"的 MySQL 表中。 首先

UE 将UObject写到Package,加载Package获取UObject

1,将UObject写到Package中 //CachedMesh 就是要写的UObject对象 UStaticMesh* CachedMesh = CachedFontData.GetGlyphMesh(ShapedGlyph.GlyphIndex, TextParamValue.bOutline, TextParamValue.Extrude, TextParamValue.Bevel,

一次另类的mssql手注+写脚本(windows通过for循环来定位文件绝对路径;通过将路径写到表中来读取数据;通过unicode编码来读取中文)

转载https://xz.aliyun.com/t/11303?share_token=3d150dd5-438d-4bc1-943b-9b4916e7512f 0x00 前言 事情的起因是一位老哥叫我帮他打一个站点,于是就有了这篇文章 0x01 总体思路 发现mssql注入->上cs->失败 通过mssql注入->拿数据->解密失败->进后台无望 最终想到了: xp_cmdshell->通过

Pseudo Terminal 写到master 里面的数据默认是回显的

今天上午调试蓝牙串口, 需要用到 Pseudo Terminal 碰到这位兄弟一样的问题 http://topic.csdn.net/u/20080110/16/3ca493af-09c5-441d-9a6e-381df51ef240.html int find_pts(char **slave) { int master; extern char *pts

将文件写到GBASE南大通用数据库

本节中的例子会使用一个带有 BLOB 列的表,使用下面的语句生成 file 表。 file_id:表主键,file_name:存储的文件名,file_size:存储文件的大小, file:存储文件内容。 CREATE TABLE file ( file_id SMALLINT UNSIGNED AUTO_INCREMENT NOT NULL PRIMARY KEY, file_name

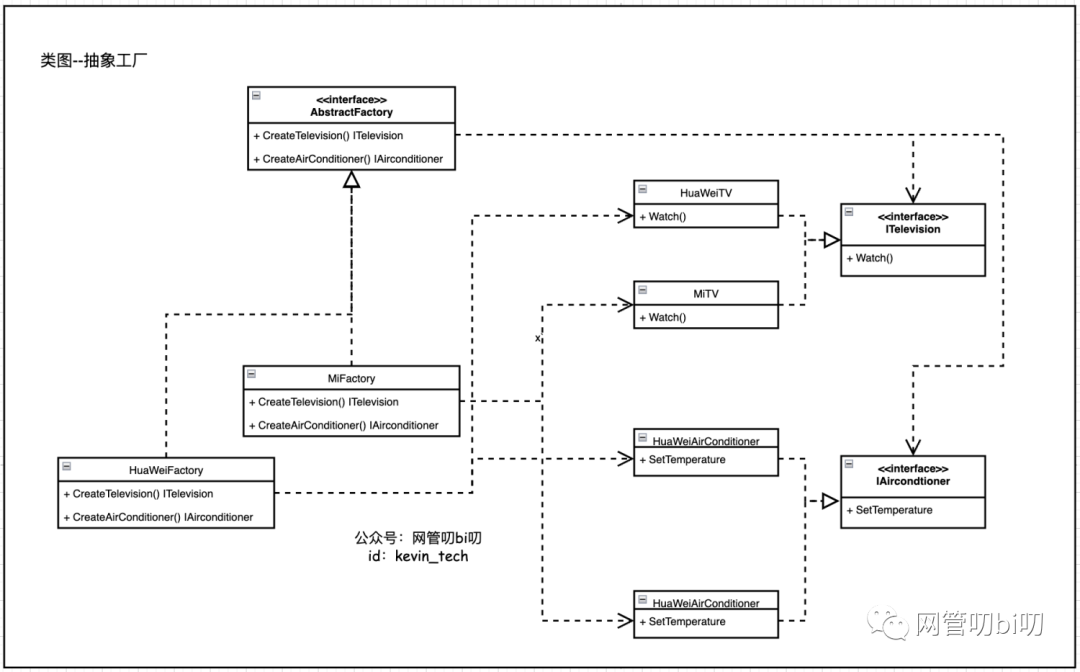

工厂模式有三个Level,你能用Go写到第几层?

设计模式中的工厂模式是我们编写代码时常用的一种建造型模式,用于创建指定类的实例。 在不使用设计模式的时候,我们是怎么创建类的实例的呢? 别多想,这个问题没坑,就是我们写代码时直接用 new 关键字,直接创建实例。比如 Java 语言里是通过 new 关键字直接调用类的构造方法,完成实例的创建。 class Person {}Person p1 = new Person(); 而像 Go 语言这

java 发送数据到flume_flume接收http请求,并将数据写到kafka

flume接收http请求,并将数据写到kafka,spark消费kafka的数据。是数据采集的经典框架。 直接上flume的配置: source : http channel : file sink : kafka xx :~/software/flume1.8/conf$ cat http-file-kafka.conf # example.conf: A single-node Flume

![[AIGC] flink sql 消费kafka消息,然后写到mysql中的demo](/front/images/it_default2.jpg)