互联网界专题

一种国际互联网界通行的道德规范——Robots协议

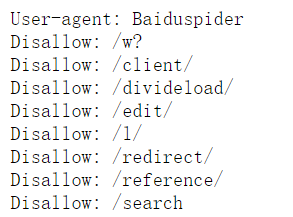

原则: 1搜索技术应服务于人类,同时尊重信息提供者的意愿,并维护其隐私权; 2网站有义务保护其使用者的个人信息和隐私不被侵犯。 robots协议(也称爬虫协议,机器人协议等)是一种存放于网站根目录下的文本文件, (在一网页中,在网页的URL(即网址)后加上/robots.txt,即可查看)如下图(了解) 通常告诉网络爬虫,此网站中的哪些内容是不应被网络爬虫获取的,哪些是可以被获取的