videomamba专题

论文阅读:VideoMamba: State Space Model for Efficient Video Understanding

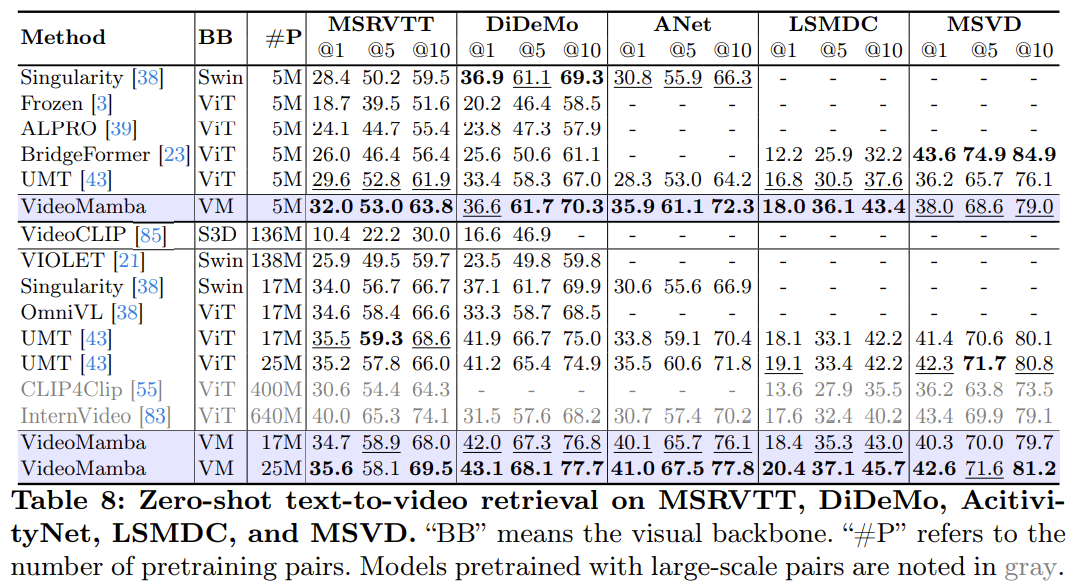

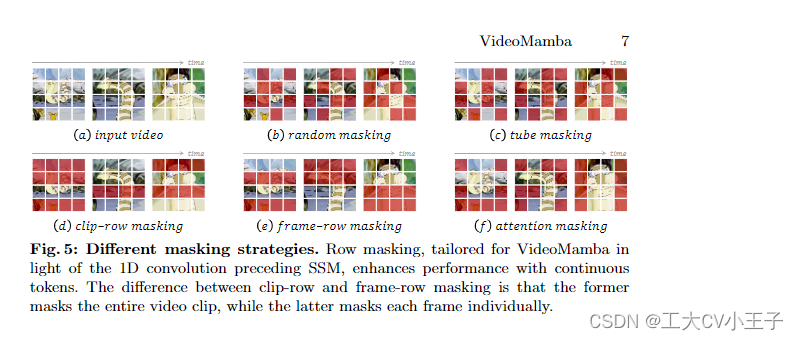

论文地址:arxiv 摘要 为了解决视频理解中的局部冗余与全局依赖性的双重挑战。作者将 Mamba 模型应用于视频领域。所提出的 VideoMamba 克服了现有的 3D 卷积神经网络与视频 Transformer 的局限性。 经过广泛的评估提示了 VideoMamba 的能力: 在视觉领域有可扩展性,无需大规模数据集来预训练。对于短期动作也有敏感性,即使是细微的动作差异也可以识别到在长期视

《VideoMamba》论文笔记

原文链接: [2403.06977] VideoMamba: State Space Model for Efficient Video Understanding (arxiv.org) 原文笔记 What: VideoMamba: State Space Model for Efficient Video Understanding 作者探究Mamba模型能否用于VideoUnder