vanishing专题

深度学习100问之深入理解Vanishing/Exploding Gradient(梯度消失/爆炸)

这几天正在看梯度消失/爆炸,在深度学习的理论中梯度消失/爆炸也是极其重要的,所以就抽出一段时间认真地研究了一下梯度消失/爆炸的原理,以下为参考网上的几篇文章总结得出的。 本文分为四个部分:第一部分主要介绍深度学习中一些关于梯度消失/爆炸(Vanishing/Exploding Gradient)的基础。第二部分主要介绍深度学习中什么是梯度消失/爆炸;第三部分主要介绍怎么解决梯度消失/爆炸。

Lecture 7: Vanishing Gradients and Fancy RNNs

文章目录 梯度消失直觉具体的推导Why is vanishing gradient a problem?Why is exploding gradient a problem?Gradient clipping: solution for exploding gradient How to fix vanishing gradient problem?Long Short-Term Mem

梯度消失(vanishing gradient)与梯度爆炸(exploding gradient)问题

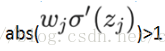

(1)梯度不稳定问题: 什么是梯度不稳定问题:深度神经网络中的梯度不稳定性,前面层中的梯度或会消失,或会爆炸。 原因:前面层上的梯度是来自于后面层上梯度的乘乘积。当存在过多的层次时,就出现了内在本质上的不稳定场景,如梯度消失和梯度爆炸。 (2)梯度消失(vanishing gradient problem): 原因:例如三个隐层、单神经元网络: 则可以得到: 然而,sigmoi