tinyllama专题

测试大语言模型在嵌入式设备部署的可能性——模型TinyLlama-1.1B-Chat-v1.0

测试模型TinyLlama-1.1B-Chat-v1.0修改推理参数,观察参数变化与推理时间变化之间的关系。 本地环境: 处理器 Intel® Core™ i5-8400 CPU @ 2.80GHz 2.80 GHz 机带 RAM 16.0 GB (15.9 GB 可用) 集显 Intel® UHD Graphics 630 独显 NVIDIA GeForce GTX 1050 主要测试

《TinyLlama: An Open-Source Small Language Model》全文翻译

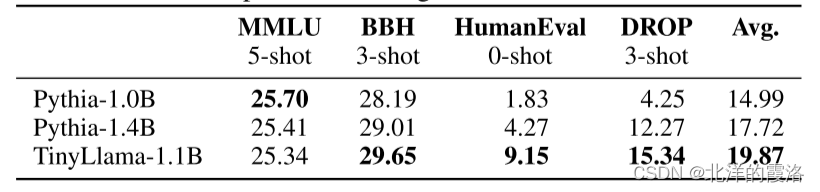

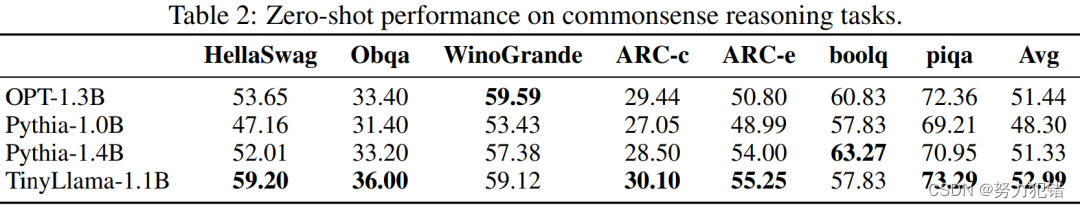

【Title】 TinyLlama:开源小语言模型 【Abstract】 我们推出了 TinyLlama,这是一个紧凑的 1.1B 语言模型,在大约 1 万亿个令牌上进行了大约 3 个时期的预训练。 TinyLlama 基于 Llama 2(Touvron 等人,2023b)的架构和标记器构建,利用开源社区贡献的各种进步(例如 FlashAttention(Dao,2023)

超越体量:TinyLlama用1.1B参数实现大模型级性能

引言 随着人工智能技术的快速发展,大型语言模型(LLM)在全球范围内受到瞩目。但与此同时,另一类模型正在逐渐崭露头角:参数规模较小的语言模型。这类模型在计算资源受限的环境下显示出巨大潜力,特别是在智能手机、物联网设备和嵌入式系统等边缘设备中。TinyLlama-1.1B模型正是这一趋势的代表。 TinyLlama-1.1B模型介绍 TinyLlama-1.1B是由新加坡科技设计大学(SUTD