sparkr专题

SparkR运行时错误:Re-using existing Spark Context. Please stop SparkR with sparkR.stop() or restart R to c

在SparkR shell运行时出现如下错误 Re-using existing Spark Context. Please stop SparkR with sparkR.stop() or restart R to create a new 错误原因: 上次使用完为关闭 解决方法: 使用如下命令关闭上次程序开启的程序: sparkR.stop()

SparkR读取CSV格式文件错误java.lang.ClassCastException: java.lang.String cannot be cast to org.apache.spark.u

使用如下命令启动sparkR shell: bin/sparkR --packages com.databricks:spark-csv_2.10:1.0.3 之后读入csv文件: flights <- read.df(sqlContext, "/sparktest/nycflights13.csv", "com.databricks.spark.csv", header="true")

SparkR运行时报错:Error in socketConnection(port = monitorPort) : cannot open the connection

在安装完Spark和R之后运行Spark自带的R示例报错: [SparkR@Master1 spark-1.6.1-bin-hadoop2.6]$ bin/spark-submit examples/src/main/r/dataframe.R Loading required package: methods Attaching package: ‘SparkR’ The follow

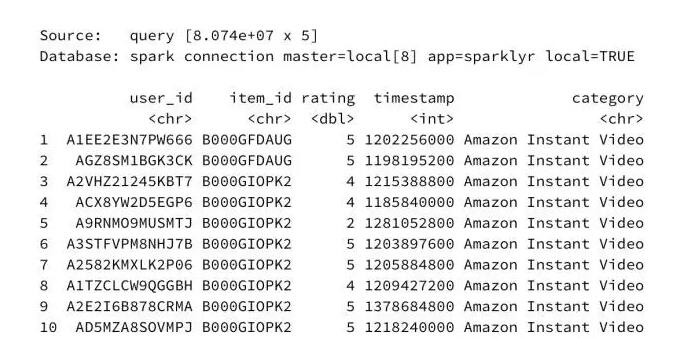

R︱sparkR的安装与使用、函数尝试笔记、一些案例

本节内容转载于博客: wa2003 spark是一个我迟早要攻克的内容呀~ ————————————————————————————————————— 一、SparkR 1.4.0 的安装及使用 1、./sparkR打开R shell之后,使用不了SparkR的函数 装在了 /usr/local/spark-1.4.0/ 下 [root@master sparkR]#