spark1.6专题

spark job server on Spark1.6.0-CDH5.11.0初步使用

下载spark job server(sjs) 因为下载的是与cdh版本匹配的sjs源码,所以需要在以下连接下载相关版本。 https://github.com/bjoernlohrmann/spark-jobserver这次安装使用 yarn模式运行的sjs,具体的安装参照github英文版,参考如下 https://github.com/spark-jobserver/spark-job

Spark1.6.1集群环境搭建——Standalone模式HA

机器准备 笔者有三台机器,左侧栏为ip,右侧为hostname,三台机器都有一个名为spark的用户。 192.168.200.11 hadoop11192.168.200.12 hadoop12192.168.200.13 hadoop13 安装scala http://blog.csdn.net/silentwolfyh/article/details/512

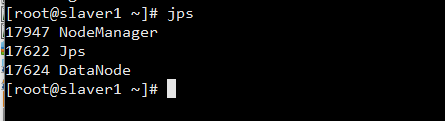

Centos7 下 spark1.6.1_hadoop2.6 分布式集群环境搭建

摘要 在上一篇博客《Centos7 下 Hadoop 2.6.4 分布式集群环境搭建》 已经详细写了Hadoop 2.6.4 配置过程,下面详细介绍 spark 1.6.1的安装过程。 Scala 安装 下载 ,解压 下载 scala-2.11.8.tgz, 解压到 /root/workspace/software/scala-2.10.4t 目录下 修改环境变量文件 /etc/pro