simam专题

改进YOLOv8注意力系列六:结合SEAttention轻量通道注意力、ShuffleAttention重排特征注意力模块、SimAM无参数化注意力

改进YOLOv8注意力系列五:结合ParNetAttention注意力、高效的金字塔切分注意力模块PSA、跨领域基于多层感知器(MLP)S2Attention注意力 代码SEAttention轻量通道注意力ShuffleAttention重排特征注意力模块SimAM无参数化注意力 加入方法各种yaml加入结构 本文提供了改进 YOLOv8注意力系列包含不同的注意力机制以及多

免费阅读篇 | 芒果YOLOv8改进109:注意力机制SimAM:用于卷积神经网络的简单、无参数注意力模块

免费阅读篇|芒果YOLOv8改进109:注意力机制篇SimAM:用于卷积神经网络的简单、无参数注意力模块 💡🚀🚀🚀本博客 改进源代码改进 适用于 YOLOv8 按步骤操作运行改进后的代码即可 该专栏完整目录链接: 芒果YOLOv8深度改进教程 该篇博客为免费阅读内容,直接改进即可🚀🚀🚀 文章目录 1. SimAM论文2. YOLOv8 核心代码改进部分2.1 核

即插即用!中山大学提出SimAM:无参Attention!助力分类/检测/分割涨点!

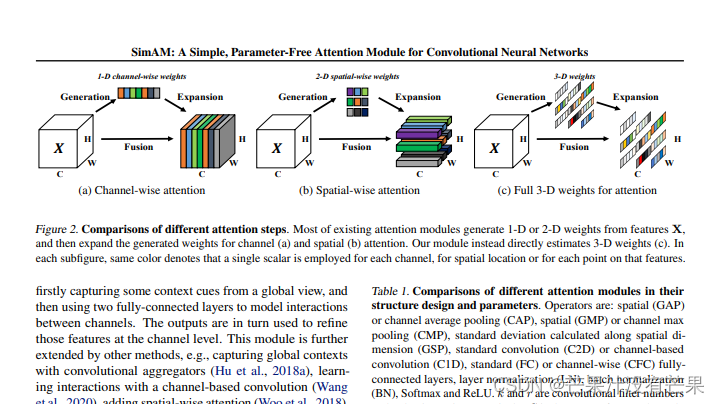

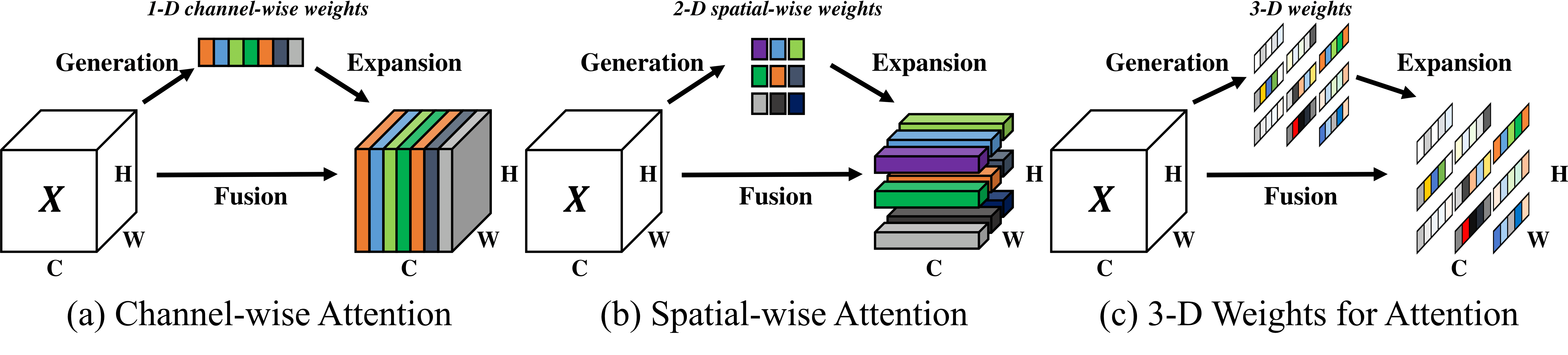

点击下方卡片,关注“CVer”公众号 AI/CV重磅干货,第一时间送达 作者:happy | 本文转载自:极市平台 导读 本文提出一种概念简单且非常有效的注意力模块。不同于现有的通道/空域注意力模块,该模块无需额外参数为特征图推导出3D注意力权值。 作者单位:中山大学, 上海交大等 SimAM: A Simple, Parameter-Free Attention Module f

(超详细)2-YOLOV5改进-添加SimAM注意力机制

1、在yolov5/models下面新建一个SimAM.py文件,在里面放入下面的代码 代码如下: import torchimport torch.nn as nnclass SimAM(torch.nn.Module):def __init__(self, e_lambda=1e-4):super(SimAM, self).__init__()self.activaton = nn.S

(超详细)YOLOV5改进-添加SimAM注意力机制

1、在yolov5/models下面新建一个SimAM.py文件,在里面放入下面的代码 代码如下: import torchimport torch.nn as nnclass SimAM(torch.nn.Module):def __init__(self, e_lambda=1e-4):super(SimAM, self).__init__()self.activaton = nn.S

改进YOLOv5、YOLOv8系列:15.添加SimAM注意力机制

最新创新点改进推荐 -💡统一使用 YOLO 代码框架,结合不同模块来构建不同的YOLO目标检测模型。 🔥 《芒果书》系列改进专栏内的改进文章,均包含多种模型改进方式,均适用于YOLOv3 、YOLOv4 、 YOLOR 、 YOLOX 、YOLOv5 、 YOLOv7 、 YOLOv8 改进(重点)!!! 🔥 专栏创新点教程 均有不少同学反应和我说已经在自己的数据集上有效涨点啦!! 包

YOLOv5算法改进(3)— 注意力机制介绍(ECA、SOCA和SimAM)

前言:Hello大家好,我是小哥谈。注意力机制是近年来深度学习领域内的研究热点,可以帮助模型更好地关注重要的特征,从而提高模型的性能。注意力机制可被应用于模型的不同层级,以便更好地捕捉图像中的细节和特征,这种模型在计算资源有限的情况下,可以实现更好的性能和效率。为了让大家能够更加清晰的了解注意力机制,本文就给大家介绍下ECA、SOCA和SimAM注意力机制,希望大家学习之后能够有所收获!🌈