nvml专题

Failed to initialize NVML Driver/library version mismatch

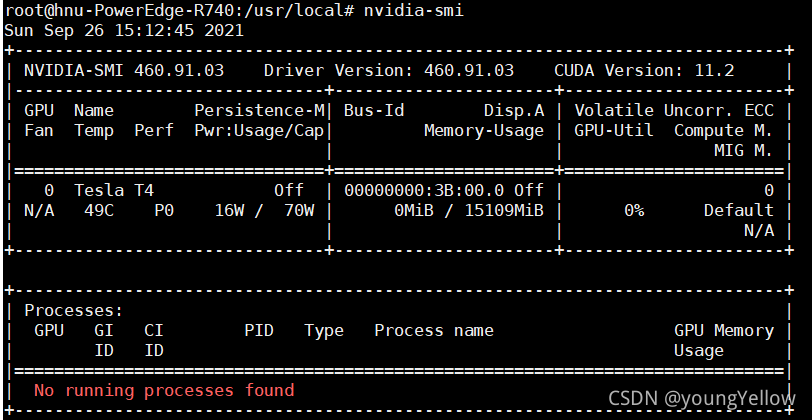

情况:服务器正正常使用,突然用来监控GPU使用的“nvidia-smi”突然不能正常显示,并报错“Failed to initialize NVML Driver/library version mismatch”。但是与此同时,服务器的GPU仍在正常运行。 问题:这个问题虽然不会影响GPU的运行,但是无法监督当前GPU的使用情况,使用不方便。 解决:重启大法好

nvidia-smi Failed to initialize NVML: Driver/library version mismatch

提示:1、不是必须使用本命令,请不要删除现有NVIDIA驱动操作; 2、下面的图片可以忽略不看,仅仅是举例,对着代码傻瓜式操作即可。 一:问题描述二:查看kernel和驱动的版本是否匹配三:删除现有显卡驱动,目标让其与内核版本一致四:安装过程五:查看结果 一:问题描述 刚开始学习GUP教程,书本上说在命令行执行命令nvidia-smi可以管理和监控GPU设备,并允许查询和修改设备

Nvidia显卡Failed to initialize NVML Driver/library version mismatch错误解决方案

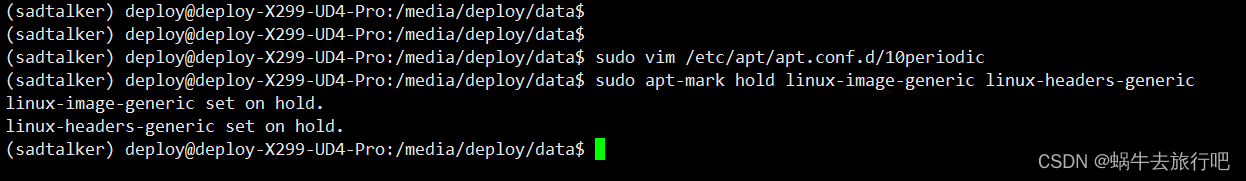

最近GPT比较火,开始折腾了一下gpu,用来跑项目: https://github.com/OpenTalker/SadTalker 今天运行程序突然发现用不了,经排查应该是由于NVIDIA内核驱动版本与系统驱动版本不一致导致的。 下面简单总结了这个错误的解决方案。 问题复现 查看系统驱动日志 cat /var/log/dpkg.log | grep nvidia ## 问题原因分析 NV

Docker中Failed to initialize NVML: Unknown Error

参考资料 Docker 中无法使用 GPU 时该怎么办(无法初始化 NVML:未知错误) SOLVED Docker with GPU: “Failed to initialize NVML: Unknown Error” 解决方案需要的条件: 需要在服务器上docker的admin list之中. 不需要服务器整体的admin权限. 我在创建docker的时候向管理员申请了把握加到docker

pynvml.nvml.NVMLError_FunctionNotFound: Function Not Found

在Docker中运行报错: Traceback (most recent call last):File "/opt/conda/envs/rapids/lib/python3.8/site-packages/pynvml/nvml.py", line 782, in _nvmlGetFunctionPointer_nvmlGetFunctionPointer_cache[name] = get

pynvml.nvml.NVMLError_FunctionNotFound: Function Not Found

在Docker中运行报错: Traceback (most recent call last):File "/opt/conda/envs/rapids/lib/python3.8/site-packages/pynvml/nvml.py", line 782, in _nvmlGetFunctionPointer_nvmlGetFunctionPointer_cache[name] = get

【nvidia-smi报错】Failed to initialize NVML: Driver/library version mismatch

问题: 使用nvidia-smi命令查看显卡状态时,出现错误: Failed to initialize NVML: Driver/library version mismatch 而使用nvcc -V查看cuda版本时,显示正常 分析解决: 从现象看是cuda正常,但与之匹配的显卡驱动版本变了,导致出现不匹配问题。 个人简单粗暴的做法是重新下载当前cuda版本的安装包,只安装驱