notready专题

解决Kubernetes报错节点状态为NotReady,希望可以帮到你

Kubernetes报错节点状态为NotReady 文章目录 Kubernetes报错节点状态为NotReady实验过程一、报错内容二、安装flannel网络插件三、成功 实验过程 起因是这样的这几天做学到了k8s,那肯定要部署呀,然后就先用kubeadm进行快速部署的,目的是为了体验一下广大程序员口中所说的Kubernetes(简称K8S),但是部署的过程中就出现了问题,是

Kubrnetes work NotReady ResourceExhausted work节点资源耗尽

rpc error: code = ResourceExhausted desc = grpc: received message larger than max (4196772 vs. 4194304) 现象:kubernetes集群不可用,所有work节点离线 问题定位: 执行kubectl get node 发现work节点都是NotReady状态登入到work节点查看日志发现 N

重启服务器后node节点显示NotReady

场景:夜间进行了断电维护,重启后发现业务无法使用,检查发现一个node节点显示NotReady. 去到目标服务器查看kubelet服务未成功启动 journalctl -u kubelet 执行journalctl -u kubelet 查看日志发现提示: ailed to run Kubelet: running with swap on is not supp

kubeadm部署K8S,安装calico网络后,部分节点状态始终NotReady 排查过程 (是节点系统时间错误,导致下载镜像报证书错误)

#查看node状态 kubectl get nodes #k8s-master节点始终NodtReady #查看pod状态,发现有calico的pod状态Init:ImagePullBackOff kubectl get pods --all-namespaces #删除那台pod查看能否正常 kubectl delete pod calico-node-x2bfz -n

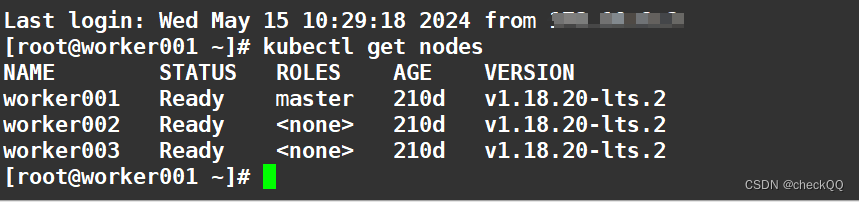

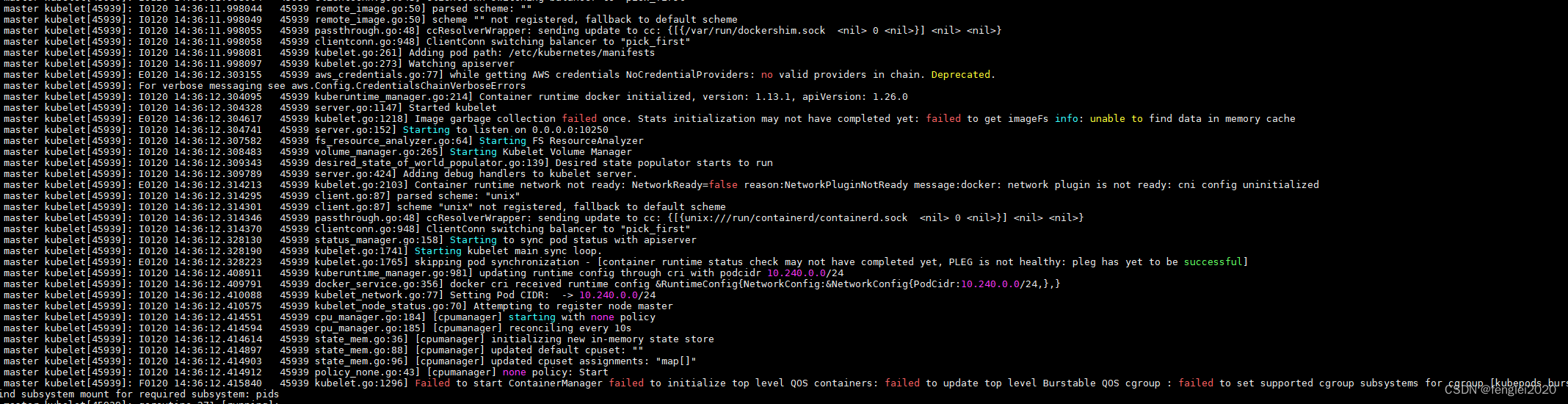

kubeadm 安装k8s集群后,master节点notready问题解决方案

使用kubeadm 安装k8s集群后,加载calico cni 网络组件后,master节点notready问题 表现为: 使用命令查看日志:journalctl -f -u kubelet 报错如下: Failed to start ContainerManager failed to initialize top level QOS containers: failed to up

k8s解决 搭建集群的时候notReady问题

由于k8s安装master一直处于NotReady状态查看日志出现 failed to find plugin “flannel” in path [/opt/cni/bin] 日志信息 1 : [failed to find plugin "flannel" in path [/opt/cni/bin]] 1 W1226 16:19:36.668133 47110 cni.go:237

K8S线上集群排查,实测排查Node节点NotReady异常状态

K8S线上集群排查,实测排查Node节点NotReady异常状态 一,文章简述 大家好,本篇是个人的第 2 篇文章。是关于在之前项目中,k8s 线上集群中 Node 节点状态变成 NotReady 状态,导致整个 Node 节点中容器停止服务后的问题排查。 文章中所描述的是本人在项目中线上环境实际解决的,那除了如何解决该问题,更重要的是如何去排查这个问题的起因。 关于 Node 节点不可用