mul专题

Pytorch:Tensor基本运算【add/sub/mul/div:加减乘除】【mm/matmul:矩阵相乘】【Pow/Sqrt/rsqrt:次方】【近似:floor...】【裁剪:clamp】

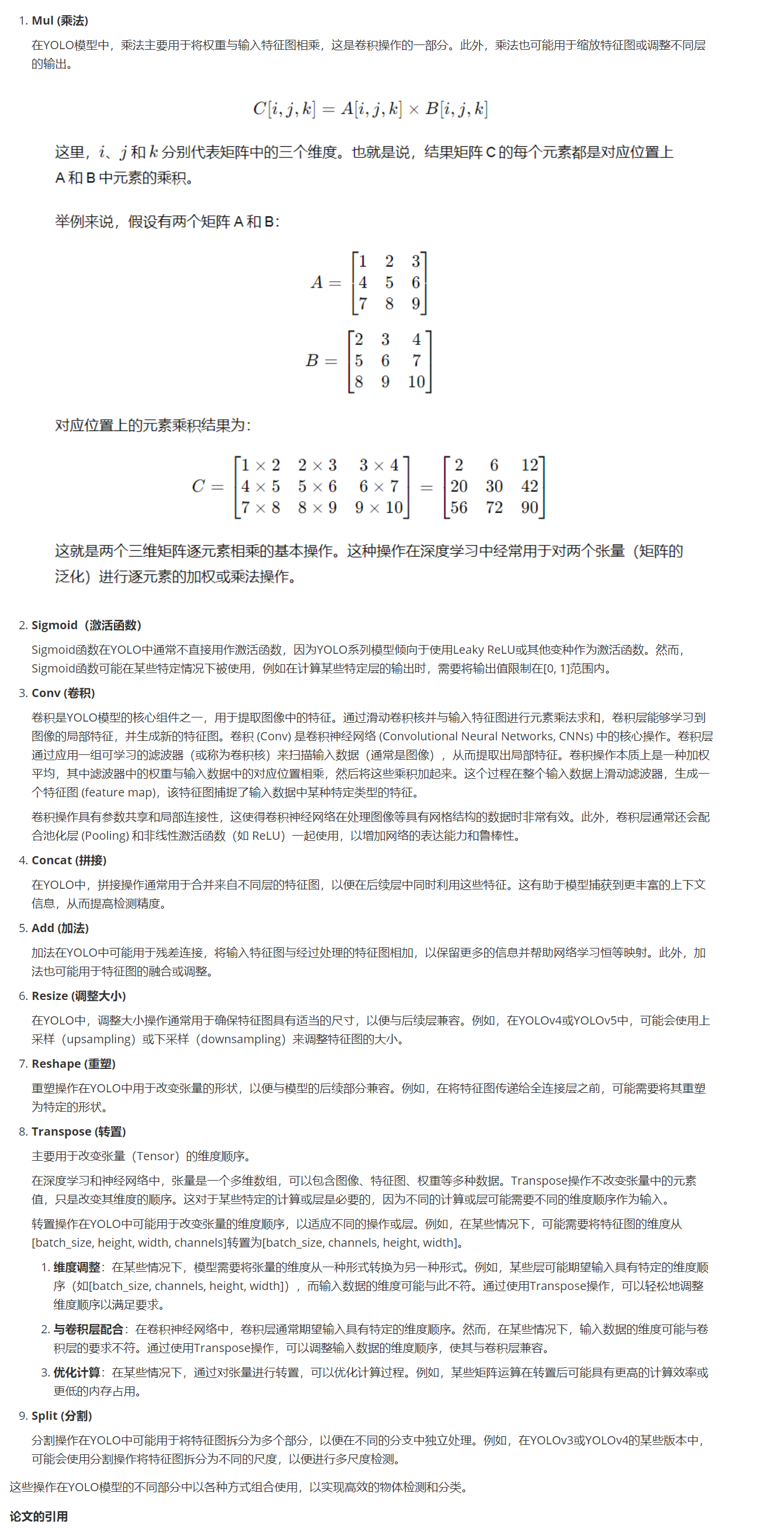

一、基本运算:加减乘除 1、乘法 1.1 a * b:element-wise 对应元素相乘 a * b:要求两个矩阵维度完全一致,即两个矩阵对应元素相乘,输出的维度也和原矩阵维度相同 1.2 torch.mul(a, b):element-wise 对应元素相乘 torch.mul(a, b):是矩阵a和b对应位相乘,a和b的维度必须相等,比如a的维度是(1, 2),b的维度是(1,

【张量乘法】pytorch中的mul、dot、mm、matmul

张量的乘法是pytorch等神经网络开发框架中最常见、最基本的操作之一。 1,torch.mul 对应位置的元素相乘。mul即表示张量中对应位置元素的相乘,也是最容易理解的乘法。 import torcha = torch.tensor([[1, 2], [3, 4]])b = torch.tensor([[5, 6], [7, 8]])res = torch.mul(a, b)pr

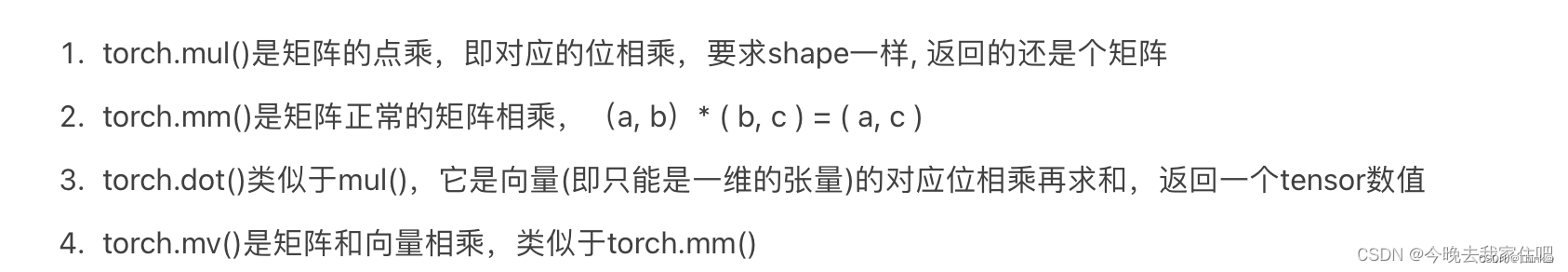

速通汇编(三)寄存器及汇编mul、div指令

一,寄存器及标志 AH&AL=AX(accumulator):累加寄存器BH&BL=BX(base):基址寄存器CH&CL=CX(count):计数寄存器DH&DL=DX(data):数据寄存器SP(Stack Pointer):堆栈指针寄存器BP(Base Pointer):基址指针寄存器SI(Source Index):源变址寄存器DI(Destination Index):目的变址寄存器

HLSL/CG里的Mul参数顺序

/ /Computes world space light directioninline float3 WorldSpaceLightDir( in float4 v ){ float3 worldPos = mul(_Object2World, v).xyz; ...... 按照数学逻辑应该是v乘以_Object2World进行矩阵变换,但是mul里却是反过来的,为什么呢? 因为不

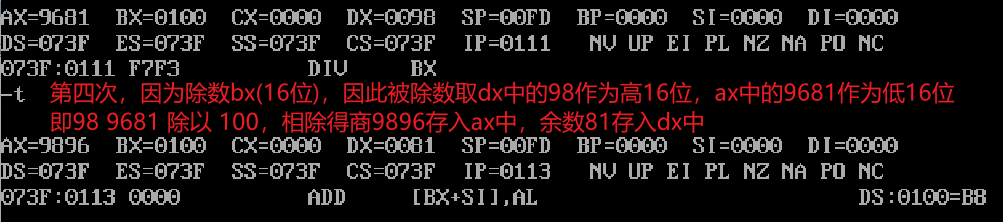

yolo模型中神经节点Mul与Sigmoid 和 Conv、Concat、Add、Resize、Reshape、Transpose、Split

yolo模型中神经节点Mul与Sigmoid 和 Conv、Concat、Add、Resize、Reshape、Transpose、Split 在YOLO(You Only Look Once)模型中,具体作用和用途的解释:

【Linux】编写add/sub/mul/div函数,并打包成动、静态库,分别使用

动态库与静态库的生成与使用: 库文件实际上就是封装了一大堆已经编译完成的代码文件,通过链接这个库进而获取到相应函数实现。 库的生成: 编写函数: 我们的目标是要将add/sub/mul/div函数打包成动态、静态库,并使用,首先我们先编写这四个函数,分别命名为child1.c、child2.c、child3.c以及child4.c,函数具体如下: 然后编写相应的.h文件,完成后

Tensorflow中部分API弃用(tf.sub/tf.mul/tf.neg)

Tensorflow中废弃的API及替代 tf.mul , tf.sub , tf.neg 已经废弃 分别可用tf.multiply , tf.subtract , tf.negative替代

Mul-charts一款用于高端动态图谱绘制的软件

软件来源微信公众号【学术点滴】 无论是工作还是学习,图谱绘制一直伴随着我们,如何简单、快速的绘制各种高端图谱成为困扰我们的一大难题 基于此,开发一款高端图谱软件Mul-charts,能够直接将你的数据转化为各大平台识别的数据,然后直接一键作图 【1】Mul-charts软件功能: (1)桑基图一键绘制 (2)主题河流图一键绘制 (3)中国地图一键绘制 (4)世界地图一键绘制 (5)

mysql key pri uni mul

desc mysql表的时候我们会发现key列有时候会有pri uni mul标识,下面说一下三者的区别 pri:最严格key,不为null且不允许重复 uni:次严格,可以为null但不允许重复 mul,不严格,可以为null也可以重复

(PyTorch)PyTorch中的常见运算(*、@、Mul、Matmul)

1. 矩阵与标量 矩阵(张量)每一个元素与标量进行操作。 import torcha = torch.tensor([1,2])print(a+1)>>> tensor([2, 3]) 2. 哈达玛积(Mul) 两个相同尺寸的张量相乘,然后对应元素的相乘就是这个哈达玛积。 a = torch.tensor([1,2])b = torch.tensor([2,3])print(a