mbgd专题

人工智能基础_机器学习014_BGD批量梯度下降公式更新_进一步推导_SGD随机梯度下降和MBGD小批量梯度下降公式进一步推导---人工智能工作笔记0054

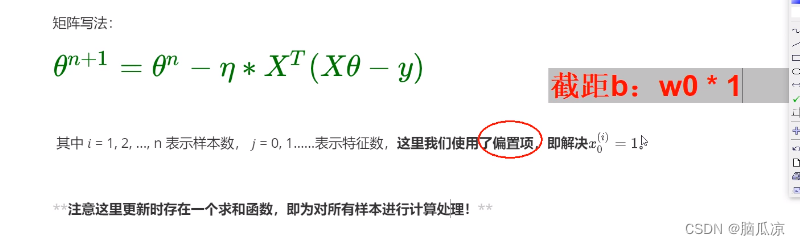

然后我们先来看BGD批量梯度下降,可以看到这里,其实这个公式来源于 梯度下降的公式对吧,其实就是对原始梯度下降公式求偏导以后的梯度下降公式,然后 使用所有样本进行梯度下降得来的,可以看到* 1/n 其实就是求了一个平均数对吧.所有样本的平均数. 然后我们看,我们这里* 1/n那么前面还有一个eta ,对吧,那么这个1/n是个常量对吧,我们下面 就和eta进行了合并,可以看到,这里的

机器学习(四):批量梯度下降法(BGD)、随机梯度下降法(SGD)和小批量梯度下降法(MBGD)

本文基于吴恩达老师的机器学习课程。看了吴恩达老师的机器学习课程,收获很多,想把课上学做的笔记结合自己的理解以及找到的一些资料综合起来做一个总结。大家感兴趣也可以自己去看一看吴恩达老师的课,这套课程,被公认为最好的机器学习的入门教程,下面是课程视频链接: 斯坦福大学公开课 :机器学习课程 上一篇博客机器学习(三):线性回归:梯度下降算法讲了用最小二乘法求得损失函数,再用梯度下降算法最小化损失函数

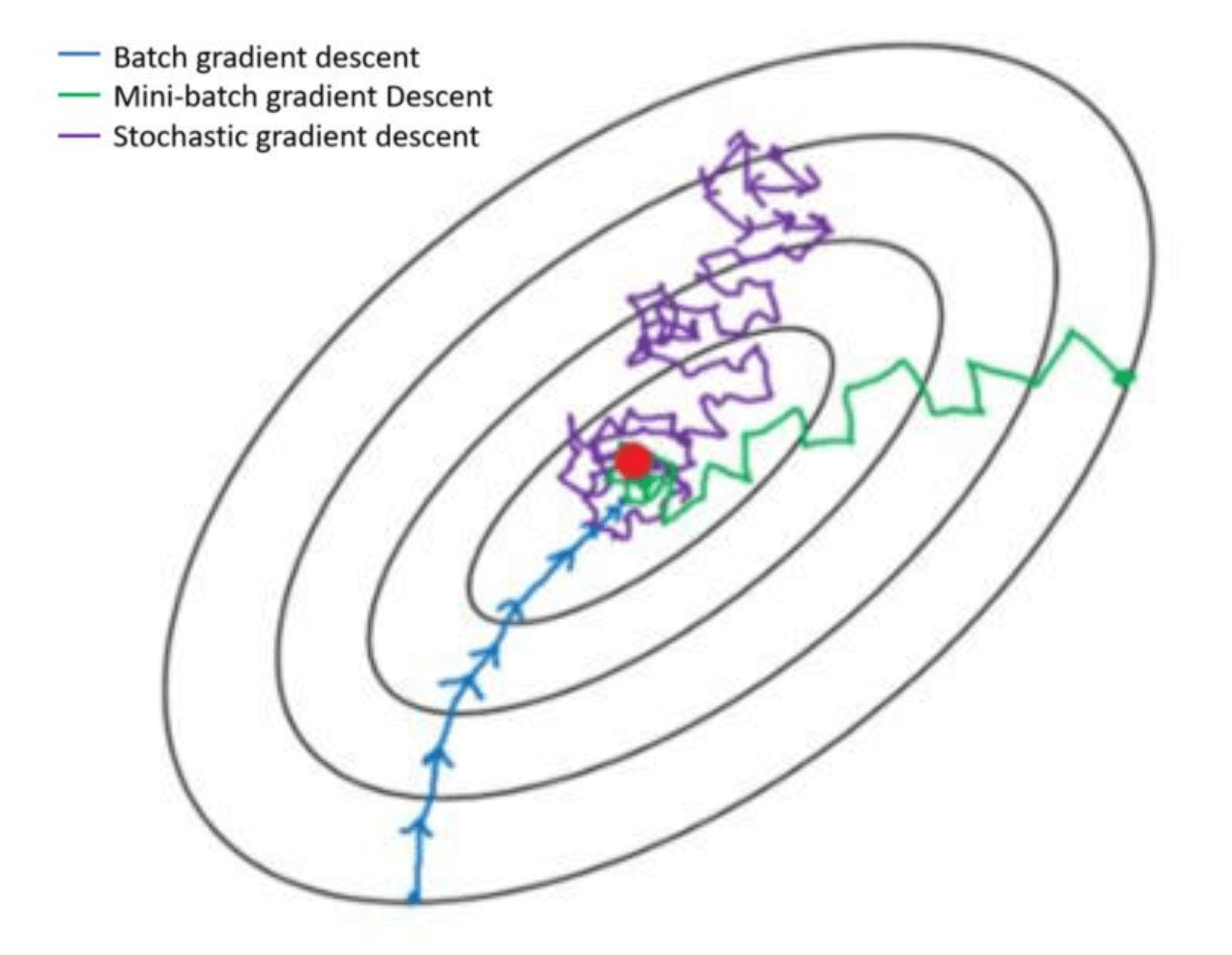

三种梯度下降算法的区别(BGD, SGD, MBGD)

前言 我们在训练网络的时候经常会设置 batch_size,这个 batch_size 究竟是做什么用的,一万张图的数据集,应该设置为多大呢,设置为 1、10、100 或者是 10000 究竟有什么区别呢? # 手写数字识别网络训练方法network.fit(train_images,train_labels,epochs=5,batch_size=128) 批量梯度下降(Batch G

三种梯度下降算法的区别(BGD, SGD, MBGD)

前言 我们在训练网络的时候经常会设置 batch_size,这个 batch_size 究竟是做什么用的,一万张图的数据集,应该设置为多大呢,设置为 1、10、100 或者是 10000 究竟有什么区别呢? # 手写数字识别网络训练方法network.fit(train_images,train_labels,epochs=5,batch_size=128) 批量梯度下降(Batch G