mbert专题

【NLP】多语言预训练模型(mBERT和XLM)

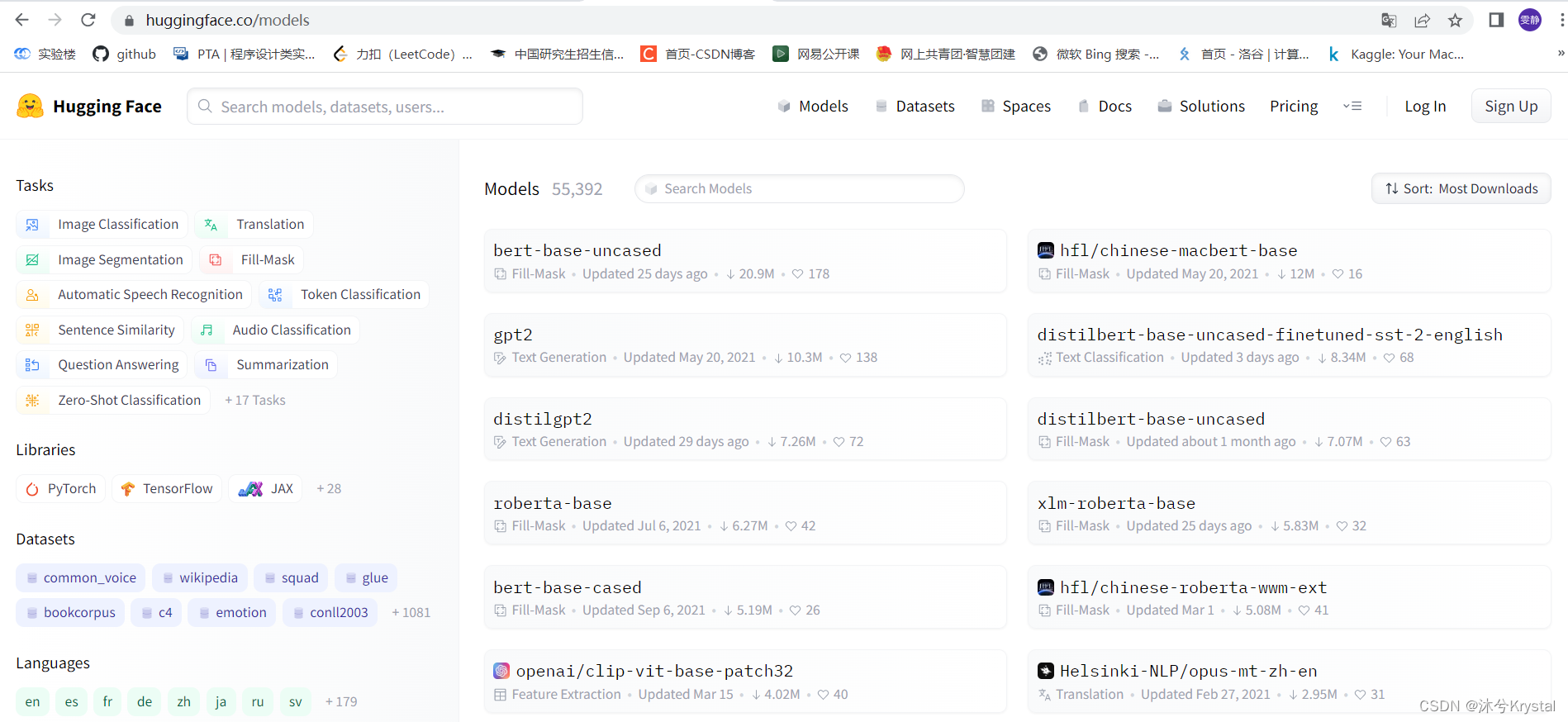

融合多语言的预训练模型将不同语言符号统一表示在相同的语义向量空间内,从而达到跨语言处理的目的。 多语言BERT (Multilingual BERT, mBERT) 它能够将多种语言表示在相同的语义空间中。 通过HuggingFace提供的transformers库: 使用区分大小写的多语言BERT-base模型(bert-base-multilingual-cased),任务为掩码填充,即将