iterations专题

[nlp] epoch、batchsize、batchnumber、iterations

参考:https://blog.csdn.net/wills798/article/details/89326343 epoch 一个epoch是指 所有的数据 传入网络 完成一次前向计算以及反向传播的过程。 由于一个epoch常常太大,计算机无法负荷。 batch_size 所谓batch就是每次送入网络中训练的一部分数据, 而 batch_size 是 每个batch中训练样本

深度学习中Epoch,Batchsize,Iterations

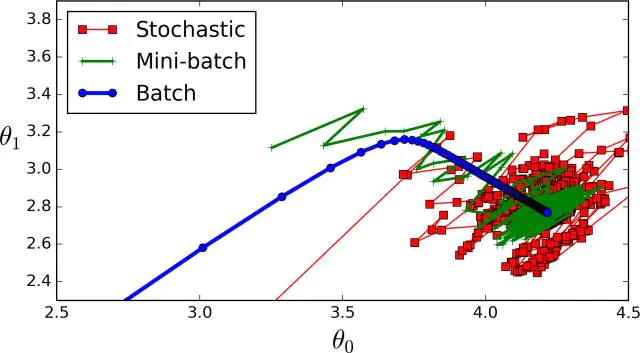

Epoch,Batchsize,Iterations,这三个都是深度学习训练模型时经常遇到的概念。你一定有过这样的时刻,面对这几个词傻傻分不清楚,这三个概念究竟是什么,它们又有什么区别? 深度学习,梯度下降,Epoch,Batchsize,Iterations 深度学习中的Epoch,Batchsize,Iterations,都是什么意思 梯度下降法 一切的一切,要从机器学习中的

深度学习中的epochs,batch_size,iterations详解

关于epoch、batch_size、iteration之前一直有点难以理解,尤其是epoch和iteration这两个概念,寻找多次看过多个博客后,个人觉得转载的这篇算是比较好理解,写得不错的博客。 深度学习框架中涉及很多参数,如果一些基本的参数如果不了解,那么你去看任何一个深度学习框架是都会觉得很困难(意思就是了解一些基本概念对后续深入理解深度学习方面的知识很有帮助,也是必然要

![[nlp] epoch、batchsize、batchnumber、iterations](/front/images/it_default2.jpg)