inplace专题

【Paddle】Inplace相关问题:反向传播、影响内存使用和性能

【Paddle】Inplace相关问题:反向传播、影响内存使用和性能 写在最前面inplace 的好处有哪些?能降低计算复杂度吗在反向传播时,Inplace为什么会阻碍呢?“计算图的完整性受损”表达有误原地操作 sin_()为什么原地操作会阻碍反向传播PaddlePaddle的特定情况 🌈你好呀!我是 是Yu欸 🌌 2024每日百字篆刻时光,感谢你的陪伴

PyTorch 的 Autograd、计算图、叶子张量、inplace 操作、动态图,静态图(来自知乎)

本博文来自:https://zhuanlan.zhihu.com/p/69294347 非常感谢此博主! PyTorch 作为一个深度学习平台,在深度学习任务中比 NumPy 这个科学计算库强在哪里呢?我觉得一是 PyTorch 提供了自动求导机制,二是对 GPU 的支持。由此可见,自动求导 (autograd) 是 PyTorch,乃至其他大部分深度学习框架中的重要组成部分。 了解自动求导背

python-Pandas inplace=True参数的使用

inplace = True:不创建新的对象,直接对原始对象进行修改; inplace = False:对数据进行修改,创建并返回新的对象承载其修改结果。 默认是False,即创建新的对象进行修改,原对象不变。

self.relu = nn.ReLU(inplace = True) 里面的inplace什么意思,一般怎么设置?

在深度学习中,ReLU(修正线性单元)是一种常用的激活函数,其定义为 f(x) = max(0, x)。nn.ReLU是在PyTorch中实现ReLU的类。 参数`inplace`是nn.ReLU类的一个可选参数,默认值为False。该参数控制着ReLU函数的计算方式。 当`inplace=False`时,ReLU函数会返回一个新的张量作为输出,不改变原始张量。这意味着原始张量在ReLU前后的

编译inplace_abn

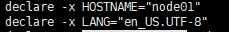

出现以上问题 1、检查pytorch版本,一般1.5以上 2、检查cuda版本,一般10.1以上 3、检查环境变量设置 linux:export -p 重点检查 PATH 、LD_LIBRARY_PATH 不能重复设置变量,将重复的删掉 unset LANG 是将LANG删掉 declare -x LANG是将LANG变量设置进去

python pandas中 inplace 参数理解

pandas 中 inplace 参数在很多函数中都会有,它的作用是:是否在原对象基础上进行修改 inplace = True:不创建新的对象,直接对原始对象进行修改; inplace = False:对数据进行修改,创建并返回新的对象承载其修改结果。 默认是False,即创建新的对象进行修改,原对象不变,和深复制和浅复制有些类似。 例: inplace=True情况: imp

模型训练----对输入变量原地操作(inplace operation)报错

遇到报错one of the variables needed for gradient computation has been modified by an inplace operation。意思是对输入x原地操作(inplace operation),一个变量在反向传播过程中被修改了,而不是按照预期的版本(version 0)更新,导致梯度不正确。 使用这句代码定位报错位置 torc