infiniband专题

配置InfiniBand (IB) 和 RDMA over Converged Ethernet (RoCE) 网络

配置InfiniBand (IB) 和 RDMA over Converged Ethernet (RoCE) 网络 服务器端配置 在服务器端,你需要确保安装了必要的驱动程序和软件包,并且正确配置了网络接口。 安装 OFED 首先,安装 Open Fabrics Enterprise Distribution (OFED),它包含了 InfiniBand 所需的驱动程序和库。 sudo

InfiniBand (IB) 和 RDMA over Converged Ethernet (RoCE)

在超算网络环境中,InfiniBand (IB) 和 RDMA over Converged Ethernet (RoCE) 是两种重要的网络技术,它们旨在提供高性能、低延迟的数据传输能力,适用于大规模并行计算任务。下面是对这两个技术的具体名词解释和应用场景的详细说明。 InfiniBand (IB) 名词解释 InfiniBand (IB):InfiniBand 是一种高性能计算和企业数据

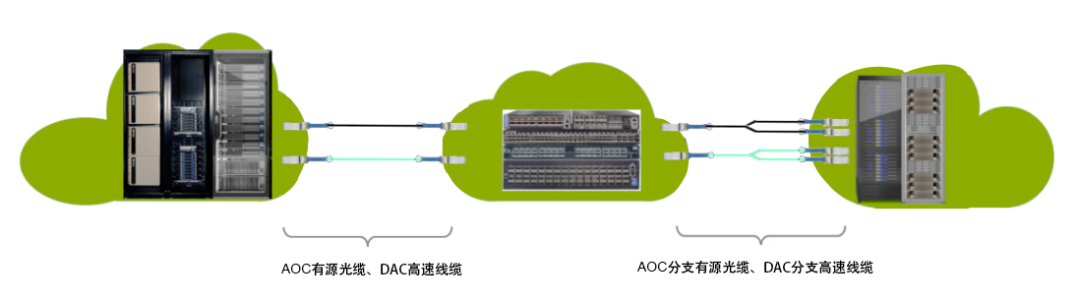

飞速(FS)InfiniBand光模块和线缆指南

InfiniBand网络架构因其高速、低延迟和可扩展性优势,广泛应用于高性能计算(HPC)。飞速(FS)提供多样化的InfiniBand光模块和线缆,为客户提供高性能InfiniBand网络解决方案,以建立高效可靠的网络连接。 飞速(FS)InfiniBand光模块和线缆概述 飞速(FS)现货供应40G到800G的InfiniBand光模块,提供多种封装(QSFP+、QSFP28、QSFP56

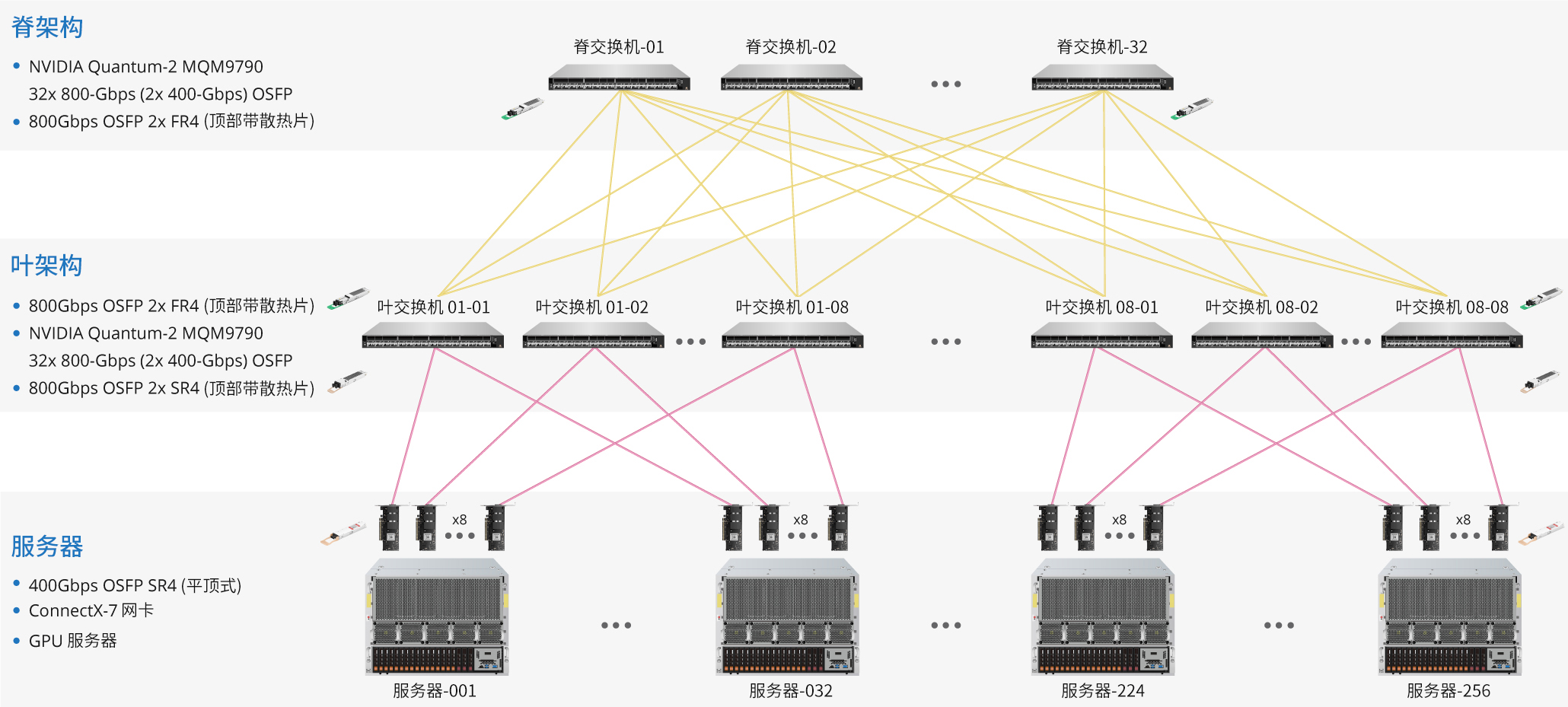

飞速(FS)InfiniBand解决方案构建HPC网络

面对HPC领域的不断发展,未来HPC业务核心在于HPC网络和基础设施。随着高性能计算应用的复杂性和数据量的增长,对弹性、可扩展和高效网络的需求变得日益迫切。HPC网络架构作为HPC系统运行的基础,在数据处理、管理和大规模存储方面至关重要。本文详细探讨了飞速(FS)HPC网络架构关键组成部分,阐述HPC数据中心网络的优势,并深入介绍飞速(FS)针对高性能计算(HPC)网络架构不同分区提供的全面解决方

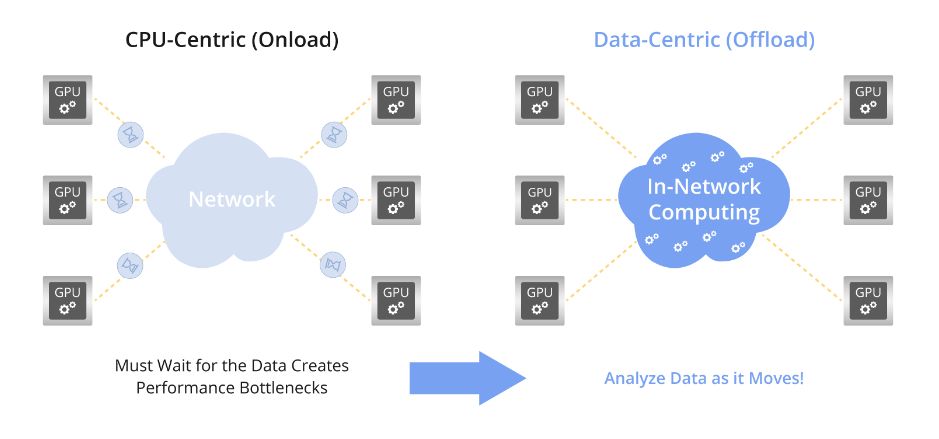

InfiniBand网络内计算架构指南

InfiniBand网络内计算知多少? InfiniBand在高性能计算和人工智能领域占据核心地位,其高速、低延迟的网络通信能力支持大规模数据传输与复杂计算。在网络内计算领域,InfiniBand的应用日益广泛,通过内部计算降低延迟,提升系统效率,为HPC和AI领域带来卓越的性能与智能。InfiniBand,助力前沿科技迈向更高峰。

如何利用仪表构造InfiniBand流量在数据中心测试中的应用

一、什么是Infiniband? 在当今数据爆炸的时代,数据中心作为信息处理的中心枢纽,面临着前所未有的挑战。传统的通信方式已经难以满足日益增长的数据传输需求,而InfiniBand技术的出现,为数据中心带来了全新的通信解决方案。 InfiniBand(IB)是一种高性能计算和数据中心网络架构,其设计目标是通过提供低延迟、高带宽以及可扩展性来满足大规模计算和数据传输的需求。让我们深入了解Infi

Linux 环境下 InfiniBand 组网认知

写在前面 工作中遇到,简单整理博文内容涉及 InfiniBand 简单认知,以及使用 ib_send_*和 iperf3 对 InfiniBand 组网进行测试 Demo理解不足小伙伴帮忙指正 对每个人而言,真正的职责只有一个:找到自我。然后在心中坚守其一生,全心全意,永不停息。所有其它的路都是不完整的,是人的逃避方式,是对大众理想的懦弱回归,是随波逐流,是对内心的恐惧 ——赫尔曼·黑塞

InfiniBand 网络

当前光纤通道和以太网已经能够支持 10Gbps和更高的速率。因此,在计算机中的主机 I/O总线必须能够以同样的速率发送数据。然而,与所有的并行总线一样,PCI总线限制了网络速度的进一步提高。 事实上,基于网络架构的 PCI 总线带宽要达到双向 2 Gbps 都很困难。 InfiniBand代表一种新兴的 I/O技术,它很有可能在高端服务器中取代PCI总线。作为

【C语言】Infiniband驱动mlx4_init_one

一、注释 这是Linux内核中Mellanox Ethernet网卡驱动程序mlx4模块的一部分代码,主要用于初始化一个PCI设备。以下是其注释: // 驱动的主结构体,包含了供PCI核心使用的勾子(hooks)static struct pci_driver mlx4_driver = {.name = DRV_NAME, // 驱动名称.id

【C语言】Infiniband驱动__mlx4_init_one函数

一、注释 Linux内核驱动程序中的部分,属于Mellanox网卡驱动mlx4的初始化过程。 // Mellanox 以太网驱动主程序代码static int __mlx4_init_one(struct pci_dev *pdev, int pci_dev_data,struct mlx4_priv *priv){int err; // 错误码变量int nvfs[MLX4_MAX_PO

【C语言】Infiniband驱动mlx4_reset

一、注释 这个 mlx4_reset 函数负责重置 Mellanox 设备。它保存了设备的 PCI 头信息,然后重置了设备,之后还原保存的 PCI 头信息。请注意,该函数是用英文注释的,下面提供中文注释的版本。以下是该函数的流程: 1. 为保存 PCI 头信息分配内存。 2. 如果存在 PCI Express 能力结构,则保存 PCI 头信息。 3. 映射硬件重置寄存器地址空间。 4. 获取硬件

Infiniband带宽和延迟的测试

一、带宽的测试。 1、找任意两台服务器,先查看IB的状态。 #ibstat 2、两台服务器都要重启IB的服务 # /etc/init.d/openibd restart 3、两台服务器都要开户子网管理器 #/etc/init.d/opensmd start 暂停子网管理器的命令是 # /etc/init.d/opensmd stop 4、第一台机执行

【C语言】InfiniBand驱动mlx4_register_interface函数

一、讲解 mlx4_register_interface函数是Mellanox InfiniBand驱动程序的一部分,这个函数的作用是注册一个新的接口(intf)到InfiniBand设备。这允许不同的子系统,如以太网或存储,能够在同一个硬件设备上注册它们各自需要的接口,在硬件资源上建立抽象层。这段代码是从网络驱动的源代码中取出来的,具体的操作流程是这样的: 1. 参数检查: 该函数首先检查传入

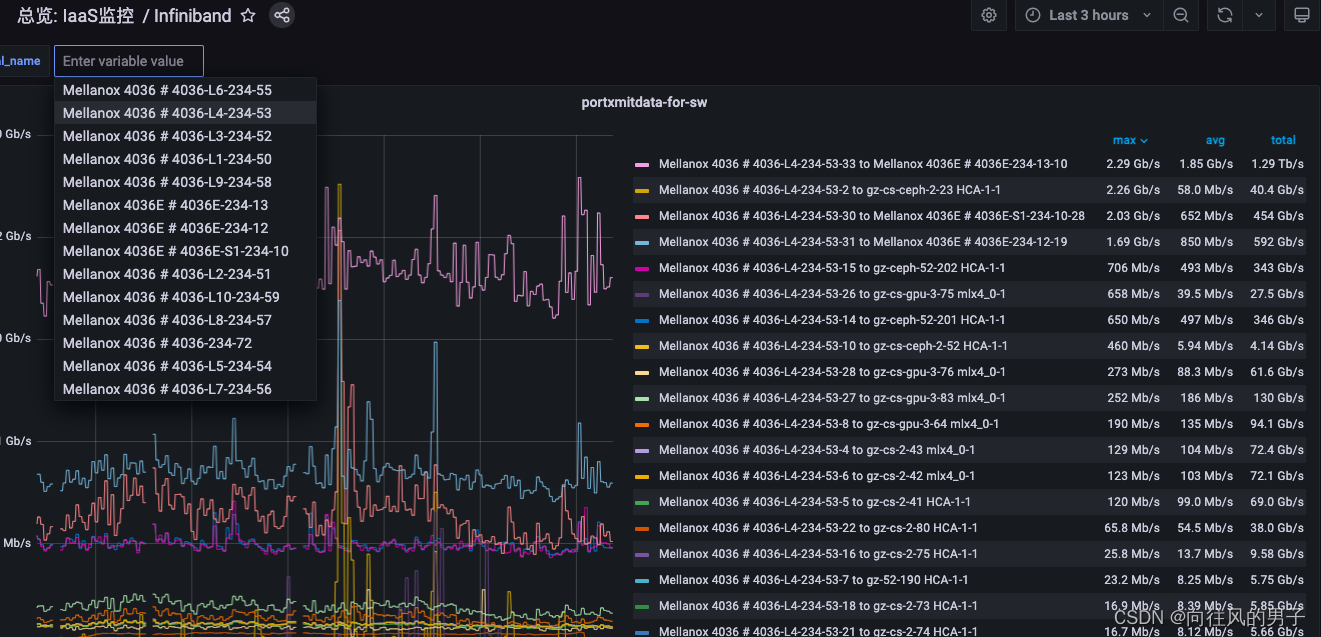

【infiniband监控】grafana变量使用细化优化监控指标

本站以分享各种运维经验和运维所需要的技能为主 《python零基础入门》:python零基础入门学习 《python运维脚本》: python运维脚本实践 《shell》:shell学习 《terraform》持续更新中:terraform_Aws学习零基础入门到最佳实战 《k8》暂未更新 《docker学习》暂未更新 《ceph学习》ceph日常问题解决分享 《日志收集》ELK+各种中间件

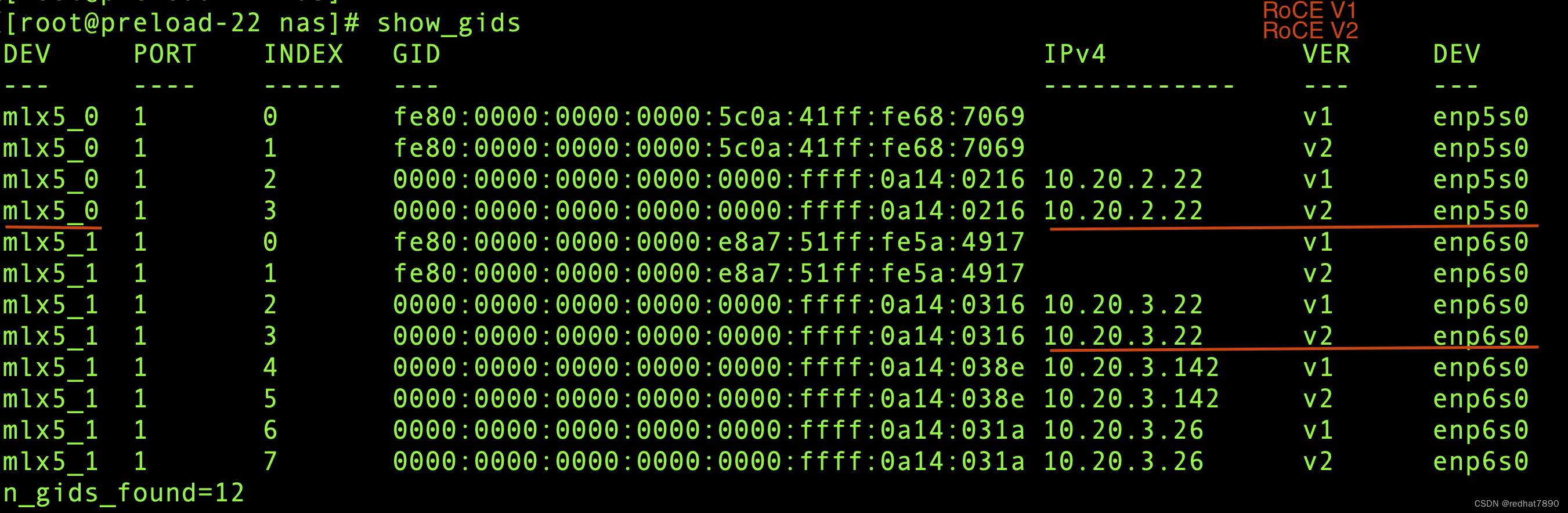

k8s infiniband 和 RoCE(RDMA over Converged Ethernet)

1. 部署 Mellanox/k8s-rdma-shared-dev-plugin 说明:文中用到的镜像是自定义的,文末有其Dockerfile 文件。 克隆代码 git clone https://github.com/Mellanox/k8s-rdma-shared-dev-plugin.git 查看网卡的 vendors 查看 网卡的bdf lspci |grep -i mell

【C语言】InfiniBand 驱动mlx4_ib_init和mlx4_ib_cleanup

一、中文讲解 这两个函数是Linux内核模块中对于Mellanox InfiniBand 驱动程序初始化和清理的函数。 mlx4_ib_init()函数是模块初始化函数,使用__init宏标注,表示该函数只在模块加载时运行一次。 函数执行的步骤如下: 1. 通过alloc_ordered_workqueue创建一个有序的工作队列wq。这个队列用于将工作项按顺序排队执行,WQ_MEM_RECL

UEC(Ultra-Ethernet-consortium)新技术联盟,磨刀霍霍向着InfiniBand

许久没更了,最近天天在鼓捣高速端口,死磕112Gb/S 的一段日子。 新增Multi-Streams的功能支持,然后配合交换机的厂商各种验证测试(打鸡血.JPEG) 又在协助客户测试网卡的案子,天天被RDMA各种QP逻辑给烧脑 关注到新成立的一个高速互联技术联盟,粗略看起来就是要革InfiniBand 网络的命,那句话怎么说来着,天下苦IB网络久已... 手动搬运了一

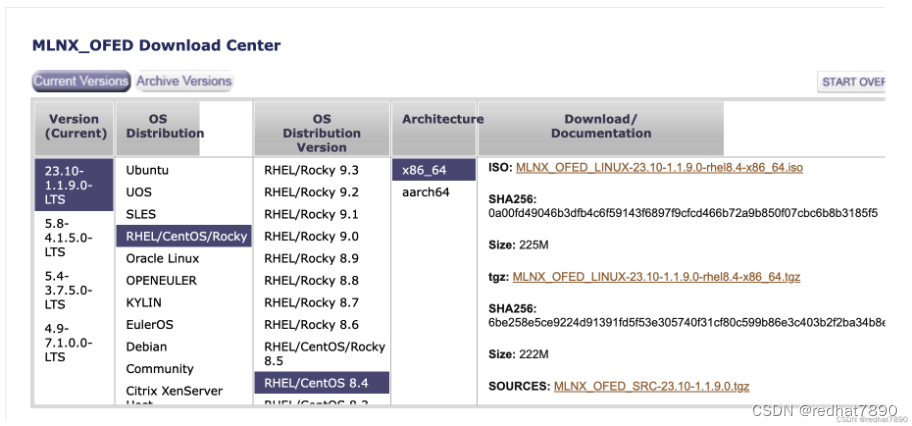

centos7.4安装Infiniband网卡驱动以及“Module xxx belong to kernel which is not a part of MLNX……”错误解决

背景说明 实验室集群环境系统更新,导致之前的Infiniband网卡驱动不可用了,因此安装新的驱动 详细步骤 1.去官网下载指定版本 下载安装包 官网版本列表 我这里下载的是对应的7.4 支持Centos7.4的驱动 ps:查看自己系统版本的命令: lsb_release -a 或者: cat /etc/redhat-release 2.查看支持情况 解压刚下载的MLNX

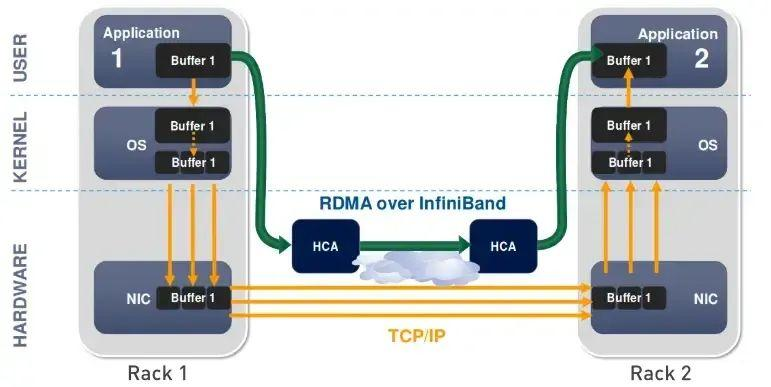

RDMA vs InfiniBand 网卡接口如何区分?

(该架构图来源于参考文献) 高性能计算网络,RoCE vs. InfiniBand该怎么选? 新 RoCEv2 标准可实现 RDMA 路由在第三层以太网网络中的传输。RoCEv2 规范将用以太网链路层上的 IP 报头和 UDP 报头替代 InfiniBand 网络层。这样,就可以在基于 IP 的传统路由器之间路由 RoCE。 RoCE v1协议:基于以太网承载 RDMA,只能部

100GB Mellanox InfiniBand 网卡虚拟化技术调研

调研目的 验证 Mellanox InfiniBand 100GB网卡和SR650 Server能兼容 ThinkSystem SR650 Power On (Booting OS or in undetected OS) Machine Type/Model7X05CTO1WW 验证 SR-IOV虚拟话技术在BIOS/Firmware/Kernel/QEMU/Libvirt能被支持

【linux】更改infiniband卡在Debian系统的网络接口名

在Debian或任何其他基于Linux的系统中,网络接口的名称由udev系统管理。通过创建udev规则,可以修改网络接口名称。以下是更改InfiniBand卡接口名称的一般步骤: 1. 找到网络接口的属性,以编写匹配的udev规则 可以使用`udevadm`命令查找设备属性: udevadm info -a -p /sys/class/net/ib0 在输出中,查找可以

InfiniBand网络带宽从SDR、DDR、QDR、FDR、EDR、HDR到NDR发展

InfiniBand(直译为 “无限带宽” 技术,缩写为IB)是一个为大规模、易扩展机群而设计的网络通信技术。可用于计算机内部或外部的数据互连,服务器与存储系统之间的直接或交换互连,以及存储系统之间的互连。 InfiniBand最重要的一个特点就是高带宽、低延迟,因此在高性能计算项目中广泛的应用。 主要用于高性能计算(HPC)、高性能集群应用服务器和高性能存储。

【infiniband】RDMA_CM使用多QP

要创建多个QP,可以简单地多次调用`rdma_create_qp`函数,使用相同的`p_ibv_pd`(保护域)但是不同的`rdma_cm_id`和`qp_attr`。不需要多个`p_ibv_pd`来创建多个QP(队列对)。保护域是一个本地资源,可以被多个QP共享。在Infiniband架构中,保护域主要用于资源的隔离和保护。它为多个QP提供了一个共享的上下文环境。 例如: struct rdm

InfiniBand 的前世今生

今年,以 ChatGPT 为代表的 AI 大模型强势崛起,而 ChatGPT 所使用的网络,正是 InfiniBand,这也让 InfiniBand 大火了起来。那么,到底什么是 InfiniBand 呢?下面,我们就来带你深入了解 InfiniBand。 InfiniBand的发展历史 InfiniBand(也称为“无限带宽”,缩写为 IB)是一个用于高性能计算的计算机网络通信标准,它具有极

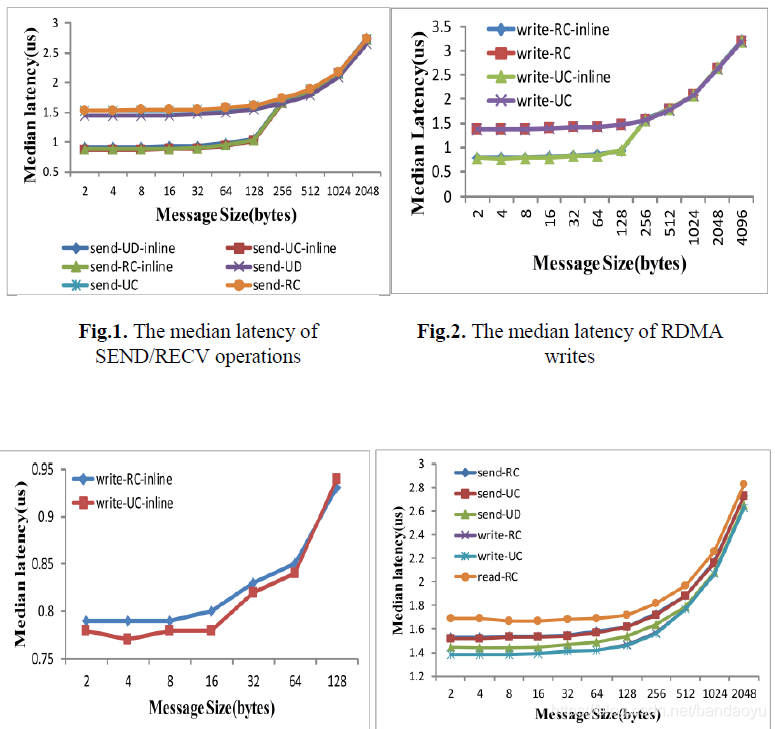

【RDMA】infiniband提升Redis性能|UC和RC时延比较|RC和UD性能比较

目录 infiniband应用到Redis之后的提升效果 WAN上InfiniBand传输服务的实验分析 RC和UD性能比较 UC和RC的区别 (https://www.mellanox.com/related-docs/prod_software/RDMA_Aware_Programming_user_manual.pdf) RDMA 架构与实践 | https://houmin.cc/po

InfiniBand网络带宽从SDR、DDR、QDR、FDR、EDR、HDR到NDR发展

InfiniBand(直译为 “无限带宽” 技术,缩写为IB)是一个为大规模、易扩展机群而设计的网络通信技术。可用于计算机内部或外部的数据互连,服务器与存储系统之间的直接或交换互连,以及存储系统之间的互连。 InfiniBand最重要的一个特点就是高带宽、低延迟,因此在高性能计算项目中广泛的应用。 主要用于高性能计算(HPC)、高性能集群应用服务器和高性能存储。