headed专题

Transformer系列专题(二)——multi-headed多头注意力机制

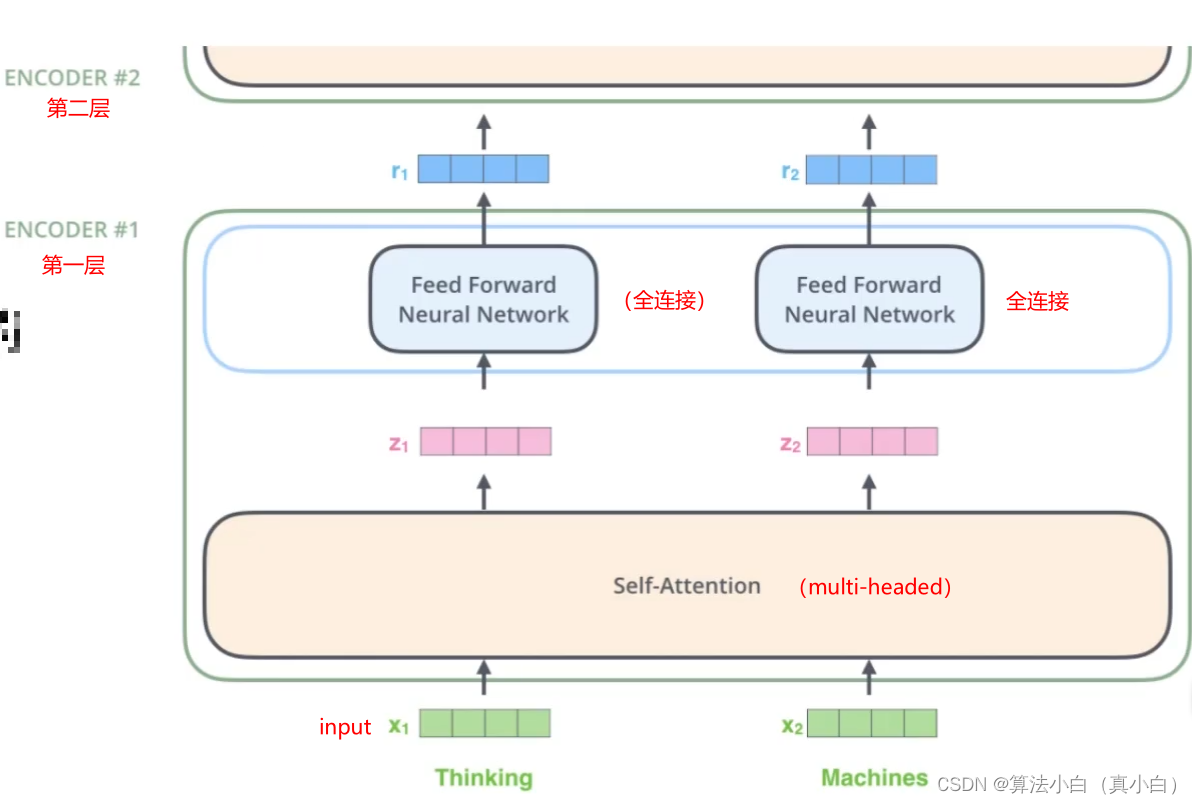

提示:文章写完后,目录可以自动生成,如何生成可参考右边的帮助文档 文章目录 前言一、什么是multi-headed(多头注意力机制)二、multi-headed三、multi-headed结果四、堆叠多层总结 前言 在实践中,当给定相同的查询、键和值的集合时,我们希望模型可以基于相同的注意力机制学习到不同的行为,然后将不同的行为作为知识组合起来,例如捕获序列内各种范围

深度学习代码|Multi-Headed Attention (MHA)多头注意力机制的代码实现

相关文章 李沐《动手学深度学习》注意力机制 文章目录 相关文章一、导入相关库二、准备工作(一)理论基础(二)定义PrepareForMultiHeadAttention模块 三、多头注意模块(一)理论基础(二)创建MultiHeadAttention模块 一、导入相关库 import mathfrom typing import Optional, List# 从 t