gguf专题

diffusion 模型gguf量化使用案例,支持CPU运行

参考: https://github.com/leejet/stable-diffusion.cpp 在线demo使用: https://colab.research.google.com/drive/1NkAzSn3iYOwkY1Jy7qJfV_d2ZMHQmXrK?usp=sharing 一般gguf量化质量 fp16 > Q8 > fp8 > Q4 > Q4k_m > Q4k_

llama.cpp制作GGUF文件

llama.cpp的介绍 llama.cpp是一个开源项目,由Georgi Gerganov开发,旨在提供一个高性能的推理工具,专为在各种硬件平台上运行大型语言模型(LLMs)而设计。这个项目的重点在于优化推理过程中的性能问题,特别是针对CPU环境。以下是关于llama.cpp的几个关键特性: 高性能推理引擎:llama.cpp使用C语言编写的机器学习张量库ggml,这使得它能够高效地处理大

AI大模型量化格式介绍(GPTQ,GGML,GGUF,FP16/INT8/INT4)

在 HuggingFace 上下载模型时,经常会看到模型的名称会带有fp16、GPTQ,GGML等字样,对不熟悉模型量化的同学来说,这些字样可能会让人摸不着头脑,我开始也是一头雾水,后来通过查阅资料,总算有了一些了解,本文将介绍一些常见的模型量化格式,因为我也不是机器学习专家,所以本文只是对这些格式进行简单的介绍,如果有错误的地方,欢迎指正。 What 量化 量化在 AI 模型中,特别是在深度

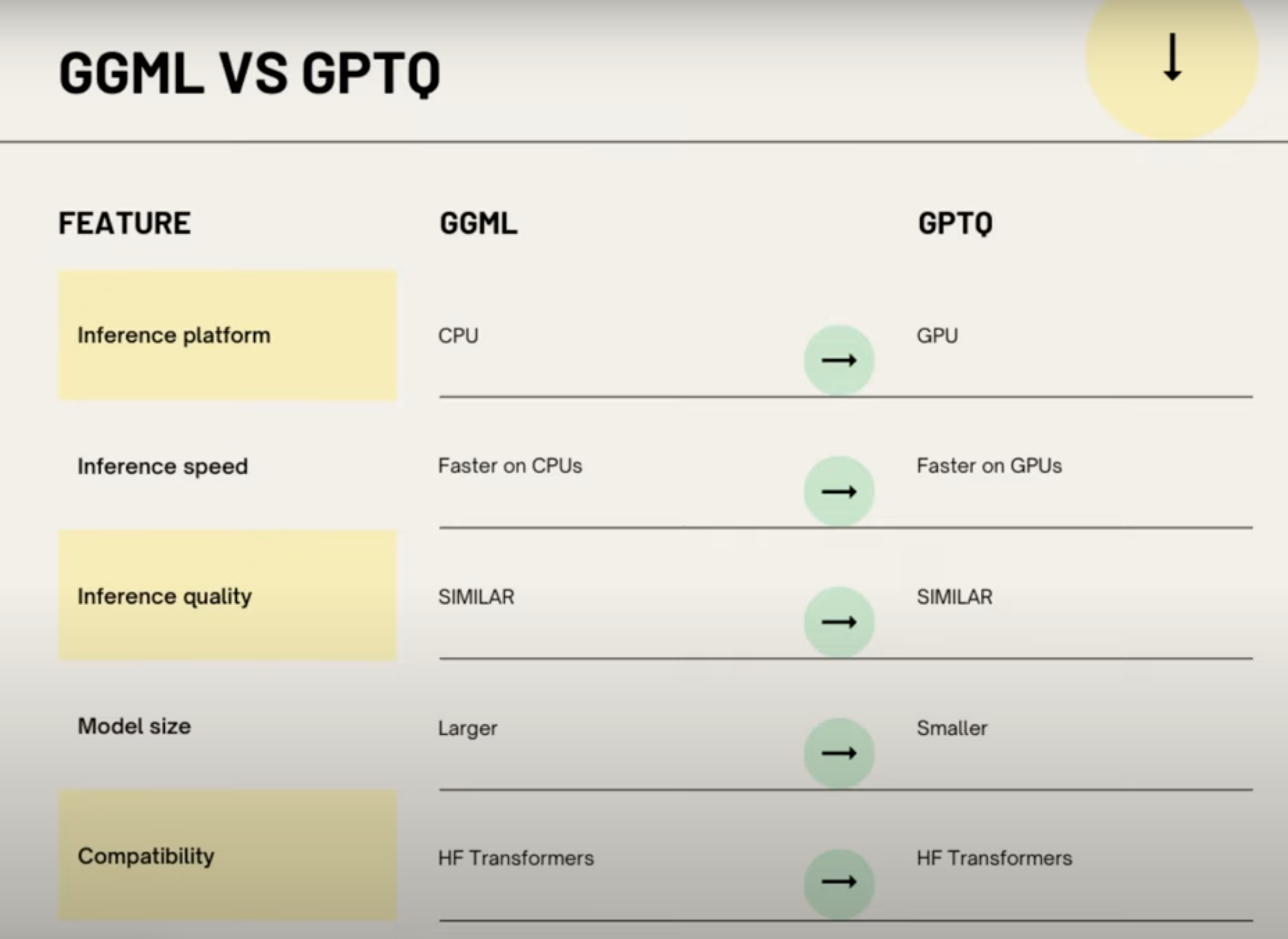

[大模型]大语言模型量化方法对比:GPTQ、GGUF、AWQ

在过去的一年里,大型语言模型(llm)有了飞速的发展,在本文中,我们将探讨几种(量化)的方式,除此以外,还会介绍分片及不同的保存和压缩策略。 说明:每次加载LLM示例后,建议清除缓存,以防止出现OutOfMemory错误。 del model, tokenizer, pipe import torch torch.cuda.empty_cache() 如果在jupyter中无法释放显存,请

大模型中 .safetensors 文件、.ckpt文件、.gguf和.pth以及.bin文件区别、加载和保存以及转换方式

在大模型中,.safetensors、.ckpt、.gguf、.pth 和 .bin 文件都是用于保存和加载模型参数的文件格式,它们之间的区别和转换方式如下: .safetensors 文件: 这是 TensorFlow 2.x 中新增的文件格式,用于保存模型参数和优化器状态。它采用的是 TensorFlow 的自定义序列化格式,不能直接用于其他框架。可以使用 TensorFlo

用GGUF和Llama.cpp量化Llama模型

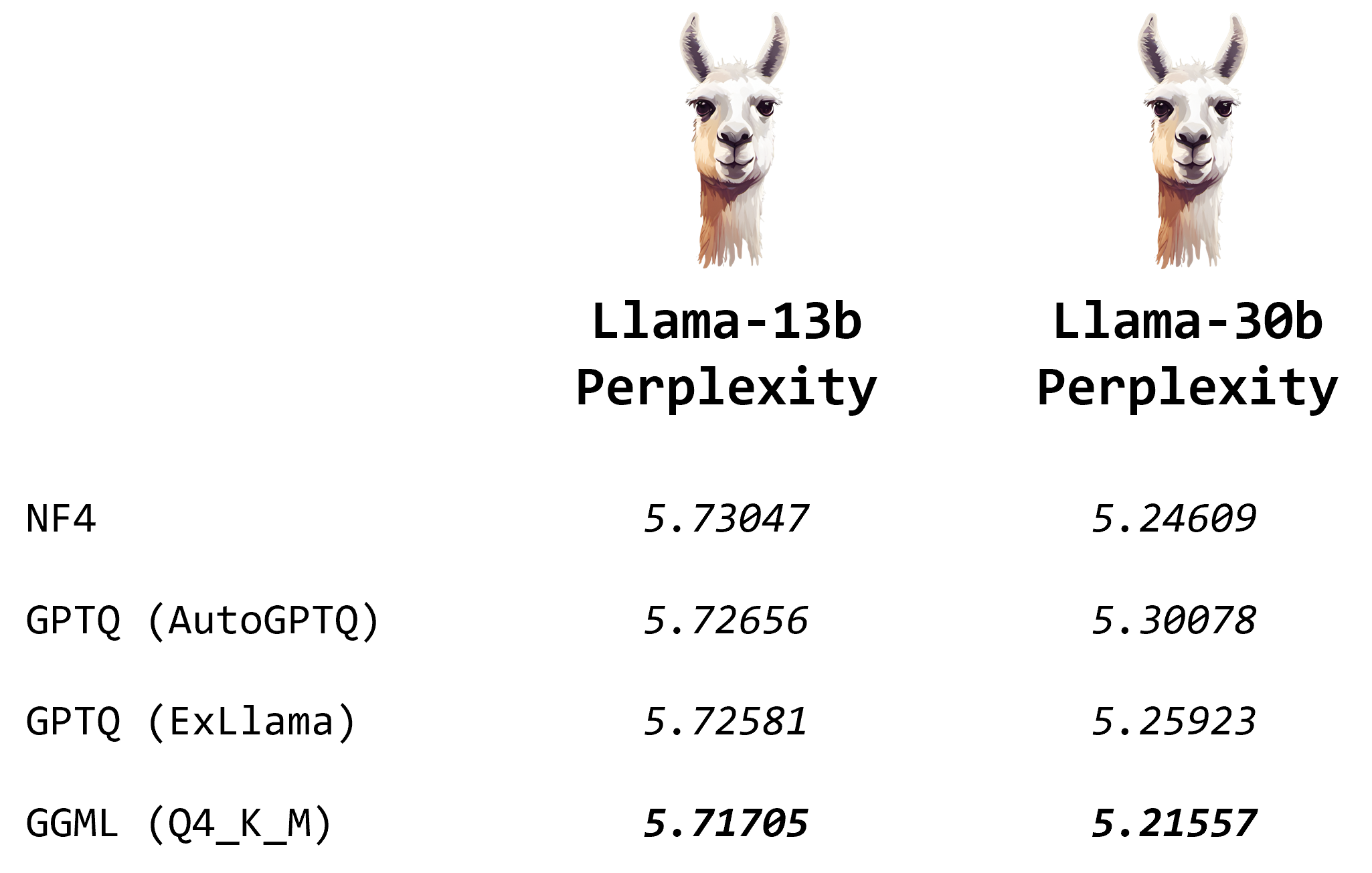

用GGUF和Llama .cpp量化Llama模型 什么是GGML如何用GGML量化llm使用GGML进行量化NF4 vs. GGML vs. GPTQ结论 由于大型语言模型(LLMS)的庞大规模,量化已成为有效运行它们的必要技术。通过降低其权重的精度,您可以节省内存并加快推理,同时保留大部分模型性能。最近,8-bit和4-bit量化解锁了在消费者硬件上运行LLM的可能性。加上Ll

第二十篇-推荐-纯CPU(E5-2680)推理-llama.cpp-qwen1_5-72b-chat-q4_k_m.gguf

环境 系统:CentOS-7 CPU: Intel® Xeon® CPU E5-2680 v4 @ 2.40GHz 14C28T 内存: 48G DDR3 依赖安装 make --versionGNU Make 4.3gcc --versiongcc (GCC) 11.2.1 20220127 (Red Hat 11.2.1-9)g++ --versiong++ (GCC) 11.2.

![[大模型]大语言模型量化方法对比:GPTQ、GGUF、AWQ](https://img-blog.csdnimg.cn/direct/d6c45a74737d479e9f98d0f6ed5893c4.png)