electra专题

超越 BERT 模型的 ELECTRA 代码解读

文章目录 1、概述2、ELECTRA 模型2.1 总体框架2.2 代码框架2.3 pretraining 阶段2.3.1 主方法入口2.3.2 数据 mask2.3.3 Generator BERT2.3.4 Discrimina BERT2.3.5 总的损失函数2.3.6 模型优化以及 checkpoint 2.4 finetuning 阶段2.5 序列训练改进2.5.1 TPU 改 GP

第10章: 明星级轻量级高效Transformer模型ELECTRA: 采用Generator-Discriminator的Text Encoders解析及ELECTRA模型源码完整实现

1,GAN:Generative Model和Discriminative Model架构解析 2,为什么说ELECTRA是NLP领域轻量级训练模型明星级别的Model? 3,使用replaced token detection机制规避BERT中的MLM的众多问题解析 4,以Generator-Discriminator实现的ELECTRA预训练架构解析 5,ELECTRTA和GAN的在数

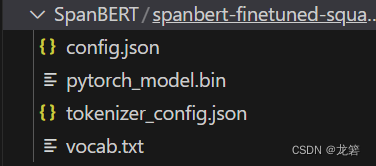

BERT变体(1):ALBERT、RoBERTa、ELECTRA、SpanBERT

Author:龙箬 Computer Application Technology Change the World with Data and Artificial Intelligence ! CSDN@weixin_43975035 *天下之大,虽离家万里,何处不可往!何事不可为! 1. ALBERT \qquad ALBERT的英文全称为A Lite version of BE

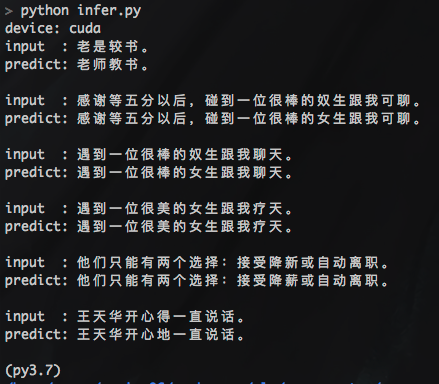

pycorrector一键式文本纠错工具,整合了BERT、MacBERT、ELECTRA、ERNIE等多种模型,让您立即享受纠错的便利和效果

pycorrector:一键式文本纠错工具,整合了Kenlm、ConvSeq2Seq、BERT、MacBERT、ELECTRA、ERNIE、Transformer、T5等多种模型,让您立即享受纠错的便利和效果 pycorrector: 中文文本纠错工具。支持中文音似、形似、语法错误纠正,python3开发。实现了Kenlm、ConvSeq2Seq、BERT、MacBERT、ELECTRA、E