dilateformer专题

YOLOV8注意力改进方法:DilateFormer多尺度空洞 Transformer(附改进代码)

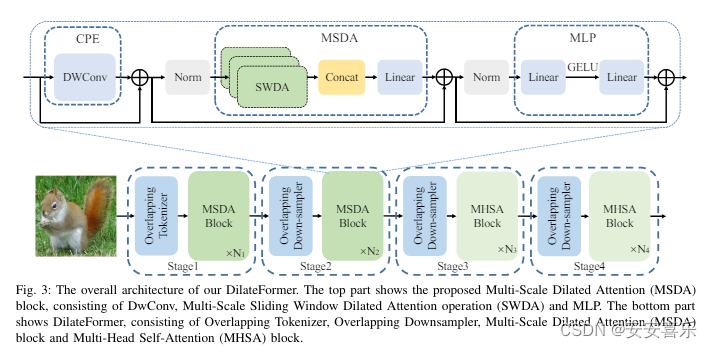

原论文地址:原论文下载地址 即插即用的多尺度全局注意力机制 本文提出了一种新颖的多尺度空洞 Transformer,简称DilateFormer,以用于视觉识别任务。原有的 ViT 模型在计算复杂性和感受野大小之间的权衡上存在矛盾。众所周知,ViT 模型使用全局注意力机制,能够在任意图像块之间建立长远距离上下文依赖关系,但是全局感受野带来的是平方级别的计算代价。同时,有些研究表明,在浅层特征上

注意力机制篇 | YOLOv8改进之添加多尺度全局注意力机制DilateFormer(MSDA)| 即插即用

前言:Hello大家好,我是小哥谈。多尺度全局注意力机制DilateFormer是一种用图像识别任务的深度学习模型。它是在Transformer模型的基础上进行改进的,旨在提高模型对图像中不同尺度信息的感知能力。DilateFormer引入了多尺度卷积和全局注意力机制来实现多尺度感知。具体来说,它使用了一系列不同尺度的卷积核对输入图像进行卷积操作,从而捕捉到不同尺度下的特征信息。这样可以使得

YOLOv7改进:全网原创首发 | 多尺度空洞注意力(MSDA) | 中科院一区顶刊 DilateFormer 2023.9

💡💡💡本文全网首发独家改进:多尺度空洞注意力(MSDA)采用多头的设计,在不同的头部使用不同的空洞率执行滑动窗口膨胀注意力(SWDA),全网独家首发,创新力度十足,适合科研 1)作为注意力MSDA使用; 推荐指数:五星 多尺度空洞注意力(MSDA) | 亲测在多个数据集能够实现涨点,这样可以在被关注的感受野内的各个尺度上聚合语义信息,并有效地减少自注意力机制的冗余 收录

YOLOv7改进:全网原创首发 | 多尺度空洞注意力(MSDA) | 中科院一区顶刊 DilateFormer 2023.9

💡💡💡本文全网首发独家改进:多尺度空洞注意力(MSDA)采用多头的设计,在不同的头部使用不同的空洞率执行滑动窗口膨胀注意力(SWDA),全网独家首发,创新力度十足,适合科研 1)作为注意力MSDA使用; 推荐指数:五星 多尺度空洞注意力(MSDA) | 亲测在多个数据集能够实现涨点,这样可以在被关注的感受野内的各个尺度上聚合语义信息,并有效地减少自注意力机制的冗余 收录