decoupled专题

Bootstrapping Vision-Language Learning with Decoupled Language Pre-training

我们可以使用以下这六个标准,旨在全面分类视觉语言 (VL) 研究: 学习范式: 该标准区分模型的训练方式。 特定任务学习是一种传统方法,其中模型从头开始针对特定任务(例如视觉问答)进行训练。这种方法很简单,但可能无法很好地泛化到其他任务。端到端预训练涉及在特定任务上微调模型之前,先在大型图像文本数据集上对其进行训练。这利用了从大型数据集中学到的知识,通常会带来更好的性能。基于冻结 LLM 的方

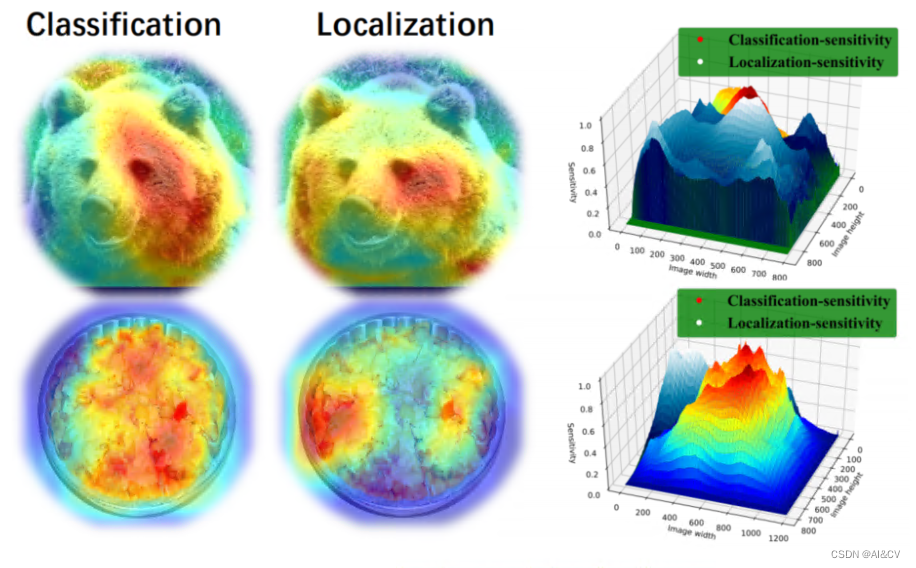

Scale Decoupled Distillation

摘要 Logit知识蒸馏因其实用性在近年来的研究中越来越受到重视。然而,与特征知识蒸馏相比,它的性能往往较差。在本文中,我们认为现有的基于Logit的方法可能是次优的,因为它们只利用了耦合多个语义知识的全局Logit输出。这可能会把模棱两可的知识传递给学生,误导他们学习。为此,我们提出了一种简单而有效的logit知识蒸馏方法,即尺度解耦蒸馏(SOD)。SOD**将全局logit输出解耦为多个局部

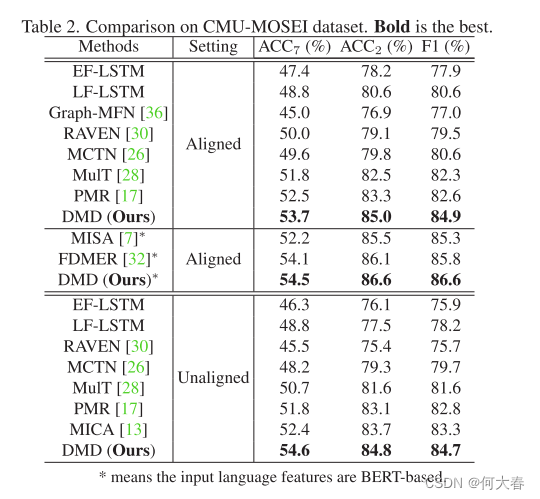

Decoupled Multimodal Distilling for Emotion Recognition 论文阅读

Decoupled Multimodal Distilling for Emotion Recognition 论文阅读 Abstract1. Introduction2. Related Works2.1. Multimodal emotion recognition2.2. Knowledge distillation3. The Proposed Method3.1. Multimod

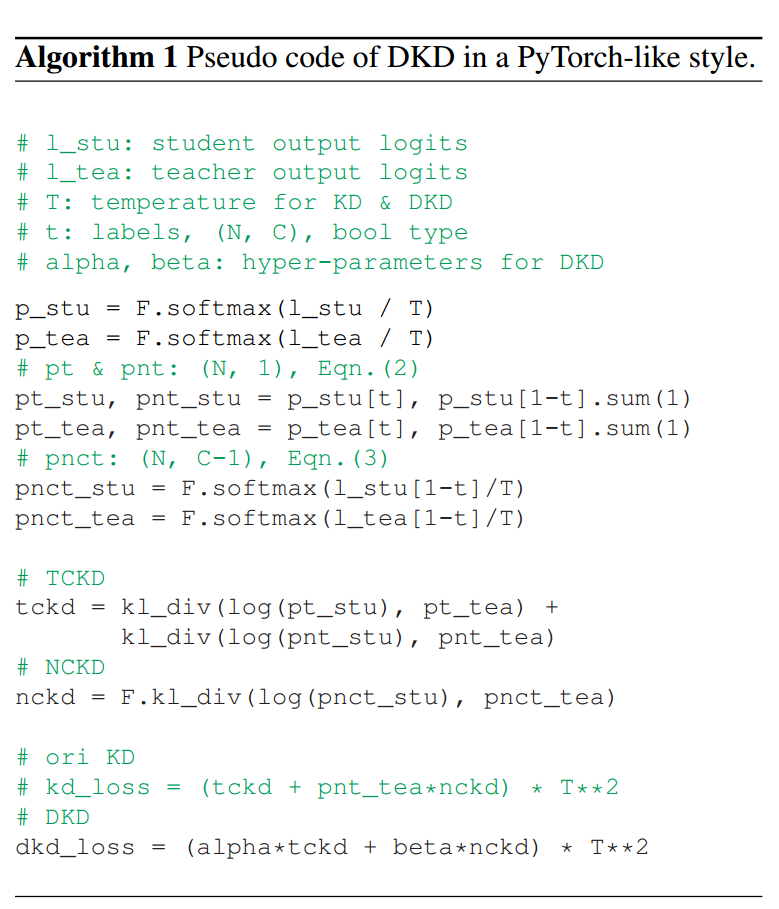

Decoupled Knowledge Distillation解耦知识蒸馏

Decoupled Knowledge Distillation解耦知识蒸馏 现有的蒸馏方法主要是基于从中间层提取深层特征,而忽略了Logit蒸馏的重要性。为了给logit蒸馏研究提供一个新的视角,我们将经典的KD损失重新表述为两部分,即目标类知识蒸馏(TCKD)和非目标类知识蒸馏(NCKD)。我们实证研究并证明了两部分的效果:TCKD转移了关于训练样本“难度”的知识,而NCKD是logit蒸馏

YOLOv7改进:加入解耦头Decoupled_Detect,涨点明显

💡💡💡本文全网首发独家改进:Decoupled_Detect,Hybrid Channels 策略重新设计了一个更高效的解耦头结构 Decoupled_Detect | 亲测在多个数据集能够实现涨点,多尺度特性在小目标检测表现也十分出色。 收录: YOLOv7高阶自研专栏介绍: http://t.csdnimg.cn/tYI0c ✨✨✨前沿最新计算机顶会复现 🚀🚀🚀