consumer专题

RocketMQ源码分析----Consumer消费进度相关

在Consumer消费的时候总有几个疑问: 消费完成后,这个消费进度存在哪里消费完成后,还没保存消费进度就挂了,会不会导致重复消费 Consumer 消费进度保存 消费完成后,会返回一个ConsumeConcurrentlyStatus.CONSUME_SUCCESS告诉MQ消费成功,以MessageListener的consumeMessage为入口分析。 消费的时候,是以Consum

hdu 3449 Consumer (依赖01背包)

题目: 链接:点击打开链接 题意: 思路: dp[i][j]表示前i个箱子装j钱的材料能够得到的最大价值。 代码: #include<iostream>#include<cstdio>#include<cstring>using namespace std;#define MAXN 100010int dp[55][MAXN];int mai

如何判断这个方法的调用来自dubbo consumer

这个是比较好玩的一个问题? 如何判断呢? 1、Thread.name Thread.currentThread().getName().startsWith("DubboServerHandler") 2、org.apache.dubbo.rpc.RpcContext.getContext() org.apache.dubbo.common.URL url = org.apache.d

SP2010开发和VS2010专家食谱--第六章节--Web Services和REST(4)--创建一个REST consumer

本文我们使用SharePoint REST APIs从SharePoint列表中抽取数据显示在Windows应用程序中。

dubbo做服务治理,搭建服务提供者provider和消费者consumer

公司的系统是分布式的。dubbo+zookeeper。 主要用dubbo做服务治理。web应用做流程控制,dubbo服务做具体业务逻辑。 dubbo的概念和用法有了解,一直想自己搭一下。趁这个周六,开始。 ----------------------------------------------------------------------------------

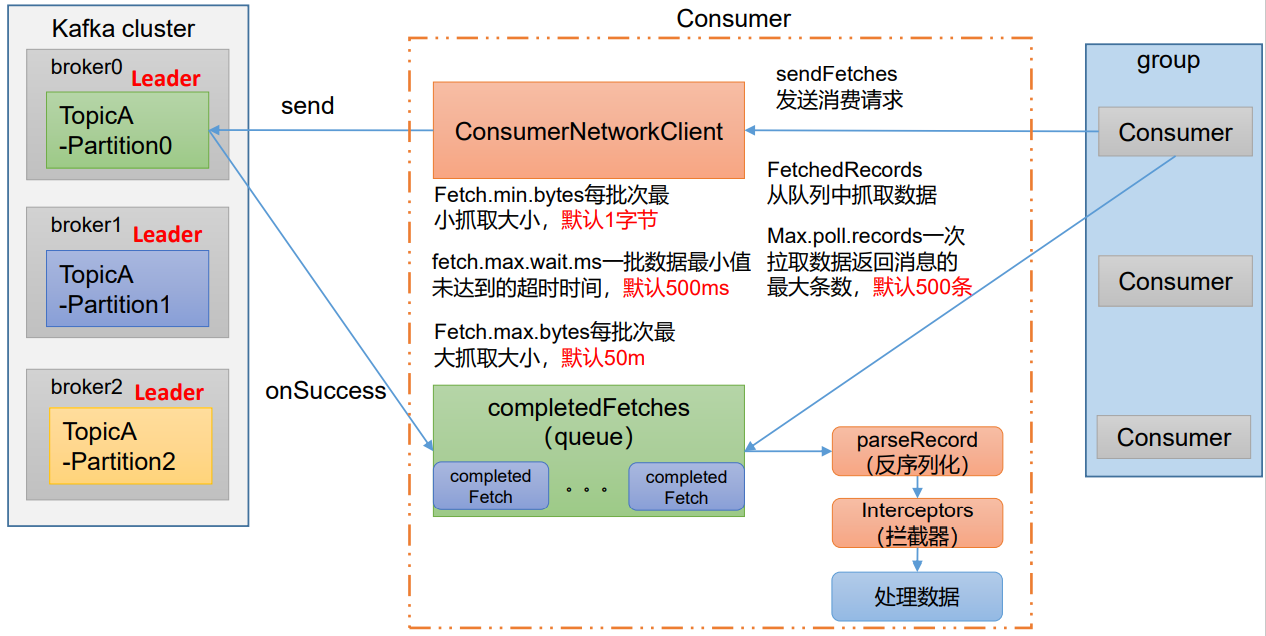

图解系列 图解Kafka之Consumer

文章目录 术语消息主题和分区集群和分区副本消费者组重新平衡组/分区再均衡消费者的分区策略群组协调者Coordinator 和群组领导者 Group Leader 流程初始化流程消费流程Consumer重平衡 消费者核心配置示例代码高级提交偏移量的几种方式自动提交手动同步提交手动异步提交提交特定偏移量 一次读取多条消息 参考 Kafka 可视化:https://softwarem

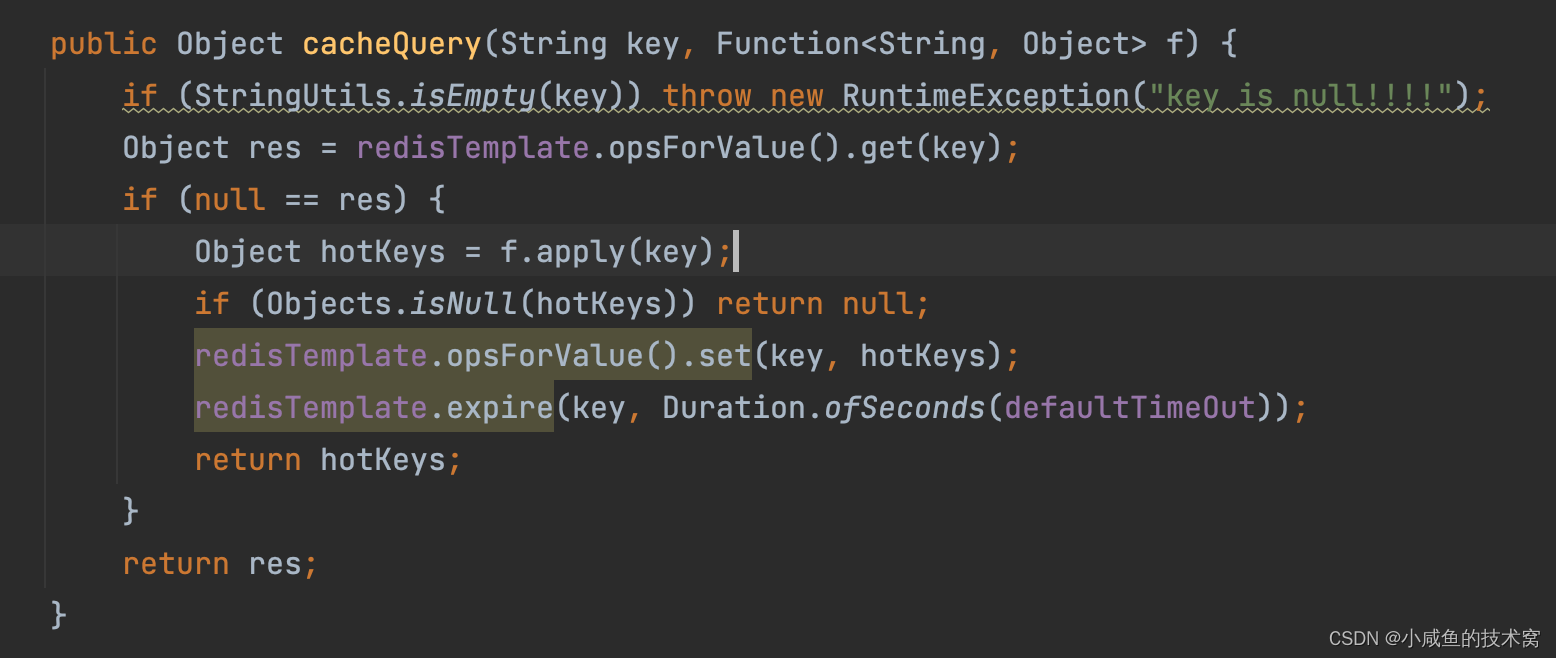

函数式开发接口( Consumer、Function)在实际开发中的应用场景

之前有个扫码下载文件需求,由于要同时进行记录下载人的记录。一开始用的是异步进行日志记录。发现有的用户扫码下载了一次文件,日志记录了三条。这种很容易联想到是因为网络抖动造成的。 问题代码 由于日志记录是异步的,文件下载需要时间。同时发 3 个请求过来,日志会进行记录三次,而文件只会下载一个。 //保存日志tabDzzzhzService.saveDownLog();//下载文件shor

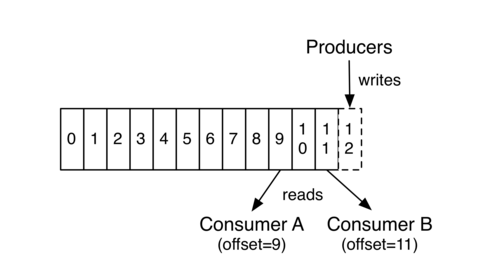

kafka的分区(partion)和消费者(consumer)

分区(partion) kafka中的topic可以细分为不同的partion,一个topic可以将消息存放在不同的partion中。 leader和follower 每个partion可以设置一个leader和多个follower。kafka的消息没有设置读写分离,每个消息发送时,都是发送至对应的partion的leader-paertion,follower-partion主要是为了备份

java8-consumer源码

@FunctionalInterfacepublic interface Consumer<T> {void accept(T t);default Consumer<T> andThen(Consumer<? super T> after) {Objects.requireNonNull(after);return (T t) -> { accept(t); after.accept(t);

spring cloud 向eureka注册中心 注册consumer

1.pom配置文件 <!-- 注册eureka --><dependency><groupId>org.springframework.cloud</groupId><artifactId>spring-cloud-starter-eureka</artifactId></dependency><!-- 打印日志 --><dependency><groupId>org.springframe

Java8-Function-Consumer-Predicate

函数式接口 概念: 针对函数式编程接口,一般可以定义为: Consumer c = (o) -> {System.out.println(o);}; // 函数式编程接口都只有一个抽象方法,因此在采用这种写法时,编译器会将这段函数编译后当作该抽象方法的实现// 如果接口有多个抽象方法,编译器就不知道这段函数应该是实现哪个方法的了。// 因此,=后面的函数体我们就可以看成是accept

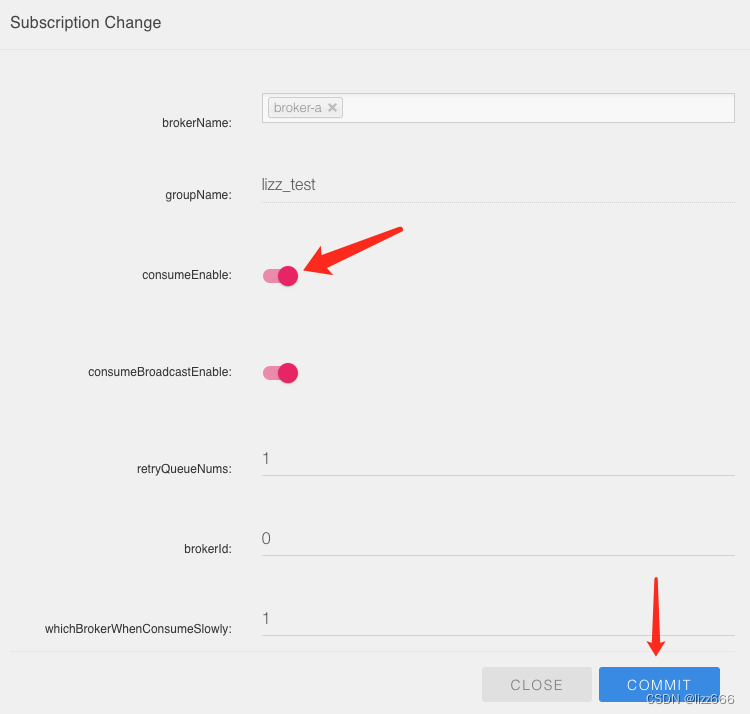

RocketMQ:新增consumer消费组group从最新消息开始消费skip last offset message

场景 想创建一个新的consumer去消费一个已经再使用的topic时,默认情况下会从topic中的第一条消息开始消费,大多数情况是需要从最新的消息开始。然后再使用CONSUME_FROM_LAST_OFFSET设置时并不会对新的consumer生效,它只是在停用consumer重新启用时,如果之前订阅OFFSET消息已经不存在了(默认rocketmq中存放的消息是72小时)就会

kafka consumer 配置详解

转载自:http://www.58maisui.com/2016/11/15/884/#coordinator 1、Consumer Group 与 topic 订阅 每个Consumer 进程都会划归到一个逻辑的Consumer Group中,逻辑的订阅者是Consumer Group。所以一条message可以被多个订阅message 所在的topic的每一个Consumer Gro

kafka consumer 总结及配置详解学习

目录 1、Consumer Group 与 topic 订阅 1.1 Consumer 与 partition 1.2 Consumer 与Consumer Group 1.3 Coordinator 1.4 Consumer Group Management 2、Consumer Fetch Message 2.1 poll 方法 2.2 commit offset 3、Con

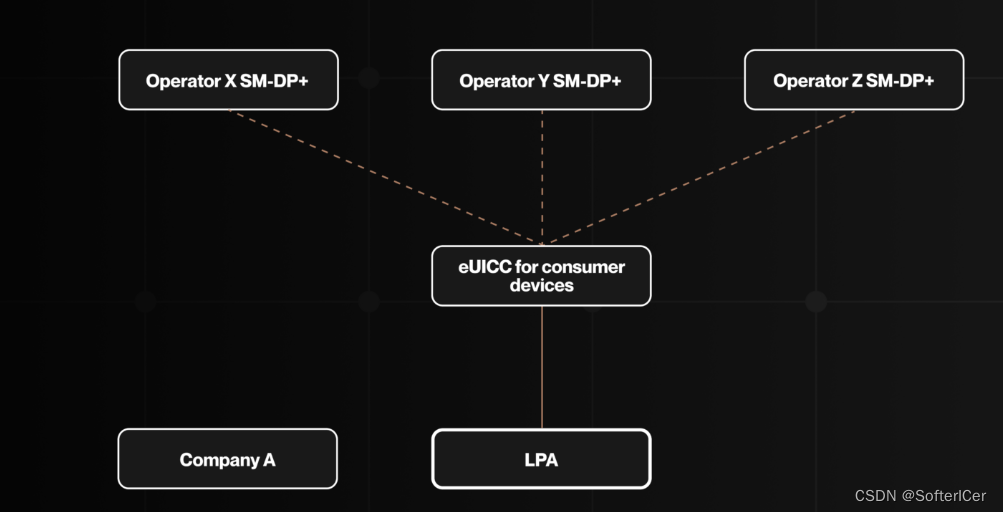

eSIM IoT vs M2M vs Consumer

有任何关于GSMA\IOT\eSIM\RSP\业务应用场景相关的问题,欢迎+W: xiangcunge59 一起讨论, 共同进步 (加的时候请注明: 来自CSDN-iot). 截至2023年5月,全球移动通信系统协会(GSMA)发布了三个关键的eSIM技术规范,这些规范塑造了当前物联网(IoT)生态系统: 1. **GSMA SGP.02**: eUICC for M2M devices

CDH-Kafka-SparkStreaming 异常:org.apache.kafka.clients.consumer.KafkaConsumer.subscribe(Ljava/uti

参考文章: flume kafka sparkstreaming整合后集群报错org.apache.kafka.clients.consumer.KafkaConsumer.subscribe(Ljava/ut https://blog.csdn.net/u010936936/article/details/77247075?locationNum=2&fps=1 最近在使用CD

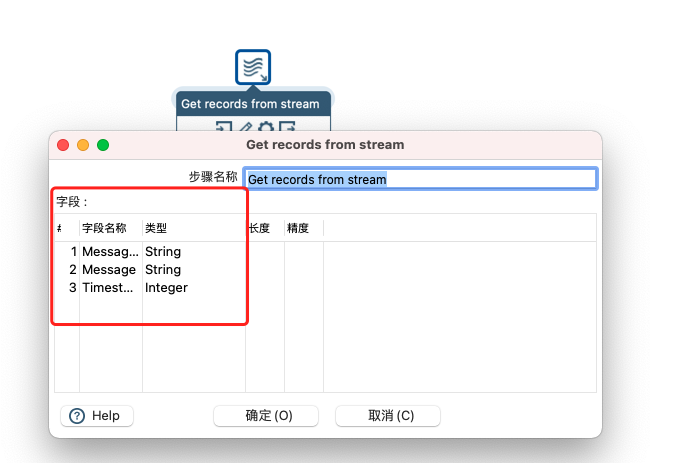

Kettle-ActiveMQ Consumer插件开发笔记

ActiveMQ Consumer插件开发笔记 源代码 https://github.com/tangwenixng/soyuan-activemq-plugin 概览 前提 该插件基于kettle 8.1.0.0-365 开发 如果是其他版本,不保证可用。(由于继承的BaseStreamingDialog等父类会随版本而变化) 本插件模仿官方Kafka插件源码编写:

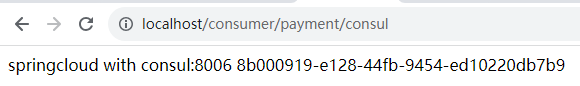

SpringCloud系列(19)--将服务消费者Consumer注册进Consul

前言:在上一章节中我们把服务提供者Provider注册进了Consul,而本章节则是关于如何将服务消费者Consumer注册进Consul 1、再次创建一个服务提供者模块,命名为consumerconsul-order80 (1)在父工程下新建模块 (2)选择模块的项目类型为Maven并选择模块要使用的JDK版本 (3)填写子模块的名称,然后点完成即可完成创建 效果图:

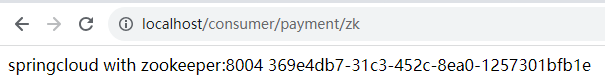

SpringCloud系列(17)--将服务消费者Consumer注册进Zookeeper

前言:在上一章节中我们把服务提供者Provider注册进了Zookeeper,而本章节则是关于如何将服务消费者Consumer注册进Zookeeper 1、再次创建一个服务提供者模块,命名为consumerzk-order80 (1)在父工程下新建模块 (2)选择模块的项目类型为Maven并选择模块要使用的JDK版本 (3)填写子模块的名称,然后点完成即可完成创建 效果图:

SpringCloud系列(9)--将服务消费者Consumer注册进Eureka Server

前言:上一章节我们介绍了如何将服务提供者注册进Eureka服务里,本章节则介绍如何将服务消费者Consumer注册进Eureka服务里 Eureka架构原理图 1、修改consumer-order80子模块的pom.xml文件,引入Eureka Clinet的依赖,然后reolad一下,下载依赖 例: <?xml version="1.0" encoding="UTF-8"?><

alpakka-kafka(2)-consumer

alpakka-kafka-consumer的功能描述很简单:向kafka订阅某些topic然后把读到的消息传给akka-streams做业务处理。在kafka-consumer的实现细节上,为了达到高可用、高吞吐的目的,topic又可用划分出多个分区partition。分区是分布在kafka集群节点broker上的。由于一个topic可能有多个partition,对应topic就会有多个c

Kafka Consumer APIs

Kafka 0.10.X 版本 及 之前 http://kafka.apache.org/0100/documentation.html#impl_consumer We have 2 levels of consumer APIs. The low-level "simple" API maintains a connection to a single broker and has

Kafka Consumer API 的使用

导读 Kafka具有两套消费者API:高级API、低级API。本文章将介绍两种API的区别以及使用时需要注意的地方。 低级API 1. 使用方法 find leader brokerbuild requestfetch dataidentify leader change 2. 为什么要find leader kafka在0.8版本后,引入replication机制。每个partiti

kafka Consumer high-level api 之白名单

Kafka提供了两套API给Consumer The high-level Consumer APIThe SimpleConsumer API 第一种高度抽象的Consumer API,它使用起来简单、方便,但是对于某些特殊的需求我们可能要用到第二种更底层的API,那么下面来介绍下第一种API: 使用白名单可以适配多个topic的情况。 示例代码: import jav

Kafka Consumer的底层API- SimpleConsumer

Kafka提供了两套API给Consumer The high-level Consumer APIThe SimpleConsumer API 第一种高度抽象的Consumer API,它使用起来简单、方便,但是对于某些特殊的需求我们可能要用到第二种更底层的API,那么先介绍下第二种API能够帮助我们做哪些事情 一个消息读取多次在一个处理过程中只消费Partition其中的一部

Kafka Consumer如何实现exactly once/at least once

目录 消费端幂等性消费时出现几种异常情况自动提交手动提交 精确一次消费实现总结 至少消费一次 消费端幂等性 kafka具有两种提交offset(消费偏移量)方式,在Kafka每个分区具备一offset记录消费位置,如果消费者一直处于正常的运行转态,那么offset将没有什么用处,因为正常消费时,consumer记录了本次消费的offset和下一次将要进行poll数据的offs