cogroup专题

Spark groupbykey和cogroup使用示例

groupByKey groupByKey([numTasks])是数据分组操作,在一个由(K,V)对组成的数据集上调用,返回一个(K,Seq[V])对的数据集。 val rdd0 = sc.parallelize(Array((1,1), (1,2) , (1,3) , (2,1) , (2,2) , (2,3)), 3) val rdd1 = rdd0.groupByKey() rdd1.co

Spark算子:RDD键值转换操作(4)–cogroup/join

cogroup 函数原型:最多可以组合4个RDD,可以通过partitioner和numsPartitions设置 def cogroup[W1, W2, W3](other1: RDD[(K, W1)], other2: RDD[(K, W2)], other3: RDD[(K, W3)], partitioner: Partitioner) :RDD[(K, (Iterable[V],

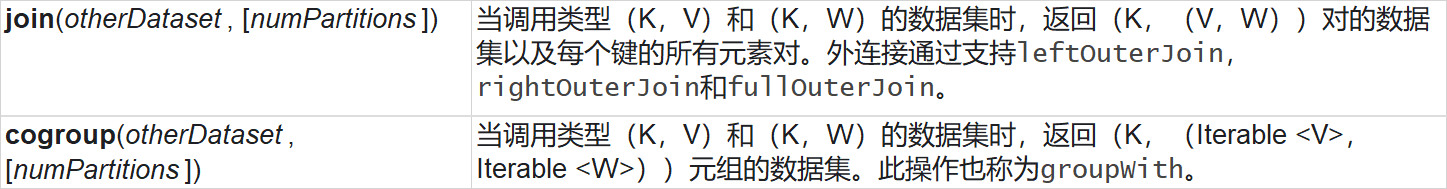

【Spark】Spark join()和cogroup()区别

官网对join和cogroup解释 示例代码: /*** join(otherDataSet,[numTasks])* 加入一个RDD,在一个(k,v)和(k,w)类型的dataSet上调用,返回一个(k,(v,w))的pair dataSet。*/def join(): Unit ={val list1RDD = sc.parallelize(List((1, "华山派"), (2, "武