cephfs专题

k8s cephfs(动态pvc)

官方参考文档:GitHub - ceph/ceph-csi at v3.9.0 测试版本 Ceph Version Ceph CSI Version Container Orchestrator Name Version Tested v17.2.7 v3.9.0 Kubernetes v1.25.6 安装Ceph-csi Step 1 Download GitHub -

Ubuntu 18.04.5 安装 Ceph mimic 13.2.10 CephFS 自动挂载

Ubuntu 18.04.5 安装 Ceph mimic 13.2.10 CephFS 自动挂载 1,CephFS 内核挂载2,CephFS 开机自动挂载 1,CephFS 内核挂载 查看key,保存到/etc/ceph/admin.secret ceph auth export client.admin 查看mon ceph mon dump 内核挂载 mount

分布式存储CephFS最佳实践

文章来源于知乎文章: 分布式存储CephFS最佳实践 背景 近日,一朋友说他们企业内部想落地CephFS,让我帮忙写一份能落地的CephFS最佳实践。然后就顺便把文章整理到了这里。因能力水平以及认知有限,如有错漏烦请指正。 简介 CephFS是Ceph项目的一个组成部分,它是一个高性能、可扩展的分布式文件系统,提供POSIX语义。它建立在Ceph的RADOS对象存储之上,通过Ceph

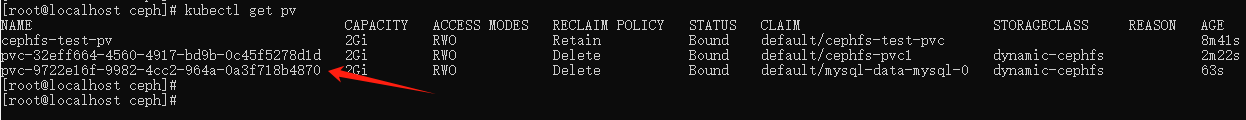

K8s 使用 CephFS 作为后端存储(静态供给、动态供给)

一、K8s 使用 CephFS CephFS是 Ceph 中基于RADOS(可扩展分布式对象存储)构建,通过将文件数据划分为对象并分布到集群中的多个存储节点上来实现高可用性和可扩展性。 首先所有 k8s 节点都需要安装 ceph-common 工具: yum -y install epel-release ceph-common 二、静态供给方式 静态供给方式需要提前创建好 CephF

cephfs snapshot mirror 调研

目的 测试实现 cephfs snapshot mirror 方法 实现两个集群 (CephFS) 实现数据同步 同步为异步方式 需求 主, 从 CephFS 集群 Ceph 必须满足 16 或上版本 主,从 Ceph 集群 fsid 不可以重复, CephFS 命名不可以重复 经测试,暂不支持 volume, subbolume 的数据同步 CephFS 环境 测试主要用于

Ceph实践总结之:CephFS客户端的配置

由于CephFS目前不算很稳定,可能更多的还是用在实验中。 在进行本章的操作之前,要先完成基本集群的搭建,请参考http://blog.csdn.net/eric_sunah/article/details/40862215 文件系统挂载的操作可以再虚拟机上进行,也可以在独立的物理机上执行,请不要在ceph集群中的机器上进行下面的操作 前期准备¶ 通过 OS Recommenda

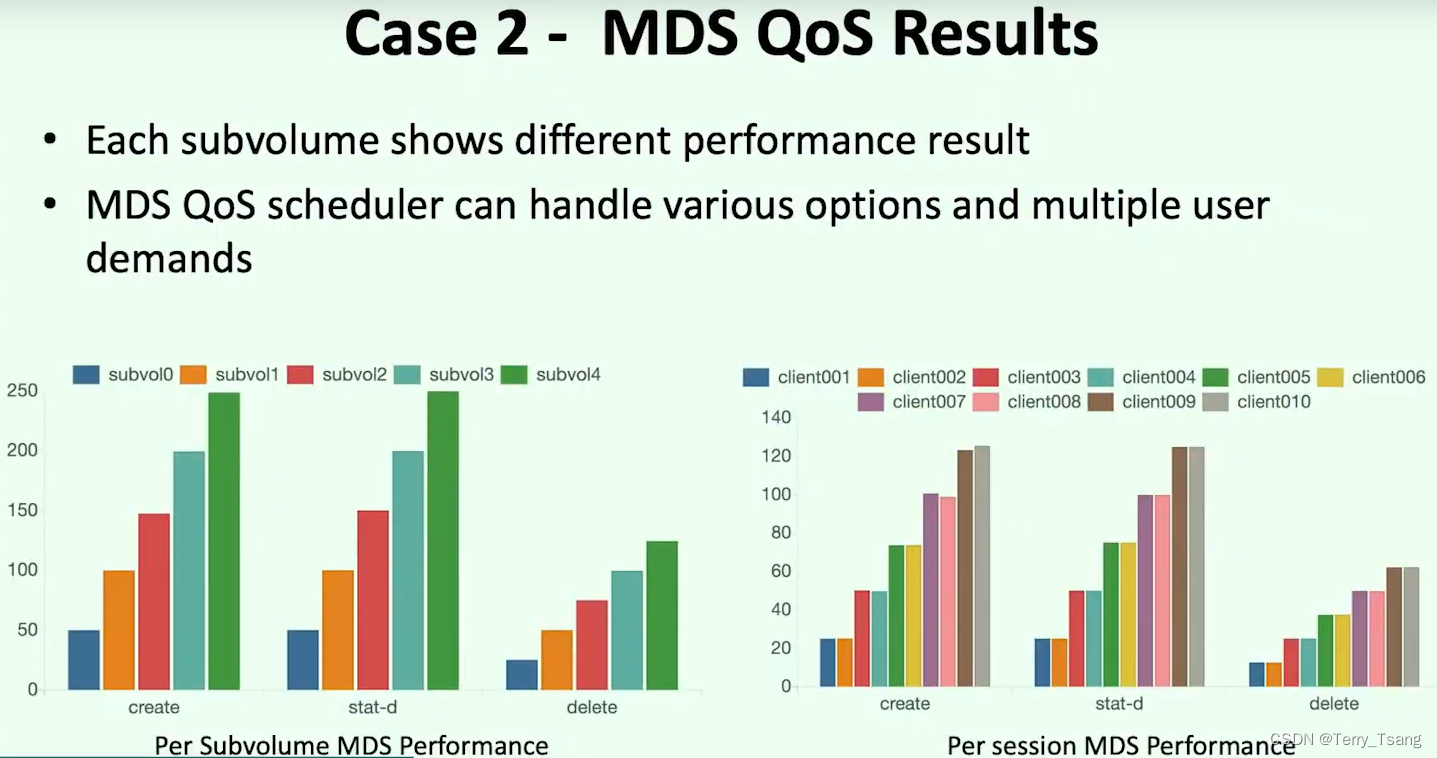

cephfs mds mclock qos scheduler

目标 了解 cephfs qos 方法 用于限制 cpehfs client QOS 等 capture 1 使用了 mclock 非 dmclock 2 qos 在 MDS 中进行限制 1 通过subvolume 进行设定 issue 关注 https://github.com/ceph/ceph/pull/52147

ceph的数据存储之路(11)----- cephfs 文件系统

2019独角兽企业重金招聘Python工程师标准>>> cephfs 文件系统 cephfs 文件系统的使用: 1.首先你要搭建一个ceph集群。如何搭建ceph集群在前面已经介绍过了。如果要使用cephfs文件系统,则必须要有管理文件元数据的mds节点。 2.在集群上创建文件系统, root@cephmon:~/ceph/ceph-0.94.2/src# ./ceph fs new

CephFS 常用命令以及问题分析

最近公司的生产环境已经开始使用 CephFS 作为文件系统存储,记录一下使用过程中遇到的问题,已经一些常用的命令。 1. 常用命令 1.1 ceph daemon mds.xxx help ceph daemon 是一个很常用的命令,可以用来查看 Ceph 的各个守护进程的状态,这个 help 命令可以看到 MDS daemon 都支持哪些子命令: $ sudo ceph daemon mds