bertpkd专题

12层的bert参数量_EMNLP 2019 | BERTPKD:一种基于PKD方法的BERT模型压缩

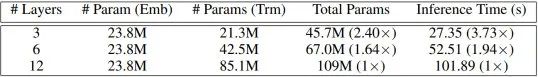

过去一年里,语言模型的研究有了许多突破性的进展,BERT、XLNet、RoBERTa等预训练语言模型作为特征提取器横扫各大NLP榜单。但这些模型的参数量也相当惊人,比如BERT-base有一亿零九百万参数,BERT-large的参数量则高达三亿三千万,从而导致模型的训练及推理速度过慢。本文提出了一种“耐心的知识蒸馏” (Patient Knowledge Distillation) 方法对模型