batchsize专题

Tensorflow 中train和test的batchsize不同时, 如何设置: tf.nn.conv2d_transpose

大家可能都知道, 在tensorflow中, 如果想实现测试时的batchsize大小随意设置, 那么在训练时, 输入的placeholder的shape应该设置为[None, H, W, C]. 具体代码如下所示: # Placeholders for input data and the targetsx_input = tf.placeholder(dtype=tf.float32, s

###好好好########学习率和batchsize如何影响模型的性能?

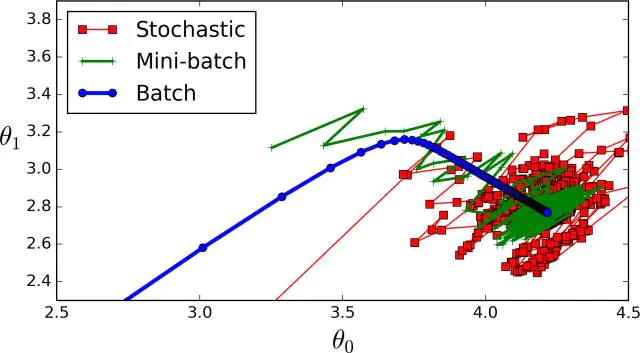

1 为什么说学习率和batchsize 目前深度学习模型多采用批量随机梯度下降算法进行优化,随机梯度下降算法的原理如下, n是批量大小(batchsize),η是学习率(learning rate)。可知道除了梯度本身,这两个因子直接决定了模型的权重更新,从优化本身来看它们是影响模型性能收敛最重要的参数。 学习率直接影响模型的收敛状态,batchsize则影响模型的泛化性能,两者又是

[nlp] epoch、batchsize、batchnumber、iterations

参考:https://blog.csdn.net/wills798/article/details/89326343 epoch 一个epoch是指 所有的数据 传入网络 完成一次前向计算以及反向传播的过程。 由于一个epoch常常太大,计算机无法负荷。 batch_size 所谓batch就是每次送入网络中训练的一部分数据, 而 batch_size 是 每个batch中训练样本

深度学习中Epoch,Batchsize,Iterations

Epoch,Batchsize,Iterations,这三个都是深度学习训练模型时经常遇到的概念。你一定有过这样的时刻,面对这几个词傻傻分不清楚,这三个概念究竟是什么,它们又有什么区别? 深度学习,梯度下降,Epoch,Batchsize,Iterations 深度学习中的Epoch,Batchsize,Iterations,都是什么意思 梯度下降法 一切的一切,要从机器学习中的

67、yolov8目标检测和旋转目标检测算法batchsize=1/6部署Atlas 200I DK A2开发板上

基本思想:需求部署yolov8目标检测和旋转目标检测算法部署atlas 200dk 开发板上 一、转换模型 链接: https://pan.baidu.com/s/1hJPX2QvybI4AGgeJKO6QgQ?pwd=q2s5 提取码: q2s5 from ultralytics import YOLO# Load a modelmodel = YOLO("yolov8s.yaml")

【神经网络】超参数 批大小batchsize 的理解

batchsize:一次训练的样本数目 对于图片数据,一般输入的数据格式为 (样本数,图片长,图片宽,通道数),样本数也就是批大小。 我对批大小的疑问在于:一个批次的数据前向传播后只得到一个cost/loss值, 它是由所有样本计算loss再求平均得到。那么一批中的图片都是不一样的,求的loss也不一样梯度也不一样,但是在神经网络中每一层都是只用一个梯度去更新,这样合理吗。 合理。因为求和求

![[nlp] epoch、batchsize、batchnumber、iterations](/front/images/it_default.jpg)