batches专题

Training - PyTorch Lightning 分布式训练的 global_step 参数 (accumulate_grad_batches)

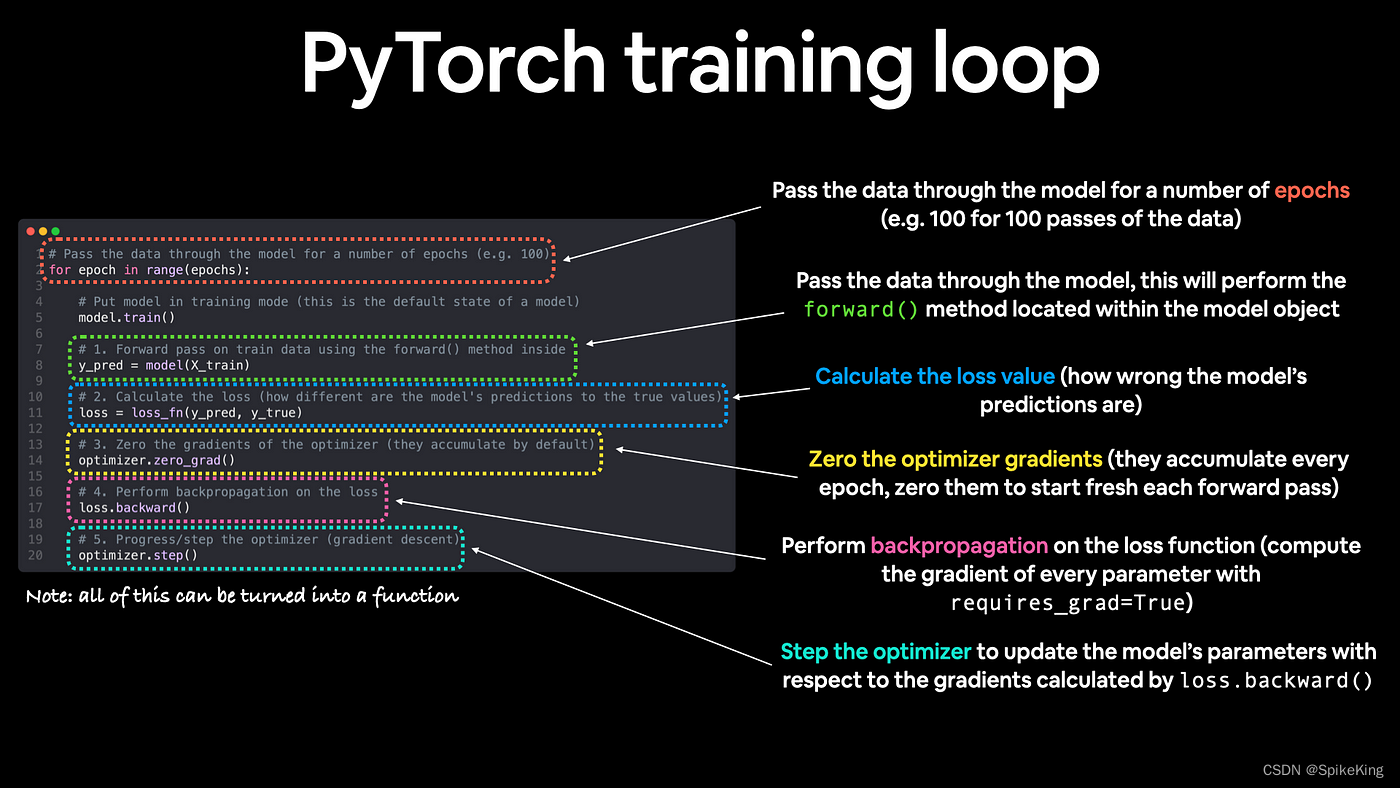

欢迎关注我的CSDN:https://spike.blog.csdn.net/ 本文地址:https://blog.csdn.net/caroline_wendy/article/details/137640653 在 PyTorch Lightning 中,pl.Trainer 的 accumulate_grad_batches 参数允许在执行反向传播和优化器步骤之前,累积多个批次的

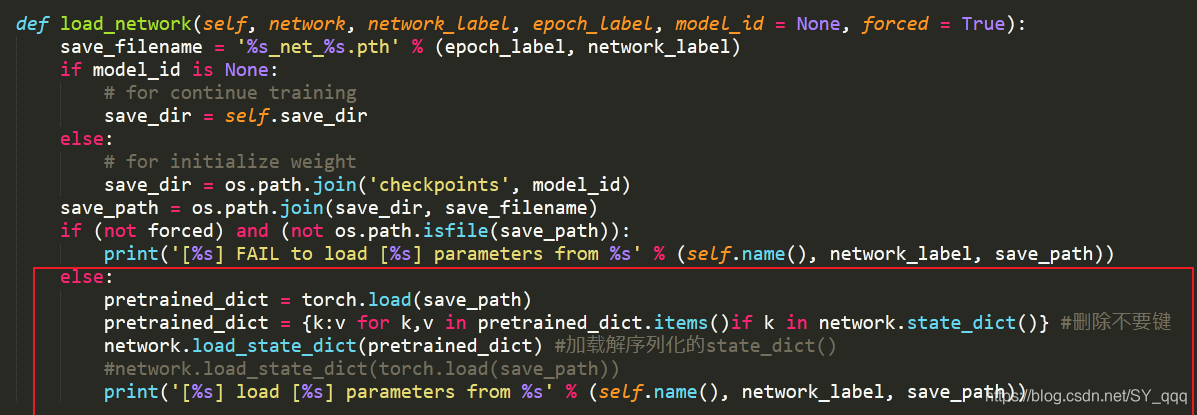

Error(s) in loading state_dict for XXX Unexpected key(s) in state_dict, 找不到num_batches_tracked

今天在训练的时候发现加载模型的时候提示找不到num_batches_tracked,感到奇怪,因为之前已经成功训练过一次了怎么这次就报错了呢,后来发现,第一次训练的时候我用的是0.4.0的pytorch,这次用的是1.0的Pytorch,因为torch的版本不一样引起的问题 KeyError: 'unexpected key "module.bn1.num_batches_tracked" in

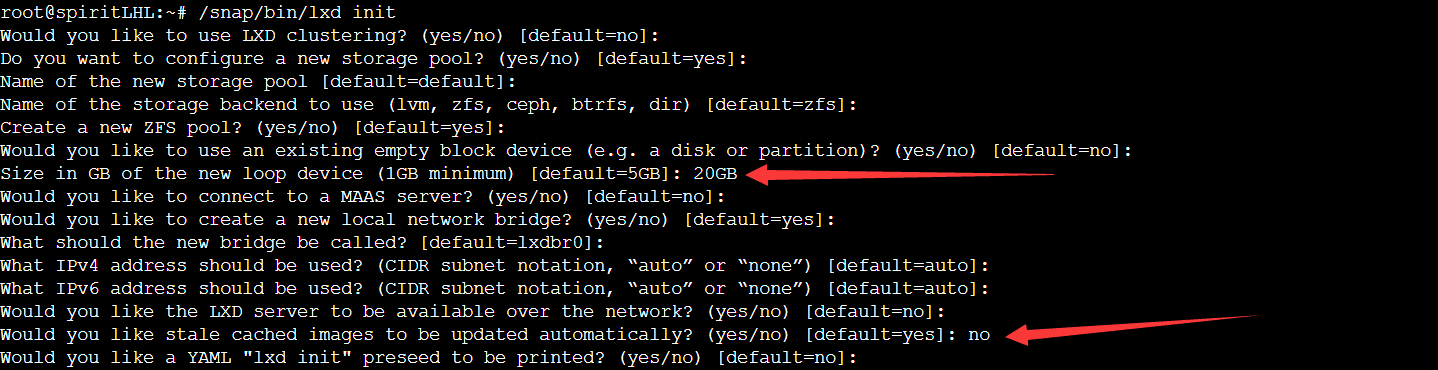

通过LXD/LXC命令批量或单独开设NAT服务器以及维护(简称母鸡开小鸡)(Set up NAT servers in batches or individually through LXD/LXC

lxc 原始仓库:https://github.com/spiritLHLS/lxc 更新时间:2023.01.15 待解决的问题 使得母鸡支持更多的系统版本 一键母鸡开小鸡 已设置同时进行TCP和UDP转发,除了SSH端口其他的映射内网外网端口一致,且只适用于Ubuntu或Debian 已设置支持开出的LXC容器进行docker嵌套虚拟 本套脚本开发使用的Ubuntu20,Ub